漫画「かぐや様は告らせたい」感想(前半) 早坂の世界がすさんでいるよ 【ネタバレあり】

こんばんは。

かぐや様は告らせたい 19巻の感想です。

ネタバレがあるのでご注意を。

画像は全て18巻、19巻より引用しております。

19巻。思えば遠くきたものです。管理人がかぐや様の面白さに気づいたのはどーんだYO、の回で面白さはあれどストーリーがどう展開するのか少し不安な面もありました。

生徒会の設定とか四宮家の設定とかありきたりなものがそろっていると不安になりませんか?(笑)学園もののチープなアニメを見て爆死しないでくれとはらはらしてしまうタイプです。

それがこんなに豊かな物語になるとは。

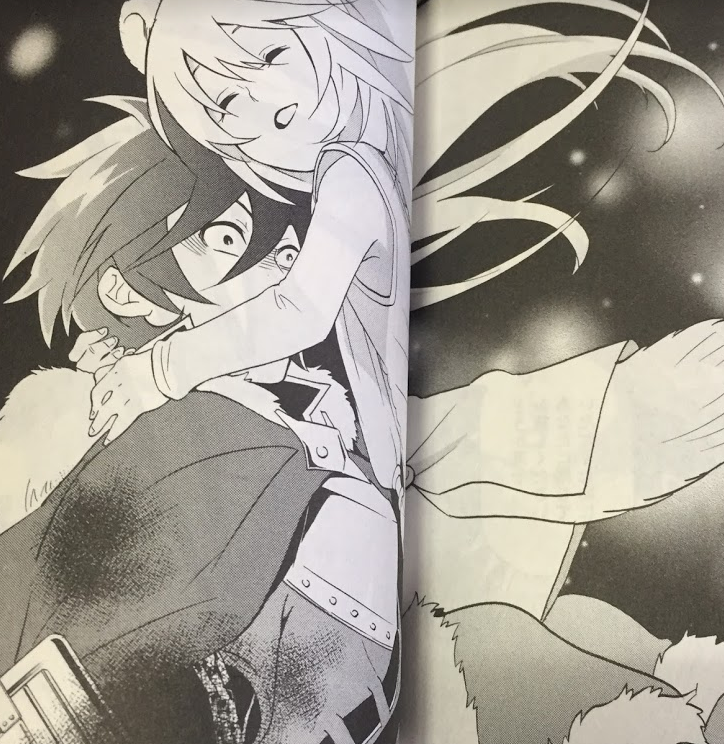

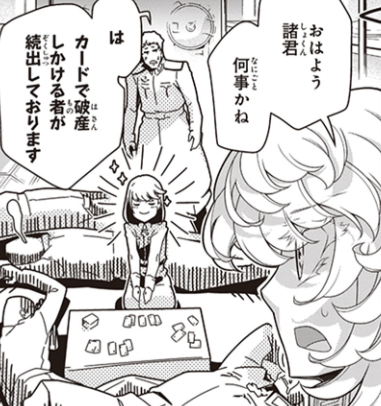

182話

いやー会長かっこいい。超かっこいい。

こんなにかっこいい主人公はラブコメでは珍しいですよね。ヒロインのかわいさが注目される本作品ですが、その魅力の根幹を担っているのは彼のかっこよさに拠るところが大きいでしょう。

彼のかっこよさは人を理解して上げられる受容性と彼自身の強さの2枚から来ているように思います。

受容性に関して。

ミコの生徒会選挙のときとか、石上の停学問題のときとか、かぐやの生徒会選挙再立候補のときとか、だいたい相手がほしかった言葉をかけてあげているんですよね。

”俺の青春ラブコメ~~”とかもそうでしたが、この作品は理想と現実のギャップやそれへの折りあいのつけ方、人間の善意と悪意、そういうものから生まれる閉塞感や醜悪さにフォーカスしているように感じます。

人間って追い風には気づかないんですよね。

でも逆風には気づくし、傷つくよね。みんな知らないんだろうけど。

そんな作品感です。

なにが言いたいかというと、彼女ら彼らはちょっとずれていて孤立していて、そうは言わないけど傷ついている。

そして、会長はそんな人たちに自己肯定の場を与える。会長凄い。

書いていて思ったんですが、やさしいだけじゃなくて甘いだけじゃなくて、ギャップに苦しんでいる人が間違っていないんだと言えるようになるだけの状況を強引に作り出せる腕力が会長にはある。

石上の「うるせぇばーか」はその象徴です。

たぶん石上はまだ傷ついているのですが、それでも彼はそれを知らないふりをして前に踏み出しました。

内発的に克己した石上のレベルまではいたらなくても、生徒会選挙後のミコの立場は絶対よくなっているでしょう。自他共に彼女を認める形で。

そして、その担保になっているのは会長の信念と実力なんだよなぁ。

あの会長が認めた、あの会長と対等に議論できた、そんな風に思われる会長だからこそ、彼から言葉をかけれらた人は救われるのです。

(ちなみに藤原書記も自信、信念、実績という意味では会長と同じかそれ以上のポテンシャルを持っているのにあの扱い(笑))

今回、彼が打ち抜いたのは早坂愛の壁でした。

早坂は有能で美人で、それらが武器になることを知っているのに自信ないパーソンです。自分は好かれるような人間ではないという自己嫌悪と、仕事だからかぐやを助けるんだというペルソナが彼女を縛ります。彼女は無償の愛を信じられません。

なのでヘルプサインに会長が気づいてあげてくれてよかった!!

前巻で身だしなみを整えながら泣いているのをみてすげーつらくなったので、会長がいてよかったなぁと思います。そのまま会長ルートいっていいんですよ?

早坂回と見せかけた会長回のようだった話でした。

最近デフォルメされたかぐや様が凄いかわいくかけるようになっている気がします。「四宮家のかぐやさん!?」

183話

早坂さんが周りからどう見られているか、早坂さんが周りをどう思っているか、というのが本筋ではありますが、結局のところ早坂は自分のことが嫌いなんだろうな、そんな悲しさがありました。

早坂って実は「彼女たちは友達ではない」「彼女たちは利用するだけの存在だ」そんなことはまったく言っていないんですよね。

ただただ、自分のような行いをする人間を周囲が好きになるわけがないといっており、これはもう自分は友達であるとえるような資格のある人間ではない、といっているのと同義ではないでしょうか。

なんとなく子供っぽいなとも思ってしまうのですが、彼女の悩みは深刻です。何しろ7歳くらいのときからやりたくないことを強制させられ続けているのですから。自分を嫌いになるには十分な動機と時間です。洗脳に近い。

トイレで取り押さえられそうになっていたときスカートがまくれあがっていましたが、後の話をみるにナイフを仕込んでいたんですよね。

旅行にナイフを仕込み、躊躇なくそれを出そうとする彼女の世界は本当に荒んでいます。上流階級は何でもありの世界観ですが、武器を所持している人間は彼女だけでは?うぅ、、、つらい。

でも我らが会長様はのたまいます。心を開けば、と。

一歩踏み出す勇気というのは作品共通のテーマです。早坂がんばれ!

184話

「そんな人は許されてはいけないんです」

友達が自分の秘密を他人に話してしまったと落ち込むかぐや(子供)にかけた早坂(子供)の言葉。うーむ。これって絶対自分に言っているよな。

ギャグシーンなのに重いんですけど。。。

会長は残念ながらぽんこつです。五等分の花嫁もそうでしたが、最近バイクがよく出てくる。

そして副会長もポンコツだぜ。全てのシーンが笑いになっているのですが、その空振りがかぐやに与える痛みを考えると笑えないです。

あの場所が分からないかぐや様

人身掌握に長けた?かぐやをして心の内側を見せないと称される早坂は少しかっこよい。

長くなってしまったので、分けます。

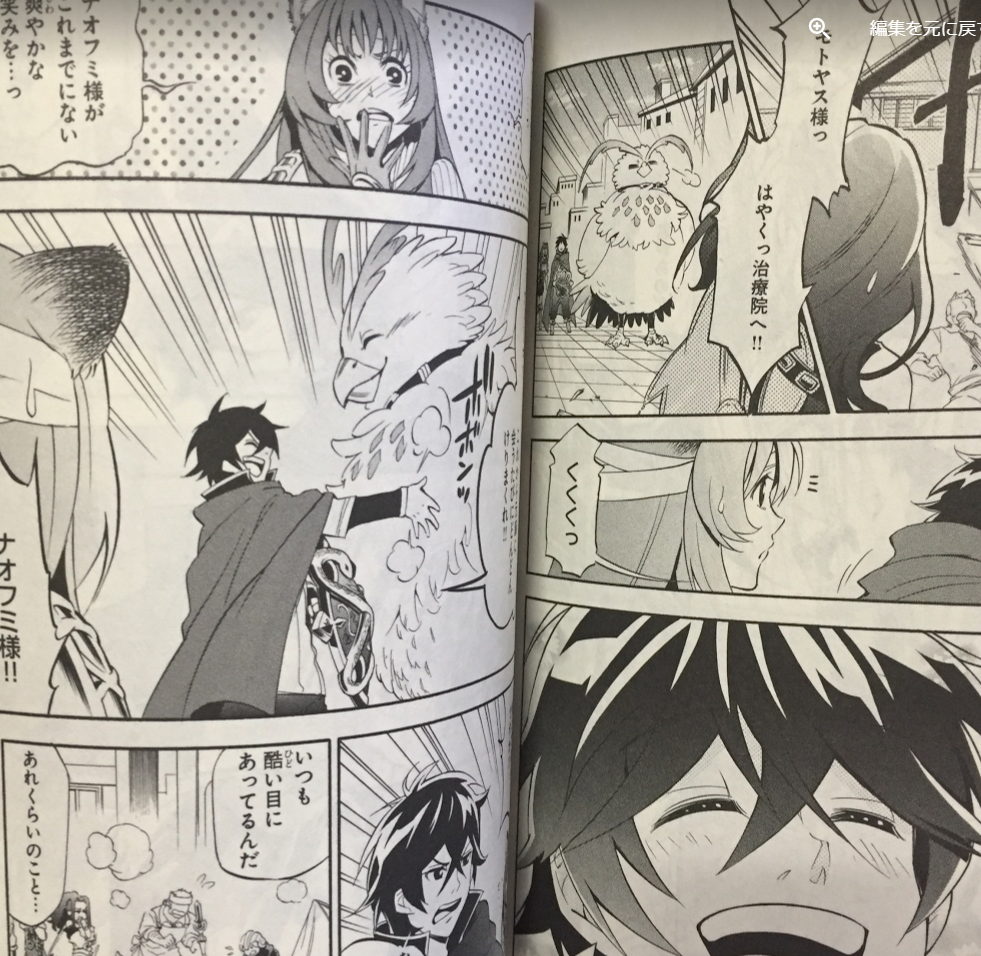

漫画「盾の勇者の成り上がり」1~4巻 感想 アニメの出来がよかったのは漫画がよかったからかな 【ネタバレ注意】

こんばんは。

コロナで外に行くのも何となく憚られる中、中身を知っているので買うまでもない漫画をツタヤで借りて読むことがおおくなってきました。

今回借りたのは「盾の勇者の成り上がり」です。

いわゆるなろう系、俺TUEEE系で、Audible化、アニメ化とメディアミックスに力を入れています。

特にアニメ化は日米同時展開ということで凄い力の入れようです。当初からアニメ2期までは放映が決まっていたようなのですが、3期も決まっているとのこと。凄い。

アニメは今回放送時期が発表されたSeason2に続き、第3期の制作決定も発表されています。

アニメは出来がよかったです。管理人はAudibleでだいたい読んだ?のですが、この作品は結構アクが強いんですよね。

ナオフミ様はひたすらイキっており、その他関係者はだいたい無能で、読んでいてうんざりしました。

この点、アニメはナオフミ様の精神年齢がより高めに改変されており、映像作品に集中することができました。

アニメを見たときは監督の手腕かなと思っていたのですが、その下敷きになったと思われるものを見つけました。

コミック版です。

原作で苦手な部分は上で挙げた部分にもいろいろあります。

たいしたことしていないのに商売上手として祭り上げられるとか、他の勇者が無能であることを示すためにボス戦闘がぐだぐだ長いとか、俺酒Tuee描写とかetc...

それを漫画版ではほぼカット or スルー。

もちろん上であげた要素を全て切り取ってしまってはもはや違うストーリーになってしまいます。しかし、漫画ではクドクない程度に、だけど原作既読者にもそれとわかる様にエッセンスを入れ込んでいるので驚くほどストレスフリーです。

そういえば、盾関連の設定もほとんど語られておらず、注目度の高い憤怒の盾関連しか描写されなかったような気がします。

アニメはきっと、この漫画の良改変から学ぶところがあったのだろうなと思いました。

ちなみにアニメが2019年の放映でコミック1巻が2014年出版です。

アニメ「盾の勇者の成り上がり」より

それがわかるのが後半のOPです。昔からぐりぐり動くOPが好きで、本作品のOPは凄く印象に残っていたのですが、OPと同じシーンが漫画にもありました。

(実は全部原作の挿絵が元になっている可能性もあります。小説は読んだことがないので確認できておりません。)

原作で薄くなった分、厚みをもった表現になっているのがナオフミパーティのちょっとした描写です。ちょっとしたギャグ描写の絵と仲の良さ感がマッチしていて結構好きです。

ちっこいラフタリア周り。

顔のデフォルメが好き。安い女扱い?に苦言を呈するラフタリア。

あったかそう。

槍さんの股間をぶっとばすフィーロをみてすっきりするナオフミ様。

裏表紙にはくだらないギャグが多めです。すばらしいオチがあるというわけではないのですがくすっとしてしまいますね。

ラノベは特に、ヒロインがかわいくて綺麗、くらいしか情報をつかみとれないことが多いのですが、ちょっとした描写を重ねることでヒロインたちの素顔が見えるような気もします。

現在16巻くらいまで出ているので、引き続き読み進めるのが楽しみです。

※カラーの画像以外は全てコミック1~4巻から引用しています。

漫画「SPYxFAMILY」感想 王道だけど予想を超えてくる 「ネタバレあり」

こんばんは、スパイファミリー5巻の感想です。

ねたばれ注意!

スパイファミリー5巻より

mission 24

ぼろぼろの手を隠すように帰ってきてすさんだ顔を見せるヨル、、、これは暗殺関係の仕事ですさんでしまったのか、、、

なんて思うわけあるかい!

ヨルさんが不器用なのは描かれていたのでメシまずいネタだとすぐにわかりました。そしてやはり来るメシまず描写。こういうお約束をはずさないのが本作品のいいところ。

今日びまずくて気絶なんてベタなことをする漫画ってないですし、くるぞくるぞくるぞキターって感じで笑ってしまいました。

弟君は吐きながら食べてるのが斬新でした。シスコン+料理まずいコンボってこんな感じになるんですね。

ラストは美味しい料理ができてフォージャー家がにっこり。こういうところもはずさなくてよい。絆って大事。

気になるのは、このヨルさんのすさんだ姿がシリアスシーンに使われることがくるんだろうな、というところでしょうか。今回は前ふりみたいなものだったというか。

人死にが出ることはないでしょうけど、ギャグで片付くのか、シリアス展開になるのか。どきどきです。

mission 25

学校パート。

珍しく”じなん”にフォーカスした話。いつも出てくるけど、彼の心情がかかれたことってあったかな。

執事とおもわれるジーブスのうそに気づきながらも何もいわずに決意を新たにするのかっこよくね??

これまであんまり何も思っていませんでしたが、すごく好印象な話でした。

mission 26

月に一回くるというと新月な気がしますが、エクリプスだと日蝕とか月蝕とかだったはず。アーニャが勘違いしているのかな?

いずれにせよ重大そうな設定出てきましたね。

よるさんの部屋着えぇなぁ。シスコンになっちゃうのは必然だぜ。ね(ハート)

というのは冗談として、弟君は結構努力家だったんだね。アーニャ回と見せかけて弟回なのかも。

勉強科目を間違えるアーニャ。「星をかけて!!」すごい勢いからの爆死かと思いきやここで終わりだったとは。

mission 27

フォージャーさんがテストを改ざんするために侵入、、、

みどころはそっちじゃなくて”じなん”とアーニャでした。じなん、えらい!よくやった。ちょっとうれしくなりました。

スパイファミリー5巻より

そしてアーニャがよかったですね。なんだかんだで赤点回避です。フォージャーさんの心を読んでフフンってするところが可愛かった。なんとなく大人びていて成長を感じさせます。

mission 28

会社がのっとられたと思ったら、協力的な買収だったジョージくん、、、気の毒やでぇ。

くれよんしんちゃんで風間君が同じことをしでかしていたのを思い出しました。この漫画はやるときは徹底的ですね。救いがない。

まぁスパイを雇って陥れようとしていたので自業自得かなぁ。

心が痛いけどみんなから冷たい目で見られているのは少し笑いました。彼はちょっと調子に乗りすぎました。笑

そして、じなんは結構気を使ってあげていましたね。ジョージくん文房具をあげたり。

mission 29

アーニャの職場体験。

スパイファミリーってほんわか家族漫画かと思いきや、本職パートではしっかりと裏家業しているのが面白いところですよね。

戦後の軍人のケアなど、語られている内容が思いのほかまじめで背筋がピリッと伸びるようなそんな印象を抱いてしまいます。

だからこそ、ギャグパートが輝いていて、スーパー弁明術で笑ってしまいました。

あと、ヨルさんから漂うサイコパス感。ちょっと怖い。アーニャもグロ体制が高くてびびる、、そんな血のにおいも本作の魅力でもありますが。

mission 30

冷たい女性スパイは、、、

すき、すぅきぃーー(ハート)(ハート)(ハート)

スパイファミリー5巻

いやーこの外さなさ凄いよいですね。フォージャーのことを憎からず思っているという展開は予想していたのですが、こんなにおおゴマを使うとは(笑)

王道をいって、予想を超えてくるのが凄い楽しいです。

だんこきょひ!!だったり、言葉のチョイスがよいですね。

フォージャーさんはスパイとしての態度はとりながらも、この環境に安らぎを覚えているようです。えぇ話やなぁ。

さて、どうなるのか。楽しみになってきた5巻でした。

本「ETFはこの7本を買いなさい」感想 投資に興味があるけどよくわからないという人に 読書記録

こんばんは。

この4月くらいから米国株への投資を始めました。

コロナで下がったのでチャンスかなと。

数日前の暴落でずいぶんと利幅は減りましたが、それでもETFは今のところちゃんと利益が出ています。

ETFを買ったきっかけとなった本が「ETFはこの7本を買いなさい」です。

以下、ネタバレ注意?(笑)

私は結構疑り深く、はめられるのを嫌うので、こういった本は避けがちでした。今回これをかったのは本当にたまたまでです。ブックオフで見つけた+ステイホームで暇だったからです。

これが意外とよかったです。

よかったポイントは下記ですね。

①著者はモーニングスターの社長であり、ちゃんとした出自感がある

②網羅性がある

③買うべき具体的な銘柄と理由が書いてある

④買うべき理由をデータで示している

⑤誇張している感じ、それにより利益を誘導している感じが見受けられない

⑥2017年に発売されたもの

①著者はモーニングスターの社長であり、ちゃんとした出自感がある

⑤誇張している感じ、それにより利益を誘導している感じが見受けられない

モーニングスターって聞いて事がなくて、うさんくさいなぁと思っていたのですが、後から調べてみると結構ちゃんとした情報サイトでした。

なんというかwikipediaみたいな感じ。深い情報をしるには足らないけど、ざっくり知るには適しているという感じでしょうか。

株業界は著者がよく知らない個人投資家だったり、証券マンだったりで、誰これって感じですし、たまたま成功した人を紹介されてもと思います。

その点、見やすいサイトを設計した会社の社長ならポイントの押さえているんだろうなという(比較的)信頼感を持ってよむことができました。

加えて、ぜひ自社サイトで購入してください!って感じでないのもよかった。何しろこの会社は販売していません。

ETFを検索する人が増えることでアクセス数がアップする狙いはあるのでしょうが、そのためには読者にとっていい情報を揃える必要があり、win-winの関係を築けます。

②網羅性がある

③買うべき具体的な銘柄と理由が書いてある

④買うべき理由をデータで示している

私はざっくりと広く知りたい派です。儲かるからこれを買えといわれても信用することはできません。

その点、この本は比較的多くのことが具体的な情報と共に書かれているのがよかったです。

この本はインデックスETFの購入を勧めているのですが、その理由はその商品の特性(手数料の低さ、値動き)だけが書かれているのではありません。

米国でどのような扱いを受けつつあるのか、なぜそうなったのか、という歴史的な経緯にまで触れられているのがよかったです。

世の中にはたまたま”今”よいものはあると思うのですが、それが続くとは限りません。それを自分の中で解釈するにはやはり過去の情報が必要だと思います。

⑥2017年に発売されたもの

ちょっと古いけど、古すぎない感じがよいですね。

なぜなら書いていることがあっているのか答えあわせができるからです。

現状の私の感想は、おおむね書いていることどおりにことがすすんでいる、です。

この本は基礎的なことしか書かれていないので、当たり間えっちゃ当たり前なのですが、それでもこの本を信じてとりあえずはじめてみようと思えました。

タイトルにも使いましたが、この本は投資に興味があるけどよく分からないという人におすすめの一冊です。

株式だけでなく、債券やポートフォリオの具体的な例を挙げ、自分の資金ならどうしたよいかも書かれているからです。

中古市場でも1000円弱で購入できますし。

とりあえずこの一冊だけ買ってみてはじめるというにも十分のように思います。

youtubeとかも凄くよいのですが、たくさんありますし、どうしてもそのときの流行に乗っかったものの情報も多く、バイアスがかかっています。

この本を一冊読んで、youtubeでひたすら情報収集というのがコスパがいいです。

【ファッション】ズボンはユニクロが好き

こんばんは。

ファッションって流行り廃りがあって面倒ですよね。かっこ悪くはみられたくない。

最近はユニクロのパンツばっかり履いています。2020年のユニクロメンズファッションおススメと言ったらコレですね。

EZYアンクルパンツ(ウールライク)

なんといってもケアしなくてもいいのが良い。洗濯してそのあと適当に干すだけなんですが、シワもつかないどころか常にハリがあるといっちゃえそうです。

形はスラックスをモデルにしていてきれい目なので、あとは適当にtシャツを着るだけで何となく整っているように見えるすごいやつです。

アンクル丈は今のトレンドにもあっているのも大きい。もうトレンドというかスタンダードになってきた感じもありますよね。

自分は運動の時にも使っちゃいます。

伸縮性がそんなにあるわけでもないので激しい運動には不向きですが、自転車に乗ってどっかいったりウォーキングするくらいなら十分できます。

このズボンが新発売されたのは2017くらいだったと思うのですが、その時はユニクロから安いスポーツウェアが出たぞ、くらいのノリでした。

検索ワードに登山とかが出ていた覚えがあります。

その時は凄く伸びる生地を使っていたんですよね。動きやすかったです。

今は生地が変わってしまいましたが、それでもこれで運動していると明らかにおかしいという感じもないですし、形に汎用性があるんだなと思っています。

運動の時にこれを着るメリットは適当に動いた先でお店に入りやすいこと。やっぱジャージで行くにはコンビ二が限界と考える中年男性です。

中年と書きましたが、どんな人にもだいたいあうだろうというのがおススメポイント一つでもあるなぁ。

20代、30代なら誰でも切れるし、40代だってアンクル丈が極端に短くならないくらいに気をつければ全然アリです。

ズボンはきれい目に細めに見える割りに太いパンツでもないので足が太めの方も切れちゃいますよね。

足が細くて、、って困ってる人もこのパンツならシルエットがきれいに見えるのでひょろい感じが出ないかな、と。

気をつけたいのはあんまり伸びないので座ると足首のところが捲り上がるところ。試着する時にあぐらを組んでどんな感じか納得してから買うのがおススメです。

あとはショートソックスを合わせたい。足首は積極的に出していきましょう。

暑いうちは!

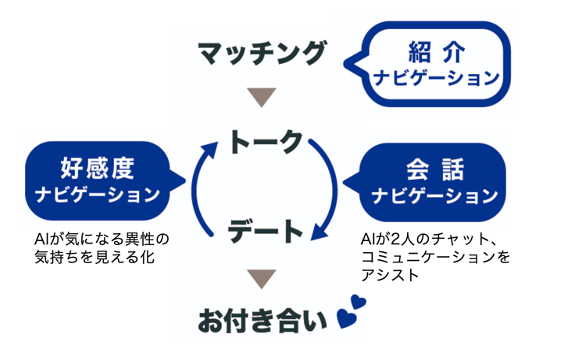

【出会いと婚活】愛は地球を救う Aillは婚活を救う

こんばんは。

最近、AIを使ったサービスを探すのにはまっています。自分もpythonを少しかじっているのでモチベーションになればな、と。

その中でもひときわ面白かったのはこちらの記事です。

AIを使った婚活(マッチング)アプリですね。信頼できる企業11社のみのサービスとしてトライアルをしたら凄い効果があったとのこと。

A.AIによるアシストの受入率62%、かつ全体の違反行為0%であった

B.チャット開通後1ヶ月以内でのデートへの進展率が、 AIナビゲーションがない場合に比べ4倍となった(8.3%⇒32.8%)

C.デートに誘った場合の受諾率が、AIナビゲーションがない場合に比べ8倍となった(10.3%⇒88.0%)

デート受諾率がなんと8倍です。AIの効果の大きさ凄くないですか?

もちろんデータの取り方でずいぶん結果が変わるはずなので、どこまで信頼できるのか?といった疑問はあります。

が、8倍というのは流石にどうあっても有意差なのではないでしょうか。

DLを使っているということなので、原理的にはデートがうまくいった会話を読み込む→それをみんなに共有していく、という感じではないでしょうか。

ここには重大な示唆が含まれています。これが本当ならスペック関係なしに「ちょっとした誘い方の違いだけで大きくその後の関係性が変わる」ということです。

AIが会話ナビゲーションをしても本来のスペックは変わらないはずですし。

婚活をするなかでうまいくかないと悩む人に出会うことが時々ありましたが、そういう人は友達の自分から見るとなぜだめなんだろう?と思う人ばかりでした。

めぐりあわせが悪かったのか、自分が知らないだけで高め狙いだったのか、あたりが原因かと思っていたのですが、そうではなくてちょっとした会話のもっていきかたの違いなのかもしれません。

どんなサービスなのかとても知りたいですが、会員である会社限定のクローズドな環境のようなので知りようがありません。

私がよんだ中でメッセージの使い方を丁寧にまとめてくれていたのは「もてるメール術」でしょうか。もはやメールなんて使いませんが、人に好感を持たれやすいコミュニケーションの方法が書かれた本です。

一時期はeブックオフ(オンラインショップ)でも品切れが続いていた本です。

モテる、とかくとあれですが、要は相手にストレスを与えずに返信をしてもらうにはどうしたらよいかということが書かれた本で、ビジネスにも応用できるように思います。20代の方で文章でのコミュニケーションが苦手な方は読む価値があり、です。

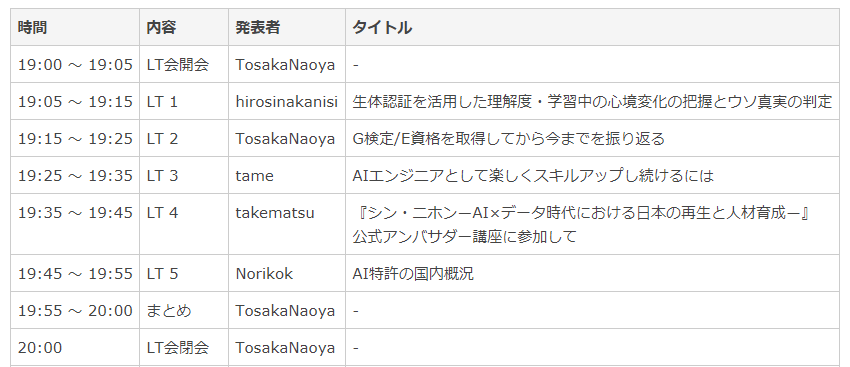

【G検定】CDLE LT#1 聴講時の雑感

こんばんは。

今日はG検定合格者が受けることができるCDLE LT#1に参加しました。

参加したといってもこのご時勢なのでwebセミナーです。公演時間はトータル1時間で、その間に4~5人が講師として発表してくれます。

聴講者はたぶん500人くらいいたのかな。

気になる発表内容は、勉強の仕方*2, 特許について*1, シン・ニホンという本について、の4本だてでした。

私も7月のG検定を受けたわけですが、1年前に検定を受けた人、あるいはもう少し技術レベルの高い人の勉強方法や情報収集の手段をシェアしてもらえるっていいですね。

特に情報収集ってこのサイトを見たらだいたいOKみたいなサイトを見つけることができるのかどうか、が重要であとは継続的に見るだけなので、自分もチェックしてみようかなと思います。

印象に残ったのは勉強量。正直そんなにいっぱい勉強できないなぁと感じてしまいました。自分も機械学習を触るのですが、結局SVRといくつかの手法を使えればだいたいなんとかなるんですよね。

一番のハードルは情報を持っている部署に情報を吐き出させるところで、AIの勉強してもここを超えない限りなんともならぬ。

とはいえ、そんなことをいっても状況は変わらないので、勉強は続けたいなと思います。動画がそのうち公開されると思うので、こちらでも紹介したいと思っています。

意外だったのは、この勉強の項目ではあまり質問がなかったのですが、特許の話では質問が相次いでいました。

内容的には初心者向けのものでメーカーで特許を書いている人間にとっては当たり前のないようだったのですが、新鋭のソフトウェアエンジニアはもしかしたらここらへんが穴なのかもしれませんね。

mixiとかニコニコ動画とか、結構凄い技術を早い段階で作り上げていますが、結局ビジネスとしては低空飛行なのとも関係があったりするのでしょうか。

最後は、シン・ニホンという本の紹介です。この本は凄く面白いのでビジネス書を読む人にはおすすめです。なんといってもデータが豊富!

日本のビジネス書ってエビデンス俺!みたいな自分が同じことをして再現するのだろうか?みたいな本が多いんですよね。なので外国で出版された厚めの本を読むことはあっても、日本の書籍は読みませんでした。

ただ、これだと日本の情報って少ないんですよね。日本で発売することを前提にしているな、と感じる本でも日本に割いたページは1割もあるかないか。

一方で、この本は日本人が書いた日本人のための本なので非常にわかりやすく、うすうす感じていたものがデータで示されたり、逆のパターンで意表をつかれたり、面白かったです。

メルカリでも定価-100円とかで売れるので本屋で買ってメルカリで売れば400円くらい(メルカリの手数料と送料)で2400円の本が読めるので新書を買う感覚で読めるのもいいところですね。(笑)

ラノベ「はたらく魔王さま」21巻 感想 ありがとう、でも凄い続きが気になるんですけど、、、【ネタバレあり・最終巻】

こんばんは、へるもです。

祝!はたらく魔王さま完結!

寂しいのは間違いありません。実は当ブログにおいて20巻の感想は人気なんですよね。それこそ月に何百も来てもらえるくらいです。

それだけ愛されているということで、そんな作品がひとつの終わりを迎えてしまう、というのはなんだかちょっともったいない気もします。

ただ、長く連載が続けられて、アニメ化もされて(管理人はアニメ組)、完結を迎えられるというのはかなり贅沢な話ですよね。そこはちょっと嬉しいかな。

以降、ネタバレありの感想です。ご注意ください。

はたらく魔王さま 21巻

ぱっと振り返っての感想、もといヒロイントーク

エミリアーー!!

#はたらく魔王さま 最終巻読了

— 社会人はリラックスしたい (@kapVpjzVyO8N5Fl) 2020年8月9日

エミリア、、、エミリアーーーー!!

やっぱりはずせないのはエミリアのあれこれですよね。

はたらく魔王さま最終巻発売日まであと2週間か...

— サイヤ人の王子 (@SAIYA164) July 27, 2020

前巻はあと2.3巻は続きそうな流れだったのに驚いたなぁ

最近は主人公であるはずの魔王と恵美が全く活躍してなかったからラストで一気に活躍するのかと思ったけどやっぱ最後まで千穂無双が続くのかなぁ...

作品の流れ的には千穂エンドまっしぐらで、20巻での同居イベントが最後の打ち上げ花火か?(ヒロイン的な見せ場)と思っていたのですが、きっちりと描いてくれました。

軍人エミリア

はたらく魔王さま 21巻

エミリアの何がいいってすっげぇ優しい上にpractical(実践的)なの。エミリアさんの助け方って。魔王が具合悪いの察してタクシーで送ってきてくれたり、様子を見るために添い寝してくれたり(語弊)、おじや作ってくれたり、、、

作中では(主に金とヒロイン関係で)ぼろくそにいわれたりすることもある魔王ですが、彼って結構格の高い存在なんですよね。スキル的な意味で。そんな彼を助けるというのは至難の業です。

だってだいたい助ける必要がないんだもの。放っておいてくれてもなんとかやっていけますよ?ってな感じ。

ただ、それは彼が自立していると振舞えるってだけで、別に完全無欠の人物ではないんですよね。体裁は取り繕えるけど、本当につらいときに辛いはあるし、だけどそうとは言わない。言えない。それが彼です。

そして魔王が取り繕った体裁を掬い取って、目的を果たすまで待って、力尽きた後に助けてあげられるのが今回の彼女の役割でした。作中で一番進歩したのは彼女かもしれません。

目標は最優先、その後は生き残るために護送して治療して、と必要最低限かつ効果的なものを施すエミリアの姿はいかにも元勇者(軍人)っぽくてかっこいいな、と思いました。

助けておじやを作るというヒロイン力を見せた恵美のイベントはこれで終了かなと思っていたのですが、、、、

ホーリービタン

はたらく魔王さま 21巻

!!!!

まじかぁ。エミリアまじかぁ。やるなぁ。

魔力を得るためとかいってますけど、それ口移しの必要あったんですか??ホーリービタンが含んでいる聖法気量なんてたいしたことないでしょう?

キスしてみたかっただけでしょう??

うーむ、強い。ヒロイン力強い。慌てふためいたりしていないのが凄くよいですよね。彼女はどこかの段階ですると決めていたんでしょう。実際、彼女が倫理的に問題なく勢いに任せて攻めるにはこのタイミングしかなく、エミリアはそこにばっちり合わせてきました。

そして、彼女の攻めが発動したのは魔王が目を覚ましてから。

魔王の寝込みを襲って体力回復させて→(魔王)「なんだか体が軽くなったような、、、そういえば夢見心地で柔らかいものを、、、」なんて鈍感系?な対応は許しませんでした。

彼女のキスは魔王が認識できる範囲で。

もちろん、エミリアには略奪愛なんて発想はなかったと思います。アラス・ラムスの父母問題は彼女の意思を後押ししていたはずですが、ここの行動はなくてもよかったはずです。むしろ、今後のことを考えるとないほうがよかった。

それでも関係性が固定化されてしまう前に、最終決戦の前に、なおかつ想い人の心を揺らせるように、勝負を仕掛けた彼女のいじらしさには胸をうたれるものがありました。

(勇者エミリアのダークサイドが示された部分でもあるのでそれについて考えてみるのも一興かも。背徳的な意味で(笑))

エメラダ

ちなみに彼女がキスの言い訳に使ったホーリービタンはエメラダからの援助物資です。エメラダwオウンゴールwwって気分でしたね。(笑)21巻ではエメラダについて触れられることは多くはありませんでしたが、エメラダについて語らずにはいられません。

エメラダってエミリアの健やかな成長に凄く貢献したと思っています。

生物兵器とか少年兵とか、非人道的な扱いを受けたようにも見える勇者エミリアがまっとうな人間性をもてたのは彼女のおかげなんでしょう。少なくとも作中で積極的にエミリアを保護したのは彼女だけです。

いわば、「エミリアは私が育てた」。

20巻でエメラダが魔王に対して敵愾心を見せたのは、エミリアが魔王に惹かれていることに気づいており、だけど、魔王はエミリアを”道を踏み外してもおかしくない状況”に陥れた存在であるという矛盾を消化し切れなかったからではないでしょうか。

ただ、子供って大人が思っているより大人で、自分なりにものごとを決めることができて、完全に制御できないものなんですよね、、、きっと。

エミリアを守るためのアイテムが、エメラダのいってほしくない方向に使用されたのはその象徴のようです。このシーンは保護者たるエメラダからの巣立ちであり、彼女の物語(with 保護者エメラダ)が彼女だけの物語になったのかなーと思いました。

完全に妄想ですけどね。

ストーリーテラーは何者か

さて、本編のストーリーに主軸をうつします。結構、、、結構壮大なストーリーでしたよね。

セフィロトが選ぶ人類は一種。異なる惑星からの異邦者(イグノラなどの天使勢力)か、エンテイスラの人間や魔族たちか?

数で勝る人間たちに対抗するために策を打つイグノラ(急進派・上位存在になりたい)、イグノラに対抗するライラ(穏健派)、イグノラがやりすぎてどんびきするガブリエル(急進派の裏切り者)、それぞれに思惑があるセフィロトの子供たち。

介入されている側のエンテイスラ側の政治もあって、事情が複雑すぎ、登場人物が多すぎてわけがわからなくなってしまいそうです。よくもまー着地させたな。

個人的にはイグノラが宗教機構で人間の意識を支配しようとするも、その宗教機構の一部を書き換えて対抗したりするあたりは結構あつくて好きです。

あと、イグノラもライラも子供放置プレイに走るという点は共通で、二人のストーリーテラーの勝敗を分けたのは子供とどれだけ早急に和解できたかという部分もよい。ストーリーテラーであれど、母という属性があったということですね。

ここらへんは魔王だけどフリーター、人間の女子高生だけど異世界の救世主?、あたりのギャップに通じるものがあって面白いですね。

日本の話なのか異世界の話なのか

はたらく魔王様は両者の話ではあったんですけど、メインストーリーはほとんど理解していませんでした。どんどん新しい人や展開が出てくるので繋がらないんですよね。

キナンナの介護をし始めたときはさすがに投げ出しそうになりました。

ただ、それでも読めたのは、ヒロインに魅力が大きかったのが大きく。そういう意味では単純にボーイミーツガールの話だったと捉えるべきかもしれません。神や天使の話ではなくてね。

先発ちーちゃん、リリーフ鈴乃、遅れてきたエースのエミリアに、抑えのちーちゃん(!)

千穂

https://twitter.com/ryozi178/status/1291684219668713472

やはり、千穂エンド。

収まってみるとこうなるしかないなという終わり方でした。 普通に考えたらそうなりますよね。

真奥が千穂を振る理由が思いつきませんし、エミリアを選ぶ理由も思いつきません。あるとしたらエンテイスラと自由に行き来できなくなるエンドでしたが、21巻はもろともエピローグでその選択は否定されていました。(21巻の最初のほうから交流している姿がうかがえる)

ってか、ちーちゃんの健気さとかを考えると、真奥がほかにいくとないわーって感じですよね。

ただ、なんとなく自分の中では千穂<エミリアだというのを感じていて、それはなぜかと考えたのですが、彼女はずっと真奥のことが好きだったからだろうというのがひとつ、彼女の変化に読者がついていけなかったのがもうひとつだろうな。

たぶん人間って物事を相対値でしか見れないんですよね。

前は嫌われていたけど、今はすかれているという状況なら、好意の上昇分があるのでそこにヒロインとしての魅力を感じれるのですが、ちーちゃんは最初から好意maxで、その状況は変わりません。

じゃぁ20巻で何が変わっていったのかというと、”社会との関わり方”。1巻でヒロインしてた巨乳妹系後輩がエンテイスラで立身出世していったぜ、、、

(なろう系主人公といわれたり)

魔王やエミリアが日本で生活拠点を得ていった対比として、ちーちゃんは異世界での立場をえているようで、完全にもう一人の主人公ってかアナザーサイドストーリー。なんなら魔王より出世してるよ。

つまり読者的には好意レベルが上下動せず、一方で社会での影響力を増していくちーちゃんはヒロインじゃなかったのではないか、というのが管理人の意見です。

指輪関連で病院送りになったときあたりはまだヒロインらしさがあったのですが。

(女性の社会進出が望まれる現代社会ですから、こういうラノベヒロインもありなのかなーと思います。)

ただ、そうはいっても器がおおきなった末に一夫多妻制を推すちーちゃんは面白かったです。もうちょっと早い段階で一夫多妻容認派を作ってエミリアをからかったりしても面白かったのでは?

ただ、そういうキャラって正規ヒロインの立場がちょっと怪しくなっちゃうしな、、難しい。

鈴乃

鈴乃はなーやはりこうなってしまったか。

彼女は良心的である”だけではなかった”エミリアの映し鏡ですかね?

よき理解者、思慕者、実力者。ほしいものを欲しいといい続けないと、欲しいものが手に入らない世の中の無常。

ただ、彼女はほかのヒロインに比べて大人であることが求められる立ち位置だった(見識にしろ、年齢にしろ)のでしょうがないかな、とも。

戦闘面では割と強いけど強いやつには負けてしまう、諜報組織のボスとして優秀、政治屋としては基本的に優秀だけど経験が少なくて連携に手落ちがあったり、という基本的に有能だけど得意不得意のある人間くささのバランス感がすきだったのでちょっと悲しいです。

はたらく魔王さま 21巻

ってか一夫多妻制に鈴乃を入れるのはだめなのだろうか?

うどんやお遍路を楽しむのはいいのですが、挙動がいきおく、、、。まぁ彼女はいいところの生まれで童顔なのでどうにでもなるのかな?

彼女は戦争時代に汚れ仕事を担っていたしんどい立場の人間なのでもう少し救いがあればうれしかったかな?まーみんながみんないい感じになるわけではないよね。って感じでしょうか。

エピローグの21巻

読み始めておやっと思った人は多いのではないでしょうか。何しろ、20巻時点では話がまとまる感じなんてほとんどなくて、それがいきなりサリエル@専業主夫ですからね。最終決戦おわっているやん。

20巻が出たのは1年以上前なので、もしかしたら苦悩の1年だったのかもしれません。鈴木リカの裏ストーリーとか明らかに重いし、㈱まおう組と芦屋のストーリーと一緒に本編に組み込まれる計画とかあったのではないでしょうか?

つまり、もう少し長くなる予定があったのでは?

真偽はわかりませんが、私はまるまる21巻をエピローグのようにしてくれたのはよかったなと思います。

最終決戦は私はどうでもよくて(どうでもよいわけではないですけど)、明確にわくわくできるのって真奥や恵美が日本で?エンテイスラで?どう生きるのか?っていうところなんですよね。

普通のラノベだったら最終決戦のあとに一章を使って、ついでかのように後の生活を書くと思うのですが、それだけだと物足りないなと思っています。終わりに向けて気持ちが付いていかないというか。

はたらく魔王さまは最終決戦とその後の話がいったり来たりするなかでいろんな関係性が見えてきたりして、あの世界でキャラクターたちがどう動いているかというのが見えるのがよかったです。

一巻まるまる使ってくれたおかげで話を読み終えたときのやりばのない虚しさみたいなのもあんまりなく、晴れ晴れとした気分。

これからも何となく読み返したくなっちゃいますね。

はたらくまおう様とはなんだったのか

この作品は凄く珍しい形だったな、と思います。ラノベはずいぶんとよんできましたが、現代日本をこうもラノベに移植した作品はなかったように思います。

特に00年代は日本をベースにした学園ラノベがたくさんでてきたのですが、そこで描写されてきたのは子供の目線か、プロすぎるプロの目線(お仕事系とかSFででてくる警察とか)でした。

よくも悪くも、作品やその物語のために、現代日本の一部を切り取って再利用している感じでしょうか。

はたらくまおうさまでは、ちょっとニュアンスが違いましたよね。

生活の糧をえるためにバイトをしたり、仕事に遅れるからと世界からの闖入者を待たせたり、物語のストーリー進行の上で”仕事の穴”をあけないために立ち振る舞ったり。

この作品は、物語内に現代日本を再現しようとしていたのだなと思います。

はたらく魔王さま最終巻読み終わった

— Midori (@Midori_160122) 2020年8月9日

なんだろう、すごい虚無感を感じる

やっぱ自分の好きな作品が終わるってのはかなりつらいんだな…#はたらく魔王さま pic.twitter.com/jeo1q2kMMf

この按配ははたらくまおうさまの刊行とともに大学生→社会人となり上京した私にとっては既視感のあるものでした。

真奥や恵美にはなんとなく共感を感じ、なんなら凄く親しいわけではないけど会えば話はするくらいの友達のような気もして、作品の終了はとりわけ寂しく感じます。

まとめ

はたらく魔王さま 21巻

最終決戦で人死にでるかも!みたいな緊迫感を期待していた人にはちょっとあれだったかもしれませんが、大満足な21巻でした。

およそ10年くらい、ありがとうございました!

【G検定】日本ディープラーニング協会さん検定料を半額にして集めた受験者をなぎ払う? G検定の取得はしばらく様子見のほうがいいのでは

こんばんは、へるもです。

7/4にG検定という資格試験を受験しました。というのも、今回はstay homeに伴ってできた時間を勉強に当ててくださいということで、受験料が半額(12,000→6,000)だったんですよね。

結論

#G検定

— 社会人はリラックスしたい (@kapVpjzVyO8N5Fl) 2020年7月4日

AIなどを勉強したい人が取っ掛かりとして受験するようなものだったけど、ずいぶんと傾向が変わった印象。

仕事で機械学習を使ってるけどこんな内容までしらなくてもできる。ゼネラリストを粋を超えて雑学王方向に舵が切られている。

テキストとの乖離も多く、後輩にはお薦めできないな

2020年に入りG検定の出題傾向が大きく変わりました。

色々といわれていますが、テキストとの乖離が大きい点、今のG検定をとるために勉強してもビジネスには役に立たない点からG検定取得はおすすめしません。

出題範囲はこの中からですよ、という本が出たりしたらありかなと思います。

代わりに、study-AIの模試(無料)を解いて分からないことを勉強して、関連の書籍を何度も読むのが一番かと思います。 書籍についてのお奨めは最後のほうに書いておきます。

そこだけが知りたい方はお手数ですが、れっつスクロール!

挑戦者たち

G検定には興味があったのですが、これまでは受験していませんでした。

こういう資格は、それを取る過程で勉強することが役に立つことはあっても、資格自体はあまり意味がないのが常です。1万円を超えるなら受講はしなくてもよいなかなぁと思っていました。

が、今回はなぜか受験料が半額になるということだったので、それならやってみるかと思いました。

🎉7/4(土) #G検定 2020#2の受験申込者数が1万人を突破‼

— 日本ディープラーニング協会(JDLA) (@JDLANews) June 23, 2020

7/23(木)開催の「合格者の会」では #JDLA 理事長の松尾豊東京大学大学院教授から合格者の皆様に特別講義を行います。今回の試験に合格される方も含まれます🤗

🔻G検定2020#2の受験申込締切は6/26(金)https://t.co/xR8CWXd281#今こそ学ぼう

同じように考える人も多いようで、これまでの受験者数が2.2万人に対して、今回だけで1万人以上でした。直近と比べても2倍くらいの人が受験していそうですね。

内容と想定された難易度

そもそもG検定とは何ぞや?という部分では、日本ディープラーニング協会(JDLA)が使っている表現を使うと下みたいな感じです。

「ディープラーニングに関する知識を有し、事業活用する人材(ジェネラリスト)」

「知識を体系化し、ビジネスでの活用へ」

AIというとプログラミングが必須な技術分野の話にも聞こえてしまいますが、実際にはそれをどこに使うか?ということを考えたり、法律的な問題をクリアしないといけません。

G検定というのはそういった周辺知識を持ちビジネスに役立てることができる人材(=ゼネラリスト)であることを認定するための試験だ、というのが私の解釈でした。

実際、G検定の公式テキスト(通称、白本)にはプログラミング要素はまったく出てこず、AI研究の歴史や重要人物、AIで何ができるか?という部分が記載されているにとどまります。

難易度

事前に調べたところによると、それほど難しくないようでした。

白本をみてもそれほど量がありませんし、評判のいい対策試験集(studyAIから出ている本、通称黒本)もきちんと勉強したら簡単に90%の正答率がとれます。

実際、中には一週間で合格したという人もいますし、落ちた人の記事でも、落ちた理由に「ろくに勉強していない」が堂々と書かれるくらいです。

もっとマシな理由はなかったのか、、、!

ここから想定されたG検定の立ち位置は、資格自体には意味がないけど、AIについてさらっと学習できる、というところでした。

本番

難しい!!

想定異常の難易度に試験終了直後からついったーは阿鼻叫喚という感じでした。

今回のG検定むずかしすぎない??教科書や問題集のほとんどでないし。知識問題より判断問題ばかりだし。

— monster_yokohama (@blueseacraft) July 4, 2020

今回半額の6000円だったから、受験者落としてまた受けさせようって作戦か。。。#G検定

私も白本、黒本の正答率を90%に上げた上で、AI白書も一読して臨んだのですが、普通に難しかったです。絶対に落ちたというほどではありませんが、不合格というのは普通にありえます。

雑感

模試などと比較して、これまでと違うのは3(4)点だと感じます。

・自動運転、ドローン、著作権など法律系の問題が増えた

・強化学習など、より細かい部分が出題されるようになった

・同じ問題でも表現が違う言葉を使うようになった

(・人名などがほとんど出なかった)

特に法律系が出題されるという部分に関しては、この傾向は2020年に入ってからずっと続いているようです。

とうとう明日がJDLA G検定ですね。

— KEI@シミュレーションの世界に引きこもる (@KeiKei47585517) July 3, 2020

参考にまとめ記事をどうぞと言いたいところですが、

法規関連にご要注意下さい。

2020#1の時は以下をきっちり押さえておけばよかったと感じています。

・個人情報保護。

・匿名加工。

・自動運転。

・著作権。

・ドローン飛行規制。

・道路交通法改正。#G検定 https://t.co/c3NugblMar

チートシート過学習に注意です!

— 社会人はリラックスしたい (@kapVpjzVyO8N5Fl) 2020年7月4日

政策やプライバシー保護、自動運転などの最新動向を抑えておいたほうがよいです。

どうしたらいいのかはあれですが、、

私もこれを見てある程度対策していたつもりだったのですが、想定より法律系の問題が多いし、細かすぎました。具体例をあげて説明できればよいのですが、検索で必死だったために覚えていません。(笑)

#G検定

— もふ@P.T.A. (@nori_umashi) July 4, 2020

試験中「知らんがな」連発…疲れた…

歴史系の問題があまり出ず現代の問題が多かったけど、これからA I人材を増やすにはそりゃそうだよね、だってどんどん変化してるんだもんね、と納得。

だからこそ、せっかくテキスト出すならそういう「これから必要」な部分を多くした方が良いと思う。

振り返ってみてもテキストと内容の乖離がやはり一番の「なんだそれ」という理不尽ポイントですね。テキストにないものは記憶にもないので、検索して答えを探すしかありません。

AI界隈の能力を測定する検定というより、グーグルでいかに早く答えを見つけるかの検索力と読解力を測定されているのでは、、?もっと言えば打ち込まれたキーワードの意図をよむ”グーグル検索の能力"をこちらがテストしているようですらありました。

JDLAの意図とは?

そもそも傾向がかわったのかすらわかりませんが、傾向が変わったという前提に立つと、JDLAの意図とはやはり最新情報を知っているのかという部分を測定したかったのかなと思います。

整備されていなかった法律がどんどん形になってきている段階ですし、さらにAIというかITの世界は他の業界に比べても明らかに進歩が早いです。

こういうところにも対応しているべき!というのが出題者の意図だったのでしょう。

もしかすると、JDLA2021公認動画みたいな感じで、各会社が動画を売ってその中に最新動向を含めるようになったりするのかもしれません。G検定を受けるならこの動画みないと合格しないよ形式ですね。

結構細かいので動画にするのにコスパがあうのかという問題もありますが(笑)

G検定の受検はしばらくお奨めできない

まだ合否判定が出ていない段階なのですが、受験をしてみて思ったのはG検定はお金と時間の無駄だなというところです。

色々な人が似たようなことをいっているけど、G検定を勉強して仕事とか社会の役に立つようなところが想像できないのが一番痛いところ。

— 社会人はリラックスしたい (@kapVpjzVyO8N5Fl) 2020年7月4日

詰め込みはいいと思うんだけど、重箱の隅をつつくような、というか「理解しているなら表現を変えても正当腕切るよね?」という国語の問題のよう設問が多かった。

"G検定を受ける"ということがビジネスで役立つ気がしないからです。

私の(そして一般的な現場の人間の)期待や目的としては、G検定のテキストにゼネラリストとして必要な知識がかかれており、G検定取得の改定でそれらを身に着けることができるということではないかと思います。

G検定をパスしているから就職に有利になるとか、そんなことはそもそも資格自体の効力には期待していません。人件費で苦しむ日本企業はそんなに甘くありません。

しかし、ふたを開けてみるとG検定の問題にテキストから出てきた問題はごくわずかでした。あのテキストではまったく不足しており、なおかつ古いよって言われているような気分です。

それは正しいのかもしれませんが、公式テキストですらその体たらくではどうやって勉強したらいいのか、、、目的である勉強を達成することができません。

G検定を受検する代わりに

私は現場で使っているエンジニアですが、一方でもっと泥臭い現場からデータサイエンスで解決できる問題はないかをひっぱりあげ答えを探すゼネラリストでもあります。

繰り返しになりますが、この観点から言うとG検定というのはやはりあまり意味がないな、と思います。自動運転とかドローンとか使わないし、著作権を気にする段階にまで到達することなんてめったにありません。

そういう意味ではJDLAは一般の製造業の現場のリアルを知らないのではないかと思います。AIではありませんが、マテリアルインフォマティクスやソフトセンサーの話も一切出てきていませんでした。

それではG検定の勉強自体が無駄だったのかというとそんなことはまったくありません。今回不合格だったとしてもよい勉強になったなと思います。

現場の人間の立場からのおすすめの勉強方法としては下記のとおりです。

おすすめ書籍たち

・エンジニアなら知っておきたいAIのキホン

勉強する上でこれが非常によかったです。おすすめ。

白本の技術的な内容(CNN, RNN, LSTM)に着目してもっと詳細に書いてある本です。「エンジニアなら」と書かれていますが、仮に皆さんが技術系でなくてもこれくらいは知っておいたほうがいいというぎりぎりを狙っているようにも思います。

ちょっと細かくて眠くなる部分もありますが、尤度って何?Qって何?という言葉だけ覚えて飛ばしてしまうような部分をもっと細かく解説してくれています。

こういう部分に着目する人というのはかなり原理にこだわる人なので、そういう人から学ぶのが一番です。

加えて、なんかチャラいんですよね。ところどころにマリちゃんを狙っているAIエンジニアの小話みたいなのが入っていてそれが箸休めにちょうどよいです。

・Study-AIの模試(http://study-ai.com/generalist/)

AI研究の歴史、直近の出来事、技術に関する基礎的な部分を幅広く勉強するのによいです。まず解いてみて、わからないところをググッて調べるのがいいのかな、と。

たとえばReNetとかはビジネスでも活用シーンがありますが、それができた経緯などを知っていると仕事がやりやすくなると思います。

なんで?と聞かれると難しいですが、たとえば料理でも野菜の旬を知っておいたほうがよりよいものができるはずです。周辺情報と背景情報はある程度知っておいたほうが情報の取捨選択により目的を達成しやすくなります。それと同じですね。

本がよければこちらがお勧めです。通称、黒本ですね。公式のテキストをおって勉強していくより、この本を解いて分からないところを調べていくというのが知識の習得に役立ちました。

・人工知能は人間を超えるか

G検定の推薦図書ですね。

正直これをよんでもG検定受験の役には立たないのが現状ですが、この本単体としてみれば面白いです。

技術的な内容というより、松尾教授という日本での第一人者がどのように考えているかを知ることができるのが非常によいです。プロジェクトXや私の履歴書が好きな人は好きかもしれません。(あの方向性とはちょっと違いますが)

私がG検定を受けて意味がないなと思っているのにも関わらず、悪感情をもっていないのはこの人のおかげと言っても過言ではないでしょう。

一度講演を聴いたことがあるのですが、黎明期から日本でのAI活用を広めるために奔走されている方です。

・AI白書

あとは上記ではカバーできない法律部分です。

これが全てカバーしているわけではないのですが、これをよめばこんな要素があるんだということを知れると思います。

問題はタウンページくらいのサイズだというところですね(笑)

まとめ

G検定受験を迷ってこのページにたどりついた方がいたら、私はやめておけ、といいます。理由はこれまで書いたとおり何に使えるか分からないからです。

ただ、それはディープラーニングを勉強するなという意味ではありません。むしろ勉強はしたほうがいいです。エンジニアにとっては必須のスキルになる可能性があります。

その勉強方法を自分なりに導き出せたという意味で、たとえ落ちたとしてもG検定受験に後悔はありません。なんとなく分かった感じを得るためには上記の本を読んで、模試を解いて、というのを何度か繰り返す(2周くらいしたいところ)のがいいと思います。

本を全て買うと8千円くらいかな?G検定の受験費用より安いですね。

どれか1冊買うとしたらエンジニアなら「AIの基本」、そうでなければまず「人工知能は~」を読むことをお勧めします。

G検定を受ける予定の人は、、、Good luck!

G検定に向けたチートシート 当日用のカンペ

こんばんは、へるもです。

いよいよG検定ですね!

圧倒的な暗記項目の多さにやる気を失っていたのですが、インターネットで調べてもよいという特長を活かして、カンニングペーパーを作ることにしました。

※取得後に思ったこと

チートシート

考えることはみんな同じようで、ネットで調べると幾つか出てきますね。「G検定カンペ、まとめ、チートシート」とかが検索ワードとして強いようです。

ただ、いくつのページを開いて検索するというのは不合理ですし、次の項目で紹介するページを参考にして、ここにないものをまとめる、といった形で作成しました。

これだけ書いても足りないんだろうな、と思うとつらいのですが、それでもないよりマシです。

自分用のメモなので間違っていたらごめんなさい。何かあれば、ご指摘ください。

使い方

【G検定チートシート】AI関連法律や動向含む試験当日のカンペ | WATLAB -Python, 信号処理, AI-

①上のページとこのページを開いておく

②試験中に回答がわからなければ、この2つから検索する(ctrl+F)

google先生に頼ればいいでしょと思う方には、そのとおり!っていいたくなるのですが、ぱっと分かりやすいやつに出会う確率が少なかったんですよね。はずれを引くと文章が長い。

とはいえgoogle先生もやはり強力なので、基本は三刀流かな。

このように引用元がかかれていないものは上記のページから引用させてもらいました。丸っきりのパクリにならないように引用したものにはデータを付け足しましたが、偉大なる先人には感謝です。

※がついているのは管理人のコメントです。精度は低いかもしれませんが、難しい言葉を言い換えるときとかに使います。

こっちも重要

法律や政策ベースのものの出題が増加傾向です。

黒本や白本の正答率を9割位までに上げきったら、AI白書などを読むのがよいと思います。

ポイントはこちら。

・個人情報保護 ・匿名加工 ・自動運転 ・著作権 ・ドローン飛行規制 ・道路交通法改正

まとめている時間がないので、何が書かれているかをさらっと把握して後は運任せですかね。

【ディープラーニングG検定対策】ディープラーニングの応用に向けて | シミュレーションの世界に引きこもる部屋

ディープラーニングの産業への応用 その1 | シミュレーションの世界に引きこもる部屋

ディープラーニングの産業への応用 その2 | シミュレーションの世界に引きこもる部屋

ディープラーニングの法律、倫理、現行の議論 | シミュレーションの世界に引きこもる部屋

AI白書はこちらにもデータがありました。少し古いですが。

https://www.ipa.go.jp/files/000082705.pdf

上記だけだと途中までしか見れないですが、下のページから続きも見れるということを教えてもらいました。

↓ P. 079-166

https://www.ipa.go.jp/files/000082706.pdf

↓ P. 166 - 262

https://www.ipa.go.jp/files/000082707.pdf

↓ P. 262 - 294

https://www.ipa.go.jp/files/000082708.pdf

少しお得な問題集

ちなみにG検定の問題集(黒本)がキンドルで半額のようです。

定価で買っちゃったよ。評判もよいので、最後の追い込みにいいかもしれません。

後は、D検定を主催しているJDLAの松尾先生の本(推薦図書)がキンドルアンリミとaudibleで出ていますね。無料体験があるので、まだ読んでいない方は目を通しておいてもよいかもしれません。

勉強が足りない方は問題集をしたほうがいいと思いますが、読み物としても普通に面白かったです。

こういうのも大事。

G検定の準備 ~ブラウザ編~

— みやっちですッ!🦖G検定に浮気中 (@miyacchi_desu) July 1, 2020

Google Chromeの場合

1. 右上のその他の設定アイコン

2. 設定

3. プライバシーとセキュリティ

4. サイトの設定

5. コンテンツ

6. Cookie・Javascript・ポップアップを「許可」にする

※拡張機能を入れてる方はどんな影響があるかわからないので無効をおすすめ#G検定 pic.twitter.com/ZfetthNEA5

ソフト関連

Deep Blue

1996年にIBMが開発

力任せの探索

10~14手先を読む

Bonkras

将棋ソフトウェア

2011年 世界コンピュータ将棋選手権で優勝

2012年 将棋電脳戦

現在はPuella αと解明

Ponanza

将棋ソフトウェア

山本一成らが開発

2012 電脳トーナメントを制する

2015 世界コンピュータ将棋選手権で優勝

sharpchess

オープンソースのチェスソフトウェア

Deep Dream

2015 年 google 社

通常の画像をまるで夢に出てくるかのような不思議な画像に変換して表示するプログラム

Tay

マイクロソフトの対話型ボット

ツイッターを利用

不適切な調教によりやらかした

AlexNet

2012年のILSVRCでトロント大学のジェフリー・ヒントン率いるチームが使用し、2位以下に圧倒的な差をつけて優勝したネットワーク。8層。調整するパラメータは60,000,000にものぼる。

→Alex Krizhevsky

5個のcovolutional層と3個のpooling層が存在

"stride of 4"

ResNet

2015年のILSVRCで優勝。152層。Microsoftのチームが開発。これまで以上に層を深くできるようにスキップ構造を導入した。

→スキップ構造=インセプション(inception)モジュールの導入

→出力を「入力」と「入力からの差分」の和としてモデリングした

→求めたい関数と入力のと差である残差を学習するようにした

→CNNでは沢山の層を重ねた結果、学習に用いられるパラメータの数が膨大となり、学習が上手く進まないという問題が生じていた。ResNetは入力層から出力層まで伝播する値と入力層の値を足し合わせたモデルで、入力層まで、勾配値がきちんと伝わり、 深い構造(1000層)でも学習が可能となった。2015 年の ILSVRC で人間の成績を上回る成果をあげた

→Microsoft Research(現Facebook AI Research)のKaiming He

VGG16

2014年のILSVRCでGoogLeNetに劣らない性能を誇ったオックスフォード大学のチームのCNN。16層。GoogLeNetには及ばなかったが、シンプルなネットワークなので技術者に好んで使われる。

※VGGnetともいう?

STRIPS

前提条件、行動、結果の3つの組み合わせで記述する

人工知能が自律的に行動計画を作成する技術であるプランニングで有名

SHRDLU

テリーウィノグラード

積み木の世界

物体の動かし方をプランニングできた言える

LeNet

1998にヤンルカン氏が発表したCNNの原型

多層CNNに誤差逆伝播法を適用した手法

WaveNet

音声生成でブレイクスルー

google Deep mindが2016年に開発

RNNではなくCNNを用いている

ライブラリなど

OpenCV:画像に特化

Julius:音声認識システムの開発・研究のためのオープンソースの高性能な汎用大語彙連続音声認識エンジン

OpenNLP:自然言語処理のためのツールセット

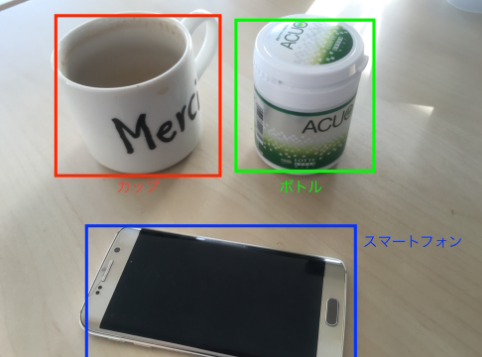

画像処理

R-CNN(Regional CNN)

関心領域(ROI)の切り出し → CNNを呼び出す

ROIきりだしにはCNNはではない従来手法を使ったので時間がかかる

※ROI:見たい領域、どこに識別するかという領域

↓

高速RCNN

切り出しの画像認識を同時に行う

→faster RCNN:ほぼ実時間で処理が可能。動画認識にCNNを使えるようになった

↓

物体検出(画像検出)

画像内に含まれるとある物体を取り囲むようなボックスを推定するタスクを行うもの

2014:R-CNN

2015:Faster R-CNN

2016:YOLO(You only look once)

SSD(single shot detector)

自動運転にも応用される精緻な画像認識技術、「画像セグメンテーション」とは?事例を交えてわかりやすく解説|株式会社インキュビット

物体セグメンテーション(画像セグメンテーション)

対象とする物体とその周囲の背景を境界まで切り分けるようなタスクを行うもの

特徴はFCN (Fully Convolutional Network/完全畳み込みネットワーク)

※画素ごとに判別している、だったかな?

CVPR 2015, PAMI 2016で発表

Semantic Segmentation手法

全ての層が畳み込み層

入力画像の画素数だけ出力層が必要

縦画素×横画素数×カテゴリー数

特徴量から画像を生成する際はCNNと逆の操作を行う

畳み込み層→逆畳み込み層

プーリング層→アンプーリング層

アンサンプリングにより解像度を復元

自動運転にも応用される精緻な画像認識技術、「画像セグメンテーション」とは?事例を交えてわかりやすく解説|株式会社インキュビット

画像セグメンテーションは2種類

1つは,個別の物体を区別するインスタンスセグメンテーション(Instance-aware Segmentation)

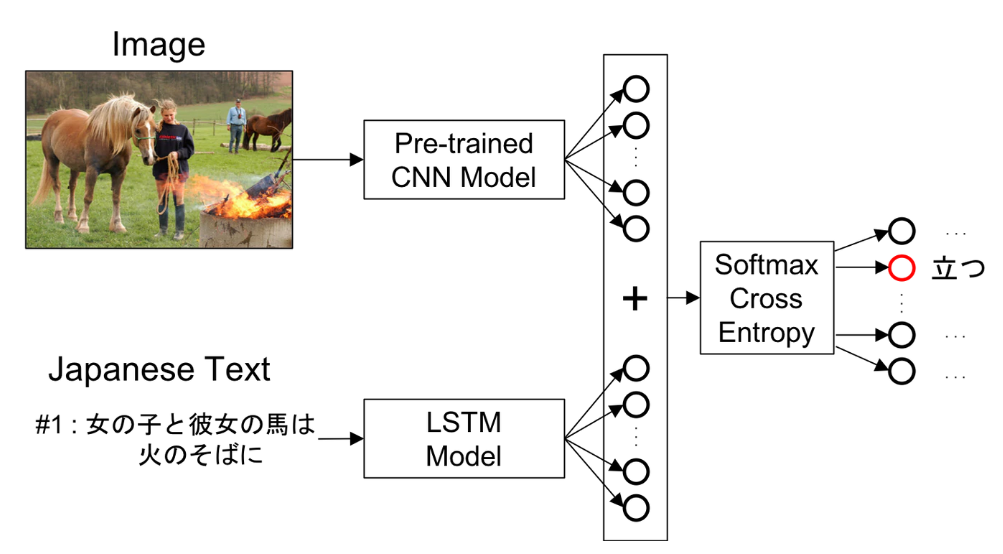

(上で言えばcowを1~4に区別される)

もう一つは,同一クラスの物体であれば個を区別しないSemantic Segmentation(セマンティックセグメンテーション)

画像キャプション

画像内に表示されている女性を認識し,「青い服を着てスマートフォンをいじっている」などのようにその対象が何をしているかを表示させること

画像をCNNに入力し、そこから得られた特徴をLSTMに入力することで生成

CNNとRNNと組み合わせ

画像分類

自動運転にも応用される精緻な画像認識技術、「画像セグメンテーション」とは?事例を交えてわかりやすく解説|株式会社インキュビット

この画像は何を示しているのか?という操作をすること

動画認識

Spatio-temporal ConvNet

動画の10フレームをCNNに入力し、行動認識

Two-stream CNN

Spatial stream ConvNet:フレーム画像を認識

Temporal stream ConvNet:動きの情報を認識

→Inflated 3D ConvNet (I3D)

肺がん診断AI:人間の専門家に匹敵 or 上回る精度

音声認識

End to End 音声認識

音響特徴量から音素,音素から文字列,文字列から単語列に直接変換して言語モデルを学習するアプローチ

ディープラーニングは入力から出力を一括で行うことができるEnd to End learning

(音声波形→音素→文字→文字列→単語→単語列)

音素状態認識

音声の周波数スペクトル,すなわち音響特徴量をインプットとして,音素状態のカテゴリに分類する

雑音・残響抑圧

音声を認識したい対象とそれ以外の雑音に分離する

人間の音声を人工的に作り出すこと

自然言語処理などにおいて、文の品詞や統語構造、単語と単語、文書と文書などの関係性について定式化したもののことである。 言語モデルは、多くの場合は統計学的な観点から数式などを用いて確率的に定められる。

確率を精密に設定することにより人間が用いる言語は理論上モデル化できる。

代表的な言語モデルとしては、Nグラムモデル、隠れマルコフモデル、最大エントロピーモデル

隠れマルコフモデル(HMM)

1990年代の音声認識

音自体を判別するための音響モデル

HMM+DNNの組み合わせがよい結果を出す

GMM

Nグラム法

1990年代の音声認識

語と語のつながりを判別する言語モデル

自然言語処理

機械翻訳、画像説明文生成→できる

構文解析、意味解析→精度向上はしているが、、、

文脈解析、常識推論→実用的な精度は見込めない

word2vec

トマスミコロフ

記号をベクトルとして表現することにより、ベクトル間の関係や距離として単語の意味を表現しようとするモデル

「王様」ー「男性」+「女性」=「女王」

単語埋め込みモデル、ベクトル空間モデルとも呼ばれる

スキップグラム(Skip-gram)単語を与えて周辺の単語を予測

CBOW:単語を与えてある単語を予測

fastText

トマスミコロフ

単語の表現に文字の情報も含める

学習に要する時間が短い

ELMo

アレンインスティチュート

文章表現を得るモデル

bag-of-words

文章に単語が含まれているかどうかを考えてテキストデータを数値化(ベクトル化)

Bag of Wordsについて書いてみる - どん底から這い上がるまでの記録

Ngram

単語単位で区切った形態素解析とことなり、Ngramでは任意の連続したN文字単位で区切

TF-IDF

Term Frequency(TF)

Inverse Document Frequency(IDF)

文書の中から、その文書の特徴語を抽出する時に使う

単語の重要度を特徴量にする

いくつかの文書があったときに、それらに出てくる単語とその頻度(Frequency)から、

ある文書にとって重要な単語はなんなのかというのを数値化

文法的な情報の注記の無い自然言語のテキストデータ(文)から、対象言語の文法や、辞書と呼ばれる単語の品詞等の情報にもとづき、形態素(Morpheme, おおまかにいえば、言語で意味を持つ最小単位)の列に分割し、それぞれの形態素の品詞等を判別する作業

制限ボルツマンマシン(RBM)

音声認識で使用される

自動運転

米国ネバダ州では自動運転の走行や運転免許が許可制にて認められた

ドローン

飛行禁止空域

・空港周辺

・150m以上の上空

・人家の集中地域(DID)飛行ルール

・日中のこと

・距離の確保を行うこと

・催しを行っている場所は飛行禁止

・危険物輸送の禁止

・物件投下の禁止国土交通省への申請で許可を受ければ飛ばすことができる。守らないと50万円以下の罰金。ルールは総重量(バッテリー等本体以外の重量含む)が200g未満の場合は対象外。

→夜間の禁止

人口集中地区の上空・イベントなど大勢の人が集まる場所での飛行禁止

ひと・ものから30m未満の飛行は承認が必要

→風速が5m/s以下のコンディションでなければ飛行はできない

→風速と速度の和が7m/s以下とすること

→国会議事堂や内閣総理大臣官邸、外国公館、原子力事業所の周辺地域は「小型無人機等の飛行禁止法」により飛行禁止空域

セキュリティ関連

スパムメール判別

LSTM, ナイーブベイズ

Adversarial Examples

AIへのサイバー攻撃

Evasion attack : 難読化(暗号化,画像ベース)

Poisoning attack : 訓練データの操作,ラベルの反転

AIを作るうえでのあれこれ

フレーム問題

無限にある可能性からの探査には無限の時間がかかってしまう問題。このフレーム問題を克服したAIを強いAI(汎用AI)、克服できないAIを弱いAI(特化型AI)と呼ぶ

→有限の情報処理能力では、現実の問題を解くのは難しい

強いAI, 弱いAI

汎化AI, 特化AI

ジョンサール

身体性・身体知

AIが現実世界における抽象概念を理解し、知識処理を行うために必要なこと

→身体性を通じた高レベルの身体知を獲得し、

→次に身体知を通じて言語の意味理解を促し、抽象概念・知識処理へいたる

※ロボット研究から生まれた概念だったような?人間は五感をはじめとしてセンサーだらけの自律体でいろいろな情報から複雑な関係性を学習できるですが、ロボットは限られたセンサーしかもたないですし

人工知能研究

抽象概念や知識理解に辿り着くための方針は3つある

→言語データによる RNN や映像データからの概念・知識理解を目指す

UC Berkeley

→実世界を対象に研究を進め,知識理解を目指す

DeepMind 社

→オンライン空間上でできることをターゲットにするして,知識理解を目指す

人工知能研究の変遷

パターン処理 -> 記号処理 -> 知識の蓄積

学習方法

表現学習

ローデータからコンピュータが自動的に事象を識別するための特徴量を学習する一連の技術

CNNがこれにあたるはず。特徴量学習とか言われているときもあるような

マルチタスク学習

いくつかの関連するタスクにおける学習の内容を共有する事によってそれぞれのタスクにおける予測精度を向上させる学習方法

多様体学習

非線形の多様体上に分布しているようなデータ構造のデータを学習する一連の手法

勾配降下法

勾配情報を利用して重みを増加させるか減少させるかを決める。学習率がハイパーパラメータ。

→オンライン学習とはひとつのサンプルだけを利用する手法

1. 重みとバイアスを初期化

2. データ(ミニバッチ)をネットワークに入力し出力を得る

3. ネットワークの出力と正解ラベルとの誤差を計算

4. 誤差を減らすように重み(バイアス)を修正

5. 最適な重みやバイアスになるまで繰り返す

バッチ学習:全データを用いて学習

計算処理に時間がかかる

オンライン学習:ひとつのサンプリングごとに学習

収束するまで学習データを何週もする

計算処理は早いが、ノイズやはずれ値の影響を受けやすい

ミニバッチ学習:折衷案で、よく用いられる

幾つかのデータセットに分けて、それぞれの塊ごとに学習する

AdaBoost

機械学習⑤ アダブースト (AdaBoost) まとめ - Qiita

モメンタム

以前に適用した勾配の方向を現在のパラメータ更新にも影響させる

※坂を下っていくのが勾配降下法なら、坂を下る際の加速度を加味するイメージ

↓

AdaGrad

モメンタムの欠点を解決したのがAdaGrad

すでに大きく更新されたパラメータほど更新量(学習率)を減らす

一度更新量が飽和した重みはもう更新されないという欠点がある

※一度大きな坂を下り、緩やかな坂を体験すると、次の坂に差し掛かっても降下できない

↓

RMSprop

AdaGradの発展

指数移動平均を蓄積することによってAdaGradの問題を解決した

※上記、二度目の坂では最初の坂の勾配情報を無視して学習を進めることが可能

↓

Adam

RMSpropの発展

Adadelta

RMSpropの発展

次元のミスマッチを解消

RMSpropGraves

手書き文字認識で使われる

学習率

学習率が過度に大きいとコスト関数の高い局所的最適解から抜け出せなくなることがある

学習率が大きいと収束は速いがコスト関数の最終的な値が高い

学習率が小さいと収束は遅いが最終的にはより最適解に近いパラメータになるため,コスト関数は小さな値に収束する.

最小二乗法

モデルの予測値と実データの差が最小になるような係数パラメータを求める方法

符号を考えなくてよくなり計算がしやすくなる→二乗するから

はずれ値に弱い

ファインチューニング

既存のモデルの一部を利用して新たなモデルを解くために再学習する手法

学習済みモデルの最終出力層を付け替えるが、入力層に近い部分と出力層のパラメータも変更

例えば、犬と猫と人間を分類するモデルを柴犬とゴールデンレトリバーを分類するモデルに変更するなどのように学習済みモデルと比べて全く異なるモデルへと学習することができるようになる

※事前学習との比較のときとは扱われ方が違うような? 本質的には同じようだが

転移学習

学習済みモデルの最終出力層だけを付け替えて、自分のデータを学習させ新しいモデルを作成するということで出力層のパラメータだけ変更する

例えば、犬と猫と人間を分類するモデルを犬と猫のデータで再学習させることで犬と猫を分類するモデルを作ることができる

蒸留

大きなNNなどの入出力をより小さなネットワークに学習させる技術

生徒モデルを単独で学習させるより過学習を緩和する効果がある

メリット:モデルの精度向上、訓練の効率化、敵対的攻撃(Adversarial Attack)に対する防御

各クラスの最も近いデータの距離を最大化することで係数パラメータを得る方法

マージンの最大化がコンセプト

線形分離不可能なデータのマージンを最大化するためのスラック関数

非線形境界を得られるようにするためのカーネル法(カーネル関数)

→データをあえて高次元に写像することで、その写像後の空間で線形分類できるようにする

主成分分析

線形

次元削減

寄与率が各成分の重要度

主成分が各成分の意味

ロジスティック回帰

シグモイド関数という関数をモデルの出力に用いる

→数式上の表現は単純パーセプトロンとまったく同じになる

→線形分類しかできない

→ニューラルネットワークの一種

→尤度関数が目的関数

→対数オッズと呼ばれる値を予測し、正規化して結果を確率として解釈

最尤推定法

ある係数パラメータが与えられたときに,モデルが実データを予測する確率(尤度)を最大化するような係数パラメータを求める方法

残差

モデルによって出力された値と実際の測定値の誤差

残差を用いて係数パラメータを推定するアルゴリズムが最小二乗法と最尤推定法

教師なし学習(大脳皮質の動きを模倣)

主成分分析(PCA)

自己符号化器

クラスター分析

自己組織化マップ

教師あり学習(小脳の働きを模倣)

k近傍法

主成分分析(PCA)

エージェントが環境に対して行動を行うと、報酬と状態が環境から返ってくる

報酬を最大化するように学習する

エージェント:行動を学習する

環境:エージェントが行動を加える対象

状態:環境が今どうなっているかをあらわす

時間がかかる

マルチエージェント応用

アルゴリズム:Q学習

行動価値関数の関数近似に畳み込みニューラルネットワークを用いた手法

ゲーム終盤でコンピュータがランダムに手をさし続けて終局させて勝率が高い選択肢を選ぶ

Mini-Max法

ゲームボードの戦略を立てるときに自分が指すときにスコアが最大に、相手が指すときにスコアが最小になるように戦略を立てる方法

αカット:スコアが最小のものを選ぶ過程=相手の選択肢を考える上ですでに選択したスコアよりも大きいノードが現れた時点でその先に繋がるノードの探索をやめてしまう

βカット:αカットの逆。自分の選択肢を考える上で不利になるものはその先まで探索しない

行動価値関数

ある状態である行動を行うことの「価値」を表す関数

強化学習では最適行動価値関数をとることを目指して学習を行う

→Q学習:試しに何度もやってデータ集めて、期待値に収束させる

→DQN:最適行動価値関数をニューラルネットを使った近似関数で求める

強化学習における工夫

Experience Replay:時系列で並んでいるinputデータを順々に使って学習を進めると、inputデータ間の時系列の特徴に影響を受けてしまうため、ランダムにデータを取り出して学習させる

Fixed Target Q-Network:正解データ(target)と見立てている部分の値は一つ前のを使って計算しています。(とする)しかし、1回の学習ごとに毎回を更新すると、正解も毎回変わるため、どこに近づけたらいいのかわからない状態になります。そのため、は、一定の期間ごとにで更新するようにします。

報酬のclipping:

ロボット・ロボティクス

一連の動作の組み合わせと捕らえて学習(一気通貫学習)

強化学習による試行錯誤

アンサンブル学習

複数の学習器を組み合わせて予測する手法

これにより全体の汎化性能をあげることができる

スタッキング

アンサンブル学習の一つで、モデルを積み上げて性能を向上させる手法

Stacked generalization

複雑だが精度が高い

スタッキング(stacked generalization)の発想とやり方 - 具体例で学ぶ数学

バギング

アンサンブル学習の一つで、複数のモデルを別々に学習させ、各モデルの平均や多数決によって最終的な判断をする手法

ブートストラップを使う

ランダムフォレストとかが当てはまる

バギングの意味と、ブースティングとの違い - 具体例で学ぶ数学

並列処理ができるので時間をかけずにそこそこ精度の高いモデルを作る

ブースティング

バギングのように弱学習器を独立に作るのではなく、1つずつ順番に弱学習器を構成していく

その際、k 個目に作った弱学習器をもとに(弱点を補うように)k+1 個目の弱学習器を構成する

ブースティングの具体例としては、AdaBoost、XGBoost、LightGBM、CatBoost

直列処理なので、時間はかかるが高い精度が得られる

マルチタスク学習

同時に複数の識別問題に対応できるように学習する手法

最初から複数のドメインの課題を解くためのモデルを設定する

マルチタスクの深層学習では各課題の重み付き和が損失関数になる

マルチタスク学習の成功にとって望ましい条件は、複数の課題間で共通する因子や有用な特徴、局所解をもっていること

順序を持つ文字列のカテゴリーデータの場合、対応する数値を辞書型データで用意して数値に変換する手法

ワンホットエンコーディング

順序を持たない場合、各変数に対応したダミー変数を新たに作り出す

one-hot-encoding

解決いたしました!!

— meer@G検定対策なう (@812_meer) July 2, 2020

神々しい解説↓ pic.twitter.com/AFYmGFsf0N

欠損値がある場合の処理

リストワイズ法

→欠損のある行をすべて削除

ペアワイズ法

→欠損の少ない列を使用することにし、特定の行を取り出してから欠損を削除

回帰補完

→欠損しているある特徴量と相関が強い他の特徴量が存在している場合

平均補完

→平均値を入れる

ステップワイズ法

→欠損値処理ではない。「ステップワイズ法(逐次選択法)」は、統計ソフトが自動的に説明変数を1個ずつ入れたり出したりして、適合度の良いモデルを選択する方法

データセット

MNIST:手書き文字、アメリカの国立標準技術研究所

ImageNet:インターネットから集めて分類した画像、1400万枚、スタンフォード大学

CIFAR-10:物体カラー写真、初心者向けのチュートリアルなどで使用

VOC2012、MSCOCO:

学習済みモデル

【2019/4月更新】学習済みの様々なディープラーニング・モデルをメチャ簡単に利用できる! Model Asset Exchange(MAX)をご紹介します - Qiita

設定ファイルを使う:Cafe, CNTK

→モデルの定義がテキストで設定でき,簡単に学習を開始させることが出来るというメリットがある.一方で,ループ構造をもつような RNN など,複雑なモデルを扱う際には,モデルの定義を記述することは難しくなる傾向にある

プログラム:TensorFlow, Chainer

→一度書き方を覚えてしまえば,複雑なモデルでも比較的簡単に記述することが出来るが,モデルは,それぞれのフレームワーク固有のソースコードで出来上がるため,モデルが使用しているソフトウェアに依存してしまうという問題がある

define-and-run:cafe

define-by-run:Chainer, py-torch, tensorflow, mxnet

重み更新の際に、重みが更新された回数

一回のイテレーションに用いるサンプル数はバッチサイズと呼ばれる

エポック

訓練データを繰り返し学習したときの、その回数

アルゴリズムあれこれ

NN

ニューラルネットワークの学習には損失関数(コスト関数)の最適化により行われる

ロジスティック回帰、単純パーセプトロン、多層パーセプトロン、がこれにあたる(畳み込んでない)

損失関数

回帰問題→平均二乗誤差関数

分類問題→交差エントロピー誤差関数

※分類に使うランダムフォレストの不純度がエントロピーだったような

分布を直接学習→KL ダイバージェンス

損失関数、コスト関数、誤差関数の違い

損失関数=誤差関数

損失関数+正規化項=コスト関数

目的関数、コスト関数、誤差関数、損失関数いろいろあるけど、なにが違うのかを検討 - Qiita

CNNのコンセプト

CNNは人間の視覚野の神経細胞を模倣

単純型細胞(S細胞):画像の濃淡パターン(特徴)を検出

複雑型細胞(C細胞):物体の位置が変動しても同一の物体であるとみなす

→ネオコグニトロン(福島邦彦)

CNNとNNの違い

画像全体のうちある一定範囲ごとに演算を行い、その範囲ごとに特徴量を計算

はじめは単純な特徴を拾い上げ、より後の畳み込み層になると複雑で抽象的な特徴を拾う

これにより汎化性能が高まる

一定範囲ごとに読み込んでいるので特徴がどこにあっても検出できる(位置不変性、移動不変性)

※画像が回転すると検出が苦手で(回転不変性がない)、拡大縮小にも弱い

定番のConvolutional Neural Networkをゼロから理解する - DeepAge

学習に必要なパラメータが多い

計算量が多い

より複雑な関数を近似できる

結果の解釈や説明ができない(ブラックボックス)

Global Average Pooling

ひとつの特徴マップにひとつのクラスを対応させる

CNNの手法の一つで全結合層を用いずにこれを使う

1980年代には誤差逆伝播学習が提案されていたが、多くの層を持った学習をすることはできなかった

→勾配消失問題

→層の数が多いとNNの学習の目的関数は多くの最小値を持ち、適切な結合の重みの初期値の設定が難しかった

勾配消失問題への対処法

いくつかあるが、、、

事前学習:勾配消失問題はモデルのパラメータの初期値に対して依存する。モデルを事前学習させることで安定した学習が可能となり、勾配消失問題を克服できると考えられる

ReLU関数を使う:微分値が0以上の場合はそのままの値、0以下の場合は0となる。

この性質により誤差逆伝播の際に、重みが小さくなるのを防ぐことができる

誤差逆伝播法のときに起こる問題

勾配消失問題:誤差がどんどん小さくなっていき学習が収束しない問題

勾配爆発問題:誤差が大きくなっていき学習が収束しない問題

活性化関数

tanh関数(双曲線正接関数)→ReLU関数のほうが勾配消失問題が起こりづらい

ReLU(Rectified Linear Unit)/ランプ関数/正規化線形関数

Maxout→複数の線形関係の中で最大値を利用

ステップ関数(Step function、単位ステップ関数:Unit step function)→微分値が常に0なのでほとんどのNNでは使用されない。単純パーセプトロンの出力層で用いられる

重み共有、局所的受容野

カプセルネットワークはニューラルネットワークを超えるか。 - Qiita

パラメータ数:全結合層>畳み込み層

重み共有によって有用な特徴量を画像の一によって大きく変化させない

DNN

CNNの層を深くしたものがDNN

学習するべきパラメータ数が膨大となるため、処理の高速化が必要

2012年に提案された分散並列技術であるDistBelif(googleが開発した深層分散学習のフレームワーク)やGPUが利用されてきた

内部共変量シフト

(DNNにおいて、)ある層の入力がそれより下層の学習が進むにつれて変化し、学習がとまってしまう

大規模なNNの学習が困難となる原因

→対策としてバッチ正規化(2015)がある

出力値の分布の偏りを抑制する

各層で出力を正規化することで、層が深くなっても入力の分布の変化が少なくなる

CNNによる画像処理

パディング:出力画像のサイズを調整するために元の画像の周りを固定の値で埋める

→ゼロで埋めるときはゼロパディングなど

プーリング:最大プーリング、平均プーリング、Lpプーリング(周りの値をp乗し、その標準偏差をとる)

ハイパーパラメータのチューニング

ベイズ最適化:過去の試験結果から次に行う範囲を確率分布を用いて計算する手法

リカレントニューラルネットワーク(RNN)

ネットワークの入力層のひとつ前に学習で用いた隠れ層(中間層)のジョウタイを与える回帰構造を兼ね備えている

前の単語や文の情報が引き継がれて、隠れ層で過去のデータを保持できるようになっている

時間軸に沿って深いネットワーク構造を持つため、勾配消失問題が起こりやすい

ネットワークにループ構造を持つため、中間層が一層であっても勾配消失問題が起きてしまう

→手書き文字認識に利用

http://ds9.jaist.ac.jp:8080/ResearchData/sub/99/kobayashi/node5.html

ElmanNet

JordanNetと並ぶ初期の有力なRNNの一種。

→音声認識に利用

LSTMのゲート

LSTMには以下の3つのゲートがあり、ゲートの開け閉めによって信号の重み付け(全開1、全閉0、その中間)をしている。

・忘却ゲート

・入力ゲート

・出力ゲート

→ユルゲン・シュミットフーバーとケプラー大学のゼップ・ホフレイターの提案

→各ゲートでの情報の取捨選択はシグモイド曲線を使う

→RNNとの違いで最も目につくのはメモリセルと呼ばれる中間層の状態を保持するパラメータ。メモリセルは、いくつかの次元をもち、時刻経過とともに変化する性質

→機械翻訳や画像からのキャプション生成などに応用

BPTT

RNNのときの誤差逆伝播をこう呼ぶ

LDA(Latent Dirichlet Allocation)

トピックモデルの1種

文書がどのようなトピックから構成されているかを推論するモデル

推論するパラメータは以下

トピック分布:文書ごとのトピック構成比率

単語分布:トピックごとの単語比率

CNNとRNN

CNN:データに潜む空間的構造をモデル化する

RNN:時間的構造をモデル化する

GRU

ゲート付き回帰型ユニット

更新ゲートと忘却ゲート

LSTMに似ているが、小さなデータセットではより高い精度を示す

一方でLSTMのほうが強力である

音声処理

時系列データなのでリカレントニューラルネットワーク(RNN)が最適と考えられていたが、音声処理の分野ではオートエンコーダが非常に高い精度を記録している

オートエンコーダ(Auto Encoder・自己符号化器)

三層NNにおいて、入力層と出力層に同じデータを用いる学習方法

入力データと一致するデータを出力することを目的とする教師なし学習

→積層オートエンコーダでは最後にロジスティック回帰層を足すことで供しあり学習になる

エンコーダ(特徴抽出機)とデコーダ(生成器)をもつ

ジェフリーヒントンが提唱

活性化関数に恒等写像を用いた場合の 3 層の自己符号化器は主成分分析(PCA)と同様の結果を返す

オートエンコーダを多層化するとDNNと同様に勾配消失問題が生じるため、複雑な内部表現を得ることが困難であったため、2006年にヒントンは単層の自己符号化器に分割し、入力層から繰り返し学習させる層ごとの貪欲法を積層自己符号化器に適用することで、汎用的なオートエンコーダーの利用を可能とした

オートエンコーダの利用例

次元削減に用いられる

ニューラルネットの事前学習

ノイズ除去

異常検知

データ生成(VAE)

オートエンコーダ/自己符号化器 - MATLAB & Simulink

積層オートエンコーダ

オートエンコーダを積み重ね、最後にロジスティック回帰層を付加する

事前学習→ファインチューニングの工程がある

入力層に近い層から順番に学習させる(=事前学習)という逐次的な方法を取っている

最後にロジスティック回帰層を足して、全体で学習する(これをファインチューニングという)

ファインチューニング

既存のモデルの一部を利用して新たなモデルを解くために再学習する手法

ネットワーク全体への教師あり学習

学習済みモデルの最終出力層を付け替えるが、入力層に近い部分と出力層のパラメータも変更

例えば、犬と猫と人間を分類するモデルを柴犬とゴールデンレトリバーを分類するモデルに変更するなどのように学習済みモデルと比べて全く異なるモデルへと学習することができるようになる

「深層信念ネットワーク」(Deep Belief Network)

DNNの一種で教師なし学習

オートエンコーダに制限つきボルツマンマシンrestricted boltzmann machineを事前学習として利用

ディープラーニングによる表現の獲得の例として、インターネット上の動画から切り出した画像を入力し、猫の概念を生成したというGoogleの研究が有名

ディープラーニングは素性の再利用と抽象的な概念(あるいは不変量)の獲得が可能ことがわかる

VAE

変分自己符号化器 (VAE; variational autoencoder)

変分オートエンコーダ

平均や分散などを求める生成モデル

VAEはGANに比べて安定した学習ができ, Flowと異なり潜在変数を低次元に落とすことができるので扱いやすく解釈性が高い

一方で、生成画像がぼやけがちで、尤度の計算ができない

誤差逆伝搬でVAEを学習させることができないので、reparametrization trickを使用する

通常のオートエンコーダとの大きな違いは、入力データを圧縮して得られる特徴ベクトル(潜在変数)を確率変数として扱う部分

生成モデル

データの特徴を抽出して学習し、実在しないデータを生成

変分オートエンコーダ

ボルツマンマシン

GAN

GANはより鮮明な画像の生成が可能

GAN

生成敵対ネットワーク

画像生成に用いられる

画像生成器→画像識別器をだますような画像を出力

画像識別器→画像生成器から出力された画像と本物の画像とを分類

ANは学習時に不安定になるケースが見られ、意味をなさない画像を生成したり、生成データの種類が偏るなどが課題

教師なし(ラベルなし)学習

DCGAN(Deap Convolutional GAN)

ランダムな数値の入力値をもとに画像生成を行う

GANとの違いは、GeneratorとDiscriminatorそれぞれのネットワークに全結合層ではなく、畳み込み層(と転置畳み込み層)を使用している点

GANの学習が安定しない問題に対して、Batch Normalization (バッチ正規化)の導入や、活性化関数にReLUだけでなくtanh, Leaky ReLUを使用している

自己組織化マップ(Self-Organizing Map: SOM)

フィンランドの研究者,T. Kohonenの発明したニューラルネットの一種である.SOM は教師なし学習を行う位相保存写像(topology preserving mapping) の一種である

確定的モデルと確率的モデル

https://jsai-deeplearning.github.io/support/20151031-index.pdf

確率的モデル :モデルの中に含まれる変数のうち、1つ以上が確率的に変動する確率変数であるモデル

確定的モデル:予測を行なうときのモデルの中の数式に含まれる変数が確率的な変動を示さないで、確定しているモデル

L1、L2正則化を用いた機械学習モデルは損失関数とパラメータの値の和を最小にするパラメータを学習する

パラメータの和を評価することでパラメータが大きくなるのを防ぐ

これによりモデルが過学習しないようにしている

汎化誤差を下げるために用いられることが多い

正則化の種類と目的 L1正則化 L2正則化について | AVILEN AI Trend

LASSO

Least Absolute Shrinkage and Selection Operator。L1ノルムという制約条件を与える正則化手法。パラメータのスパース推定を行う。

→ラッソ

→幾つかのパラメータを0(スパース)にする

→スパースであるとは、値のほとんどが0であること

→特定のデータの重みを0にする

→モデルに必要な情報を取捨選択してくれる

→次元圧縮に使う(※過学習を防がないわけではないはず)

→スパースにはならず、パラメータの大きさに応じてゼロに近づける

→汎化された滑らかなモデルを得ることができる

→パラメータのノルムにペナルティを課す

→過学習を防ぐ

→損失関数にパラメータの二乗ノルムを加えるとL2正則化になる

→荷重減衰:ニューラルネットの重みパラメータwに対して、|w|2が大きくなり過ぎないように制約を与える

→重要でないパラメータを0に近づける

Elastic Net

LassoとEidgeの中間

重みの制約

ネットワークの自由度が高いと、過適合が起こりやすい

そこで、学習時に重みの自由度を制限する

これを正則化という

正規化

データに対して何らかの計算を行い、全てのデータが0~1の間の大きさにすること

バッチ正規化

一部の層の出力を正規化する

局所コントラスト正規化

減算正規化と除算正規化の処理

画像処理の分野においては前処理として行われる

白色化

各成分を互いに無相関にし、平均を 0、分散を 1 にする

グレースケール化

画像を白黒画像に変換

平滑化

細かいノイズの影響を除去

ヒストグラム平均

画素ごとの明るさをスケーリングする

標準化

平均が0かつ分散を1にする

正規化に関する工夫

正規化(標準化)しても層を伝播することで崩れていくという課題に対しては重みの初期値を工夫するというアプローチがとられた

→初期値の最適値はわからない

→乱数にネットワークの大きさに合わせた適当な係数をかけることで、データの分布が崩れにくい初期値がいくつか考えられた

→シグモイド関数に対してはXavierの初期値、ReLU関数に対してはHeの初期値がよい

単語

再現率

偽陽性(False positive, FP)を減らす

全ての陽性サンプルを母数として、実際に陽性であることを見抜けたサンプル数を分子にする

→検出率というと分かりやすい

疾病判定に使われる

適合率

偽陰性(False negative, FN)を減らす

陽性であると判断したサンプル数を母数として、実際に陽性であったサンプル数を分子にする

リコメンドシステムなどに使われる

適合率と再現率の調和平均

多重パーセプトロン

非線形な分離が可能になった

Multilayer perceptron

非線形分離問題

単純なパーセプトロンで起こる

多層にすることで解決

A/Bテスト

ウェブサイトのより良いデザインの識別などに用いられる手法

異なるデザインや機能を備えたAとBをランダムに顧客に試してもらいよりよいものを識別する

パターンマッチング

あるデータが、どのようなパターンに属しているか or 特定のパターンが出現するかを特定する手法

逆問題

出力から入力を推定する問題や、入出力の関係性を解き明かす問題

(対義語)順問題

よい表現

ディープラーニングは観測データの説明要因を捉え、人間の知識では気がつくことができない共通点を捉えることができる。これをよい表現という。

「ディープラーニングの父」の一人、ヨシュア・ベンジオは良い表現に共通する世界に関する多くの一般的な事前知識として幾つかを提唱している(下記)

-滑らかさ

-複数の説明要因

-説明要因の階層的構造

-半教師あり学習

-タスク間の共通要因

-多様体

-自然なクラスタ化

-時間的空間的一貫性

-スパース性(データの分布のまばらさ)

-要因の依存の単純性

ディープラーニングは赤字のものに着目している。これらの事前知識を適切に活用できるのであれば、表現学習は必ずしも層の多いニューラルネットワークの形をしていなくてもよい

分散技術を用いたアプリケーション

並列処理を行うためのプログラミングモデル

醜いアヒルの子の定理

認知できる全ての客観的な特徴に基づくと全ての対象は同程度に類似

特徴を選択しなければ表現の類似度に基づく分類は不可能である

ベイジアンネットワーク

http://www.msi.co.jp/userconf/2018/pdf/muc18_401_2_1.pdf

情報リソースに意味を付与することで、コンピュータで高度な意味処理を実現する

概念もしくは構成要素の体系化

語彙やその意味、それらの関係性を他の人と共有できるように、明確な約束事として定義しておくときに用いられるもの

ヘビーウェイトオントロジー

対象世界の知識をどのように記述すべきかを哲学的にしっかり考えて行うもの

-cycプロジェクト

ライトウェイトオントロジー

効率を重視し、とにかくコンピュータにデータを読み込ませてできる限り自動的に行うもの

-データマイニング、ウェブマイニング

協調ベースフィルタリング

購買履歴

内容ベースフィルタリング

アイテムの特徴

知識獲得のボトルネック

人間が持っている一般常識が膨大で、それらの知識を全て扱うことは極めて困難

コンピュータが知識を獲得することの難しさを知識獲得のボトルネックと呼ぶ

1970:ルールベース機械翻訳

1990:統計的機械翻訳

2016:ニューラル機械翻訳

各国の政策

LAWS

AI殺傷平気

いまだ現存しない

アシロマAI原則

LAWSによる軍拡競争は避けるべきである

FLI(スティーブンホーキング、イーロンマスクも賛同者)が2017に発表

G検定まで2日

— モブ@aiエンジニア (@mobwin_) July 1, 2020

各国の経済成長戦略

日本 : 新産業構造ビジョン

イギリス : RAS 2020 戦略

ドイツ : デジタル戦略2025

中国 : インターネットプラスAI3年行動実施

製造業のデジタル戦略

ドイツ : インダストリー4.0

中国 : 中国製造2025#G検定

ツイッター拾い物

#G検定 6-6

— ユウキ | Kaggler (@No1Yuki33937424) 2020年6月10日

・強化学習は行動の結果としての報酬を最大化するように学習する

・入出力がペアになってるわけではないので、教師あり学習とは異なる

・深層学習を組み込んだ深層強化学習により研究が活発化している

かの有名なアルファ碁は

これを利用してます!#駆け出しエンジニアと繋がりたい

#G検定 7-2

— ユウキ | Kaggler (@No1Yuki33937424) 2020年6月11日

・word2vecは、単語をベクトルとして扱う手法

・word2vecに触発され、fastTextや

ELMoなどの文字の情報を含める手法が誕生した

・CNNと言語モデルを組み合わせると

画像脚注付けが可能にる

・RNNはニューラルチューリングマシンにも応用されている#駆け出しエンジニアと繋がりたい

#G検定 7-3

— ユウキ | Kaggler (@No1Yuki33937424) 2020年6月12日

・RNNの聴覚、音声分野の応用に

Wavenetがある

・Wavenetは音声認識と音声合成の

両方を行うことができる

・合成された音声は、既存の手法より人間に近いものとなっている

7-3は2ページしかないので短めですね

んー、自分で実装したい...#駆け出しエンジニアと繋がりたい

#G検定 7-4

— ユウキ | Kaggler (@No1Yuki33937424) 2020年6月14日

・アルファ碁は碁盤認識にCNN、

次の手の選択にモンテカルロ木探索を用いる

・強化学習の改善には方策ベース、行動価値関数ベース、モデルベースがある

・意思決定行動を改善する手法も上述と似ており、全部入れるとRAINBOWモデルとなる#駆け出しエンジニアと繋がりたい

#G検定 8-1

— ユウキ | Kaggler (@No1Yuki33937424) 2020年6月15日

・ディープラーニングは不良品検出、予兆検知、バラ積みピッキングなどに

も応用されている

・不良品検出では、不良品のデータは僅かであるから、良品から学習して、異常検知アプローチを用いて不良品を検出する#駆け出しエンジニアと繋がりたい

#G検定 8-2

— ユウキ | Kaggler (@No1Yuki33937424) 2020年6月17日

・無人自動走行による移動サービスを2020年に、高速道路でのトラック隊列走行を早ければ2022年に商業化することを目指す取り組みがある

・そのためには、実証実験の実施や

法整備が不可欠

・他にも、ロボットタクシーの計画もある#駆け出しエンジニアと繋がりたい

#G検定 8-3

— ユウキ | Kaggler (@No1Yuki33937424) 2020年6月18日

・ディープラーニングは、内視鏡画像診断などの診断支援にも用いられる

・創薬の分野でも開発コストの削減や高速化に役立っている

・ゲノム解析にも応用して患者の特性に合わせた治療が試みられている

・説明責任が問われる分野への適用には課題あり#駆け出しエンジニアと繋がりたい

#G検定 8-4

— ユウキ | Kaggler (@No1Yuki33937424) 2020年6月19日

・今後、少子高齢化により介護職員への負担が予想されるため、その軽減に

ディープラーニングが用いられている

・着衣介助などだけでなく、介護初心者に対するコーチングにも応用されている

・介護者の心理的負担の軽減にも貢献している#駆け出しエンジニアと繋がりたい

#G検定 8-5

— ユウキ | Kaggler (@No1Yuki33937424) 2020年6月24日

・ディープラーニングはインフラ領域に様々な形で応用されている

(コンクリートひび割れ検出、舗装道路損傷判断、橋梁内部の損傷推定、送電線点検、トンネル切羽、廃棄物選別など)

・他にも、防犯や監視にも応用されている#駆け出しエンジニアと繋がりたい

#G検定 8-6

— ユウキ | Kaggler (@No1Yuki33937424) 2020年6月24日

・タクシー需要予測にオートエンコーダ系技術が応用されている

・ディープラーニングによる

来店者情報把握で人員やディスプレイを最適化する試みがある

・無人コンビニ実現に向けた取り組みがある

・双腕型マルチモーダルロボットが

開発されている#駆け出しエンジニアと繋がりたい

#G検定 8-7

— ユウキ | Kaggler (@No1Yuki33937424) 2020年6月25日

・ディープラーニングは

物流(物流画像判別など)、

農業(収穫・仕分け支援、

農薬散布の最適化)、

金融(不正取引検知など)、

学習(先生の声、

黒板の文字の検索対象化など)、

インターネットサービス(ユーザコメント分析など)

にも応用されている#駆け出しエンジニアと繋がりたい

#G検定 9-1

— ユウキ | Kaggler (@No1Yuki33937424) 2020年6月26日

・法は人の行為や技術開発を制約することがある一方で、イノベーションの自由を支えている

・倫理はイノベーションを阻害するものと捉えられがちだが、現在のAIにまつわる倫理の議論は多様化する

「価値」に関することが多い#駆け出しエンジニアと繋がりたい

#G検定 9-2

— ユウキ | Kaggler (@No1Yuki33937424) 2020年6月27日

・プロダクトを考える際には、

ディープラーニングを使うことが

目的化しないように気をつける。

機械学習の方がいいことも多々ある。

・バイ・デザイン(開発段階からプライバシーやセキュリティの観点を考慮する)ことで価値を設計として埋め込む#駆け出しエンジニアと繋がりたい

#G検定 9-3

— ユウキ | Kaggler (@No1Yuki33937424) 2020年6月29日

・データを使う際には、著作権法、

不正競争防止法、個人情報保護法などの制約に留意する

・契約を結ぶときには、役割と責任を明確にする

・データセットに潜在する偏り

(現実世界の偏り、データベースに登録されていない情報がある、など)に留意する#駆け出しエンジニアと繋がりたい

#G検定 9-4

— ユウキ | Kaggler (@No1Yuki33937424) 2020年6月30日

・データを加工する際にはプライバシーに配慮する(特徴量を抽出して元データは速やかに破棄するなど)

・目標間のトレードオフ(透明性とセキュリティなど)は優先順位をつける

・ハッキングや不正アクセスの可能性も踏まえ、「絶対安全」は無いと心得る#駆け出しエンジニアと繋がりたい

#G検定 9-5

— ユウキ | Kaggler (@No1Yuki33937424) 2020年7月1日

・プロダクトは、知的財産として守られなければならず、知的財産法が整備されている

・データを集めた当初とは違う目的で使用する際には再び本人の同意が必要で、法に触れないとしても倫理的な配慮も必要

・AIの予期しない振る舞いには注意を払う#駆け出しエンジニアと繋がりたい

#G検定 9-6

— ユウキ | Kaggler (@No1Yuki33937424) 2020年7月2日

・クライシスマネジメントでは、

想定される危機について考察し続けるほか、「防災訓練」をしておくことも大切

・対応策は社会にアピールする他、プロダクトデザインに反映することが大事

これで最後です!

見てくれた皆様

ありがとうございました!#駆け出しエンジニアと繋がりたい

#G検定 6-7

— ユウキ | Kaggler (@No1Yuki33937424) 2020年6月10日

・深層学習は、画像などの識別タスクだけでなく生成タスクにも用いられる

・VAEは、データの空間分布を統計分布に変換してデータ生成に用いる

・GANは、画像を生成する側(ジェネレーター)とそれを識別する側(ディスクリミネーター)を競わせて学習する#駆け出しエンジニアと繋がりたい

#G検定 7-1

— ユウキ | Kaggler (@No1Yuki33937424) 2020年6月11日

・一般画像認識の手段にR-CNNがある(画像の切り出しは非CNN)

・fastRCNNは切り出しもCNN。

他にもfasterRCNN、YOLO、SSDなどがある

・セマンティックセグメンテーションは画素単位で識別する

・インスタンスセグメンテーションは物体ごとに識別する#駆け出しエンジニアと繋がりたい

G検定まで1日

— モブ@aiエンジニア (@mobwin_) July 2, 2020

データの欠損値処理

欠損データ削除系

・リストワイズ:データが欠損した行を削除

・ペアワイズ:列を絞ってリストワイズ

欠損データ埋める系

・線形補間:前後のデータで線形近似

・スプライン補間:前後のデータで非線形近似#G検定

その他見つけたチートシート

試験本番用に見つけたのはこちらです。

3つも4つもあると検索の効率が悪くなりそうなので、自分用のチートシートを作るにあたっては参考にしませんでした。基本は最初にあげたものと、自分のもので済むようにするという方針でした。

ただ、本当にわからない+時間が余ったら調べてみようという選択肢として手元においておくと安心感がありますよね。

【AI入門・G検定】JDLA Deep Learning for GENERAL 2018#1 推薦図書キーワードまとめ - Qiita

内閣府関係(ものすごい量)

https://www.kantei.go.jp/jp/singi/it2/kettei/pdf/20190607/siryou9.pdf

https://www.iais.or.jp/wp-content/uploads/2017/09/457d1fa6b6ed9714a5909e69ed36cf9f.pdf

いろいろあって有用そうなのですが、いかんせん細かくて見えない、、、

9. G検定①_AIの歴史_G検定のシラバスに沿ってAIの歴史をマインドマップにまとめてみました|weekly_business_mindmap|note

プログラミング未経験だとpythonの学習がなかなか定着しなかったけどskillupAIとudemyがよかった。【研究者・技術者・データサイエンティスト向け】

こんばんは、へるもです。

実はこのブログは当初はpytoneの勉強記録みたいなのを残そうと思って作った側面もあり、最初の記事はpythonについてでした。ただ、続かない、、、

やってみて改めて実感したのですが、プログラミング未経験の管理人にとってpythonを学習するというのは「新たな言語を覚える」ということに近いです。語彙を勉強して、文法を覚えて、使用シーンを想定して文章を作って、応用できるようにして、、、多くのステップを踏まないといけません。

この2年間は勉強して諦めて、の繰り返しでした。

最近はやっとpythonが身についてきたと思います。プログラミング経験0の研究者の管理人がpythonの勉強方法についてつらつら書きたいと思います。

まだ使いこなせているわけではないので、こんな勉強方法を試した人がいるんだな、と気軽に読んでもらえれば幸いです。

やっと軌道にのった

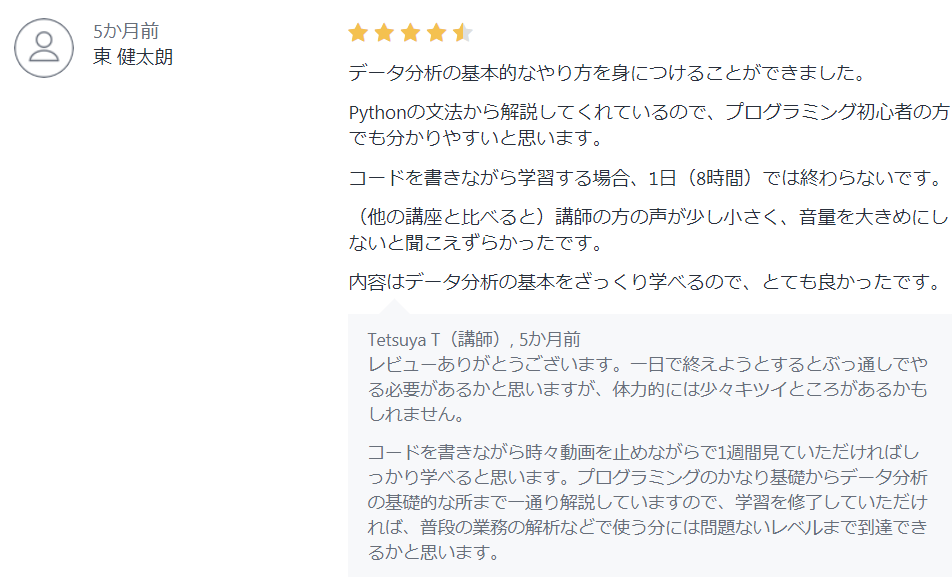

いろいろと試す中で一番身に付いた、と感じたのはskillupAIという会社の入門講座でした。1時間くらいの動画が8個あり、基礎→numpy→pandas→matplotlilb→、というように、最低限必要な内容を少しずつ勉強していく内容になっています。

私が見たときはコロナ関係で4/30まで無料だったので、それで勉強しました。

ついにDay 8までやり終えた~!

— はやなり🐻 (@hxmKuma) March 28, 2020

Pythonの基本文法から、NumPy, Pandas, Matplotlib, Seabornといったライブラリの使い方、titanicをもとにした前処理・モデル構築の方法まで網羅的に説明してくれる講義!#python

JDLA期間限定 機械学習のためのPython入門講座 - skillupaihttps://t.co/kpYPCi3fTB

よかった点①実際にモデルを使いながら手を動かす学習になっている

モチベーションという意味で一番よかったのはここです。

この学習動画ではタイタニック号の乗客の生死を分けたのは何か調べる、という最終的なoutputが明確でした。いわゆる多変量解析をpythonを使って行います。基礎文法であったとしても、勉強している内容が何の役に立つのかが想像しやすかったです。

加えて、自分でやりたいことに近かったのがよかったですね。これが終わればあんなことができる、こんなことができるという「自分にとってちょっとよい未来」を思い浮かべることができるのは勉強のインセンティブになりました。

ほかの動画で意外と多いのは、基礎構文を書いてこれはこういう意味で、というものをひたすら連ねていくものです。それを使って自分がどのように使うのかという場面を想像することが難しく、私は苦痛でした。

よかった点②講師がいい人っぽい

これは自分でも意外な点でした(笑)講師がすごく”いい人”っぽいんですよね。職場でも部活でも聞いたらにこやかに教えてくれる先輩っているじゃないですか。あんな感じです。

私は動画学習だけだったので講師の方とコミュニケーションをとる機会はありませんでした。その状況で講師の態度で勉強するしないを決めるなんて馬鹿なのか?と思う人がいたら全力で同意する(した)部分です。

ただ、無機質にカメラに喋りかけているようなものだったり、イラついているように見えたりしているものだと、なんか学習意欲がしぼんでいくのが分かりました。TOEIC対策の動画なのですが、こんな感じ。

https://www.youtube.com/watch?v=pmeV-dDoioc

やっぱり新しい知識に触れるというのは本能的に不安なことなのでしょうね。そんななかを突き進むにあたっては頼りにできると思わせてくれる講師だと、余計な心配をしなくてもよいというのは無視できないメリットなのかもしれません。

個人的にはvtuberとか、どこかでやとった美女あたりが講師になればもっと普及するのでは?と思います。(笑)動画学習なら台本をよめばいいだけですしね。

コスパはいいのか

費用は3~4万円のようです。金額的には何とかなるレベルですが、ちょっと高いです。

ただ、英会話学習でも例えばベルリッツだと3000~6000円/40分とかです。先ほど紹介した講座だと総学習時間が8時間くらいなので、学習時間に対する価格という意味ではそんなもんじゃないかなと思います。

だらだら勉強しないまま機会損失を増やすよりは動いてしまったほうがよいですし。

udemyもよい

ほかの選択肢だとudemyとかもありますね。

一日で習得とありますが、これも8時間くらいです。初心者がやるともっと時間がかかります。

こちらは基礎文法を勉強していく色合いが強く、少し我慢が必要でした。しかし、pythonを使うための環境構築の講義もあり、基礎的な部分を押さえているのでこれはこれで全然よいと思います。

実際、評価も高いです。

udemy公式サイトより

これだと1万円くらいでぐっとコスパがよくなります。

skillupAIの講座をお勧めする内容を書いておいてあれですが、第一歩はこれがよいのだろうな、と書いてて思いました。これで続かなかったらskillupAIのほうを選べばよいです。

udemyとskillupAIの講座で被る部分はたくさんありますが、そこは心配後無用です。一回やっただけで覚えるなんて不可能です。(笑)私はudemy→progate(後述)→skillupAIと勉強していきましたが、skillupAIはいい感じの復習になりました。

progateや本は?

正直、こちらについてはお勧めできません。

特にprogateの課題はお店の注文システムを作ろうというものでした。データサイエンティストを育成するという視点はまったくありません。

本もいくつか試してみたのですが、こちらも微妙でした。やっぱり自分で読む、より誰かに説明してもらう、というほうがエネルギーを使いません。より多くのエネルギーが必要な本媒体の勉強だと、詰まったときにあきらめる可能性が高いように思います。

現状

おぼろげながらに見えてきたので、ぐぐりながら少しずつ試しています。

とりあえず回帰分析はできるようになってきたというところです。

MI(マテリアルインフォマティクス)ではよい物性を出すための組成予測が肝になってきます。そこらへんがまだできていないので、今後調べていきたいです。

【レアジョブ】129時間勉強した体験談 意志が弱い人にはレアジョブが一番お勧め

こんばんは、へるもです。

仕事で必要になったのでオンライン英語学習サービス「レアジョブ」を2018年の冬から続けてきてきました。毎日1レッスンだったり、月に8日だったり、回数はさまざまですが、今は日常生活の一部になっています。

レアジョブでの勉強時間はおよそ130時間くらいです。1年くらい続けていたにしては少し少ないですかね。それでも、確実にブラッシュアップされているのを感じることができるのでやっててよかったなと思います。

友達と海外旅行をしたときに英語を喋れるのが自分だけだったのでちょっとリスペクトされたのが気分よかったです。まじで喋ってる、、、、みたいな(笑)

諸事情でストップしたのですが、いいきっかけなので、レアジョブの学習体験談(口コミレベルですが)を書いてみます。

1~2ヶ月で英語に対するストレスが急落する

感覚的には20~40時間に上達を感じる最初のポイントがあり、分からないことがあっても混乱することが減ってきました。

レアジョブを開始したときは、相手が何を言っているか分からないことが多く、あの単語はなんだっけと考えているうちに会話が途切れたりしました。そしてそれにあせり、どんどん平常心が保てなくなるということが多かったです。

たとえば外国人観光客に急に英語で話しかけられるとあせりますよね?そんな感じのあせりが最初はあったように感じます。

今考えるとなぜあんなにあせる気持ちがあったのかが分からないのですが、中国語やスペイン語で話しかけられてもあせらないであろうと考えると「中途半端に分かる」ことが原因なんだろうなと思います。

義務教育を経ていれば相手が疑問系で質問していることくらいはなんとなく分かりますし。

20~40時間を経ると、分からないものは分からないと、なかば諦めの心を持って冷静な気持ちで英会話を進めることができるようになりました。(笑)分からないことに慣れてくると、それにあせることがなくなるんですよね。

こうなると、自分が分かる語彙で会話をつなげるにはどうしたらよいんだろうという生産的な思考ができるようになり、会話を続けることができることが多くなったように思います。

個人的には、焦らなくなったというのが大きくて、これが自信にも繋がりました。自身というのは大げさかも知れませんが、うまくいかなくても「焦りはしなくなったし上達はしている」と思うと気が楽になりました。成功体験って重要ですね。

この焦り、そこからくる不安感は英語学習を避けてしまうレベルのストレスになり、学習の妨げになります。そのため、1ヶ月~2ヶ月続ければその不安感が取り払われる、ということは最初は強く意識するのが重要かなと思います。

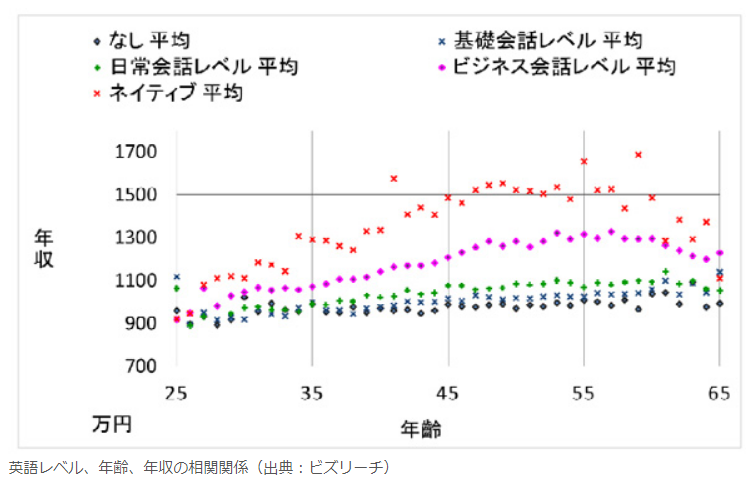

不安感さえなければ、英語学習を続けることはそれほど難しくありません。そうなれば、毎日25min間おしゃべりするだけで、スキルを身につけることができ、旅行がより楽しくなったり、将来の職業への不安を少し取り払えるようになります。(例えば下記のように英会話能力と年収には相関があるといわれています。)

英会話に40時間以降は徐々に慣れていく

40時間くらいまではかなりのペースで改善したように思います。ただ、それ以降は急激な進歩ということはあまりなく、少しずつ英語になれていったとう印象です。

振り返って考えてみると40時間までの伸びというのは、これまで自分の中にあった学習の貯金を使っていたのだろうなと思います。ある程度の貯金を使い果たすと、次のレベルに達するにはまた経験値をつむ必要があり、その期間は成長が実感しにくいのでしょう。

意志の弱い人にはレアジョブが一番おすすめ

こう書いてみると英会話の取得というのはシビアな世界で、着実な積み上げがやはり必要です。聞いているだけで口から英語が、なんていう宣伝を聞きますがあんなん絶対嘘で、習得には多くの努力と時間が必要です。

オンライン英会話サービスをやって英会話能力が伸びた一番のポイントは、毎日触って習慣化することで習得に必要な時間を稼げたというところかもしれません。学習の時間はだいたい予約制なので、授業が終わった後に次の授業を予約してしまえば、次に英語を勉強しないといけないタイミングが自動的に決まります。

自分で予約をしているので自動というのはちょっと違うのですが、例えば独学で文法を勉強しようとするときに、1日の中でいつ勉強するか、という部分に自由度を持たせてしまうと、とたんにサボりだすのが目に見えています。

風呂に入ったらやろう、いやご飯を食べてから、いや今日は夜が遅いから明日まとめてやったほうが効率がいいはず、、、そんな風に自分に言い訳をしながら結局勉強をしないというのは私はよくあることです。

skypeをスマホにいれるんだ

その点、例えばレアジョブならskypeを使って勉強するということが選べます。これが凄くよくて、勉強する場合は時間になったらskypeで呼び出されます。(笑)まぁ呼び出されているわけではなくて、講師からのcallが入っているだけなのですが、相手からのアクションがあるというのは凄くよかったです。

昔はskypeを使うのがスタンダードだったのですが、DMMのように独自のプラットフォームを使うところも増えてきました。こうなると呼び出されるのでなくて、自分でレッスンルームに入る必要が出てきます。

こう考えると、同じオンライン英会話サービスでもDMMはマンツーマンの塾みたいで、skypeを使用できるレアジョブは家庭教師みたいです。自分から行くのではなく、家庭教師のように相手からアクションを取ってくれるというのは継続するという点で重要な要素だなと思いました。

レアジョブさんはskypeの使用を継続し続けてくれたらいいなと思います。この先生からのcallを入れてもらえるという点で、意志が弱い方にはレアジョブが一番お勧めできるものとなっています。

レアジョブについての過去の記事です。

python エラー対処の覚書

自分用のメモです。

あるオンラインテキストでpandasを使った処理をしたら下記のようなエラーがでた。

調べた感じ、pandasのバージョンが古いことが原因っぽい。

No module named 'pandas.core.internals.managers'; 'pandas.core.internals' is not a package

PCに入っているpandasのバージョンを調べてみる(下)と0.23で、新しいものは1.0も出ているらしい。

いきなり1.0までupdateして不具合が出るのも嫌なので0.25をupdateすることに。

print(pd.__version__)

pd.show_versions()

cmdでコマンドプロンプトを呼び出して>"pip install pandas==0.25"と打ち込んで少し待ったらインストール完了。古い0.23はアンインストールされたっぽい。

jupyter notebookが機能しなくなったので若干あせったが、再起動したら特に問題なく動くようになり、上のエラーもでなくなった。

めでたしめでたし

GWは漫画を読もう。電子書籍がまさかの実質70%offも!? bookwalkerのセール情報(~2020/5/7)

まさかの実質70%off!? セール情報(~2020/5/7)

bookwalkerでとてもお得なセールが告知されていたので、情報シェアです。

他の記事にもいくつか書いていたのですが、ぺたぺた貼るのが面倒になってきたので記事にしました(笑)

bookwalker公式サイトより

ちなみに5月7日までbook walkerでコイン40%還元セールが行われており、一部はなんと半額というとてもお得なセールが行われています。

つまり、漫画は200円弱で購入できるという、、、book walkerは購入後に15分後でコインが還元されるので1巻を購入したコインで2巻を買うことが出来るという素晴らしい制度を誇っています。

ヤフーとかメルカリとかで1ヵ月後にポイントが還元されて、だけど何を買おうと困ることが多いのですが、bookwalkerは余すことなく使えるんですよね。

あと、幼女戦記はあまり関係ないですが、 管理人のお勧めをちょっとだけ紹介しておきます。

bookwalker公式サイトより

この中だと、半額+コイン45%還元に当てはまるのは「幼女戦記食堂」「異世界おじさん」「ガンスリンガーガール」「ロード・エルメロイⅡ世の事件簿」ですかね。

ガンスリンガーガールはそこそこ古い作品なのですが、ランキングの上のほうにあるのがうれしい。きっと大人がこのタイミングで大人買いしているんだろうな。

あと、異世界おじさんは今伸び盛りな作品で最新刊が凄い売れたらしいです。その内アニメ化するんじゃないかなぁ。セガが出てきたり、35歳のおじさんがギャップに驚いたりする部分は30代陰キャの共感を絶対に得れると思うので、これも読んでほしい作品ですね。(笑)

どれも面白い作品なので、コロナで暇な方は是非どうぞ。

漫画「幼女戦記」18巻 感想 【朗報】ドレイク大佐 超かっこいい【朗報】ターニャとヴィーシャの結婚式開催

こんばんは、へるもです。

幼女戦記18巻の感想です。

ネタバレを含むのでご注意ください。

表紙

幼女戦記18巻より

おー表紙にヴィーシャがいる!扱いもでかい!

管理人は漫画の表紙が好きなので、ついつい変化を追ってしまいます。

最初はターニャしか登場していなかったのですが(9巻のメアリー除く)、どんどん中隊長が出てくるようになりましたね。

幼女戦記15-18巻より

こうやって見比べてみると一目瞭然。特にヴィーシャは徐々に占有面積が大きくなってきているのが解ります。

ターニャしかいなかった表紙に色々な仲間が入ってくるというのは物語とのリンクを感じて良き。

ターニャ、というか中身のおじさんは前世を含めて友達いなさそうでしたが、今は同じ釜の飯を食べる仲間がたくさんいるぜ!

百合百合しい

ターニャだけだと寂しいなぁと思っていたので、表紙の変化は毎回楽しみにしていたのですが、まさか幼女戦記の表紙がこんなに百合百合しいものになるとわ、、、

二人の格好からなんとなくウスイホンを思い出してしまって、作者攻めてるな!と驚いしてまいました。

皆さんはどうでしょうか?ヴィーシャが慈愛の笑みを浮かべているので下品ではまったくないのです。

が、表紙にこんなに直球を持ってくるとはと思ってしまうのは、心が汚れてしまったからでしょうか。

というか、これ何しているポーズなんですか?(笑)

最初は”くっついて光っている”画の意味が解らず、光っている部分を拡大して何が光っているのか確認してしまいました。光っているのは宝珠ですね。

が、なぜ光っているんだ、、、

衝撃と畏怖

綺麗に決まった衝撃と畏怖作戦。地下に穴を掘って野戦軍を殲滅するなんて恐ろしいことを考えるものです。

ちなみに付録にもあったパッシェンデールの戦いですが、史実ではドイツ軍1万人が消し飛びました。

夕張市の市民が7000人くらいらしいですが、都市ひとつ分の人間が一瞬で死んでしまうというのは想像しにくいですね。

幼女戦記18巻より

本作戦はライヒの集大成だけあってターニャが出会ってきた仲間たちが多く描かれていました。技術将校→ラインの古参→参謀→海軍、かな。

ラインの古参はショーンズでしたっけ?ぶち抜きのコマがかっこよかったですね。

幼女戦記15-18巻より

戦いは優勢に進みますが、、、あかん。それはフラグや。

「やったか、、、?」くらいの戦争は終わらないフラグや。(絶望)

ターニャの戦い

幼女戦記15-18巻より

ターニャの参加した戦いが並べられたこの演出が凄い好きです。

RPGとかで最終決戦前に仲間と会話できるイベントがあったりしますが、それと同じような雰囲気を感じます。

管理人は最終到達地点の少し前で、思い出話をしたり、改めて出会った頃からの変化を楽しんだり、といったシーンが大好物です。

過ぎ去った時代は終わったものとして扱われてしまいますが、それでも過去があるから現在と未来があるわけです。

たとえば運が悪ければターニャの物語はノルデン沖遭遇戦で終わっていたかもしれません。

でも、そうはならなかったから”物語”は連綿とつむがれ、最終決戦にまで繋がりました。

あるいは誰かの”物語”はターニャに踏みにじられて終わってしまいました。

そういった郷愁を少ない言葉で雄弁に語ってくれる演出だったと思います。

特に原作を読んでいる派は、同じストーリーを淡々と描かれてもなかなか物語に入っていけません。

こうした演出の巧は漫画版幼女戦記のよさの一つですよね。

ドレイク大佐かっけぇええ

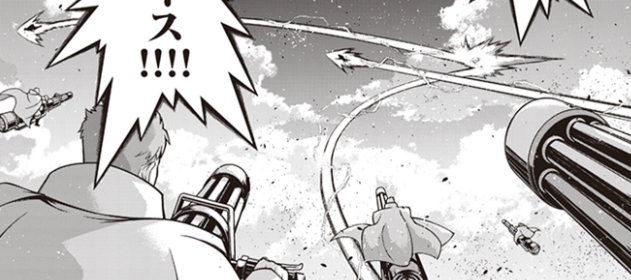

原作ではドレイク中佐(大佐の甥かな?)と戦うシーンで、あまり激しいシーンではありませんが、漫画版では相変わらず大幅に補完(改変)してきました。

このシーンがまたカッコいいんですよねぇ。

たくさんのおっさんが出てくる幼女戦記ですが、管理人的イケおじNo.1はドレイク大佐になりました。

戦闘当初はひたすら蹂躙される「幼女強い」展開の焼き増しで、ぶっちゃけ読み飛ばしていました。

強いていうならグランツがヴィーシャをかばったところで「お?逆じゃないのか?」と思ったところくらいにしか気を払っていませんでした。

が、各個撃破になってからはまじで無双!!

接近戦は苦手なはずの装備なのに、ノイマンもケーニッヒも接近戦で撃破してしまいます。

ケーニッヒは装備的に魔道刃(=接近戦)が得意そうなのに、彼からすると赤子も同然の扱いです。

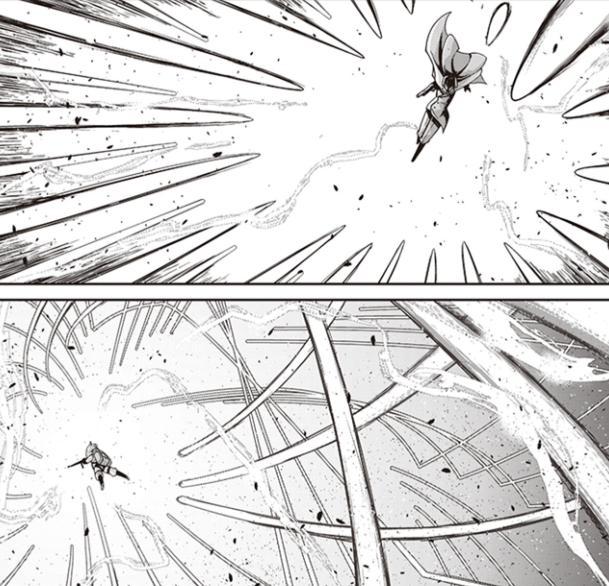

ターニャの上位互換

幼女戦記18巻より とんで火にいる夏の虫(ヴァイス)

加えて、彼が凄いのは個人技だけではなく、ちゃんと集団戦のリーダーとして機能しているところ。

それが解るのがヴァイスとの戦いです。

彼を撃破するに当たって立てた作戦は「吊り野伏せ」、つまり誘引と撃破です。

自らを囮にヴァイスを釣りだし、自らの部隊に狙撃させました。

これはターニャ大隊の中隊長と戦いながら、「ターニャたちを抑える」+「狙撃部隊に用意させる」+「敵を狙撃部隊のキルゾーンに誘い出す」の3段階を楽々と行ったということですね。

まじで凄くね??

慢心のないおっさんは強い

幼女戦記18巻より

デコイや速力、高度、乱数回避起動、現世仕込の突飛な発想などで圧倒的な戦力と戦術で敵に”対応”を押し付け、処理能力に負荷をかけるのがターニャたちのこれまでの戦いでした。

が、今回はドレイク佐一人にお株を奪われた形です。

強い!!

自分を山賊や海賊に例えているのは慢心していない感じでとても良いですね。

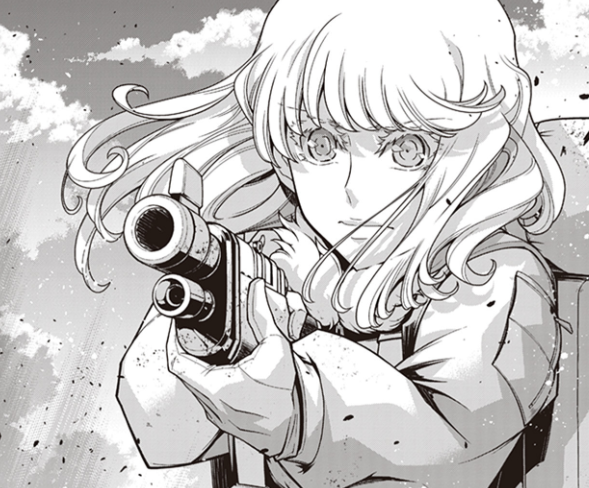

エースの戦い

中隊長でも歯が立たず、期待のルーキーグランツ君もあっさりやられる実力者が敵に回ったということは、ターニャの出番です。

この戦いは何気にアルビオンとライヒの最強の個がぶつかり合っている戦いかもしれませんね。

少年漫画的で熱い展開です。

幼女戦記18巻より

展開のほうも短いながら納得の出来。

スピード感があって凄く良かったです。

直線的な物量攻撃を仕掛けるのがターニャなら、放物線上の起動で相手を絡めとるのがドレイクです。

戦い方に違いがワールドトリガーでいえば出水 vs. 那須さん的な感じです。どっちもこぇ~

ここは是非アニメーションで見たいなぁ。

幼女戦記18巻より

ってかこのおっさんやっぱり強い。

腕をぶった切られても、ロケットパンチで魔道師の防殻をやすやすと抜いていきます。

97式も破壊され、近接戦闘でも圧倒され、ガチのマジの追い詰められ方。

ドレイク vs.ターニャの戦いは趨勢が決しました。

ただし、これはタイマンじゃないんですよ。

なんといっても、、、

バディ

幼女戦記18巻より

ターニャにはバディがいるからね!

ピンチを救うのはもちろんヴィーシャです。

”最強の個”同士の戦いはアルビオンに軍配が上がったといえますが、ターニャにはヴィーシャがいます。彼女の援護により辛くもピンチを切り抜け、逆に敵を圧倒します。

戦いを決めるもの

なんでヴィーシャだけ戦いに割ってはいれるねん、と「この展開を書きたいがためだけのご都合展開」を疑ってしまいそうになりますが、管理人としてはヴィーシャの列機としての能力が高かった説を推したいです。

というのも、この戦いは明らかに異常です。

ジャンプ的な戦いならいざ知らず、本作品では”勝利を得るために”軍や大隊での連携をずっと書いてきましたし、何らかの連携をとってしかるべきなのにそれをしていません。

これはヴァイスやドレイクの副官(ドレイクの手下なのだからおそらく実力者)ですら付いていけないほど高度で複雑な戦闘で、援護に入りたくとも入れなかったのではないでしょうか。そう、ヴィーシャ以外は。

こう考えるとライン以来のコンビネーションが功を奏したというわけで、こういう展開はよいなぁと思うわけです。

二人だけの世界?

あーー名前読みにどんな意味が意味があるんだーーー乙女ならぬ管理人にはわかりません。

— 社会人はリラックスしたい (@kapVpjzVyO8N5Fl) April 25, 2020

見ようによっては動揺したヴィーシャがターニャに名前でよんでほしいとおねだりしているような、、、(邪推#幼女戦記

戦いの後の二人の世界は凄かったですね。何を見せられているんだ(笑)

ターニャごと撃って動揺するヴィーシャをターニャが受け止める展開が3Pほど続きました。

幼女戦記18巻より

このシーンはついったーでも言及されることが多く、原作からのいきなりの補完に驚き、歓喜する方も多かったようです。尊いってこういうときに使うんですね。(笑)

戦場での結婚式って面白い表現で、タイトルに使わせてもらいました。

これ、もう、幼女戦記アニメ放送当時からみんかが待ち望んでいたターニャとヴィーシャの戦場での結婚式じゃん…ずっと待ってた……

— 杏野 (@A_nn_no) April 18, 2020

幼女戦記18巻読んでるんだけどなんやこれ。ターニャとヴィーシャが尊すぎる。脳が破壊されたわ。

— 穂積@フェイントお兄さん(本人) (@NOSESS3601) April 24, 2020

ただ水を差すようであれですが、こういう描写を重くしすぎるとあれかなって思う自分もいたりします。彼女たちは軍人ですので、そのイメージからは離れてほしくないというか。

その点で、幼女戦記は限界ぎりぎりまで攻めきった感がありますネ(笑)

19巻は?

回転ドア作戦が終わって本巻は終了です。

2話で終了したことに驚愕です。本誌連載はどういう仕組みで回っているんだ?

今は原作3巻の半分くらいのはずなので、あと1~2冊で終わりそうだなぁ。

アニメ部分は原作の1~3巻のはずなので、その後の展開はどうなるのでしょうか。

ハイライト

話は特に繋がりませんが、好きなシーン、突っ込みたいシーンをぶった切りで紹介します。

出世ポニテ

中隊長二人はまだ表紙に出てきたことがありません。カラーにはなっているのですが、配置は袖なんですよね。

なのに、、、ポニテロッテさんは表紙デビュー!!

ケーニッヒももう一人も頑張っているし中隊長なのに優遇されるのはポニテ!!やはり男ばかりの中での少数派の希少価値というのは強いのか。見た感じ小さくて若いので、ヴィーシャと同じ幼年学校組=giftedなのかもしれません。

にしても、体の凹凸がないのになんかエロイのは凄いな。

3月のライオンもそうですけど、女性作者の書く女キャラの体のひねり具合が好きです。

カード狂い?

幼女戦記18巻より どや顔ヴィーシャ

カードに強い副官。

「少しは手加減してやるように」→「故郷の畑を増やそうと思います」という会話は成立しているのでしょうか。(笑)

手加減して畑レベルなのか、勝ってうはうはで少し変になっているのか、、、

しかも字が凄いメルヘンで、一緒にいるのターニャですよね。。。君ら結婚後の計画も立てていたのかな?

対空砲

幼女戦記18巻より

好き。

無双

幼女戦記18巻より

95式発動。

皆思っただろう、、、最初から使えよ、と。(笑)

カバーのあれが邪魔

幼女戦記18巻より

大活躍の大佐殿ですが、惜しむらくは裏表紙の大佐殿の勇士が中途半端であるところ。

途中から幼女戦記のカバーを袖+表紙+背表紙+裏表紙の一前画で載せてくれるようになったんですが、それでも価格とか入れる部分が白抜きになっているんですよね。

これまではあまり気にしていませんでしたが、今回はこの白抜きが邪魔だなぁと思いました。

その昔、バーコードは本の美しさを乱すといって本にバーコードを印刷することに抵抗した人たちがいると聞いたことがあります。 そのときは利便性に勝るものなしと抵抗した人を馬鹿にする気持ちすらあったのですが、、、これは確かに邪魔です。

欠損がかえって価値になることはあるんでしょうけど、やっぱり完全性というのは重要ですね!

いやぁおっさん強かったなぁという余韻があったのですが、おっさんよりでかい白い空白で興が削がれた気分になってしまいました。

おそらく漫画史上ここまでかっこいいおっさんは30年に一度しか生まれません。

貴重な姿がバーコードゾーン?なんかに毀損されるなんて文化の損失ですね。ということで原画も電子書籍のデータに入れてほしいなぁと思います。

ただ、そんなこと言っていたら帯入れてとか、どんどん作業が増えていくのでどこかに線を引かないといけないのはわかるんですがね。

(修正)

ドレイクとノイマンがあべこべになってました。指摘ありがとうございます。なんか違和感を感じてはいたんですよね。

セール情報(~5/7)

bookwalker公式サイトより

ちなみに5月7日までbook walkerでコイン40%還元セールが行われており、一部はなんと半額というとてもお得なセールが行われています。

つまり、漫画は200円弱で購入できるという、、、book walkerは購入後に15分後でコインが還元されるので1巻を購入したコインで2巻を買うことが出来るという素晴らしい制度を誇っています。

ヤフーとかメルカリとかで1ヵ月後にポイントが還元されて、だけど何を買おうと困ることが多いのですが、bookwalkerは余すことなく使えるんですよね。

あと、幼女戦記はあまり関係ないですが、 管理人のお勧めをちょっとだけ紹介しておきます。

bookwalker公式サイトより

この中だと、半額+コイン45%還元に当てはまるのは「幼女戦記食堂」「異世界おじさん」「ガンスリンガーガール」「ロード・エルメロイⅡ世の事件簿」ですかね。

ガンスリンガーガールはそこそこ古い作品なのですが、ランキングの上のほうにあるのがうれしい。きっと大人がこのタイミングで大人買いしているんだろうな。

あと、異世界おじさんは今伸び盛りな作品で最新刊が凄い売れたらしいです。その内アニメ化するんじゃないかなぁ。セガが出てきたり、35歳のおじさんがギャップに驚いたりする部分は30代陰キャの共感を絶対に得れると思うので、これも読んでほしい作品ですね。(笑)

どれも面白い作品なので、コロナで暇な方は是非どうぞ。