【レビュー】パナソニック 食洗器 NP-TSP1-wが都内の小さい家には最高だったー選定編

食洗器が欲しかったので色々比較しながら購入しました。

今は家電製品の購入時には、何がおすすめなのかブログやyoutubeで調べる人が多いのではないでしょうか。

私もその一人でいろいろ口コミやレビューを見て、最終的にNP-TSP-wを選びました。

その記録を共有したいと思います。参考になれば。

選び方

色々調べた限り、パナソニックが強く、値段や用途、水の入れ方で違うものを選ぶという感じでしょうか。

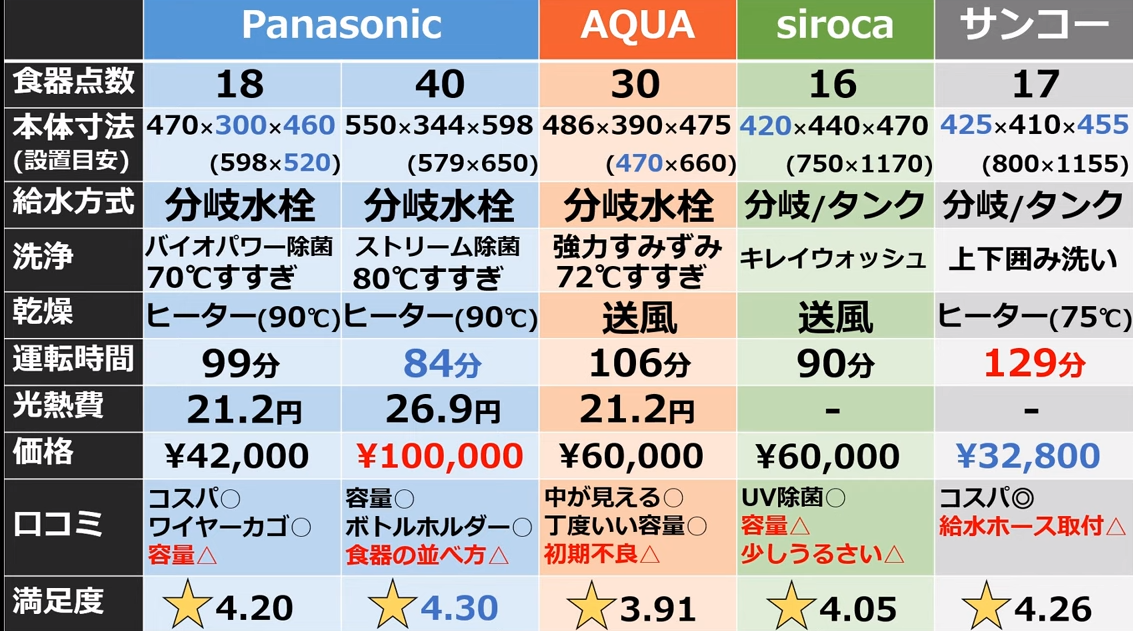

とりあえずざっと最初に調べてどんなものがあるのか確認しました。

大きな違いは①サイズ(おけるか、何人分の食器を一度に洗えるか)、②分岐水栓かタンクか、③価格、ですね。

(上の図のものは適当に引っ張ってきましたが、少し高いですね。実売1~2万円は安いです。)

①大きいに越したことがないが、おけるか不安

よく見たレビューに大は小を兼ねるというものが多かったのが印象的でした。

少なくてもよいと言っている人は一人暮らしという条件の人が多く、その時点で20点以下のものはあまり買いたくないなと思いました。

②分岐水栓はできれば避けたい

意外な落とし穴はここではないでしょうか。

自分でできるという動画もよくあがっていますが、工具をそろえるのに数千円かかりますし、分岐水栓自体も8000円くらいしました。自分でやっても1万円強、水道工事屋さんにお願いすると1.5万円強かかりそうです。

あと大家さんが食洗器アンチだったので分岐水栓に変えるという連絡をするのもちょっと気が引けました。

③価格は気にしない

お金があるから高いの一択でしょというわけではなくて、メルカリを見た感じ割とリセールバリューがあるなと思いました。

そもそも食洗器を買うというのは時間をお金で買う行為なので、価格を気にして中途半端なものを選んではいけないです。

選定品

上記のスクリーニングから選んだのは下記でした、、、

が、自分の環境を調べると置く場所がありません。

自分の家はよくある下みたいな間取りなんですが、食洗器を置く場所は食材を切っている場所か、冷蔵庫の上しかないんですよね。。。

前者に置くと自炊ができなくなるし、冷蔵庫の上には電子レンジがあります。そもそも冷蔵庫の上に水が流れるものを置く勇気がありません。漏水したら漏電して火事になりそうだし。

新発売!薄型食洗器!

最初に調べていたのは2021/6くらいだったのですが、おけねーなーと思って諦めていました。そして月日がたち、パナソニックが出してきたのがこちら!

NP-TSP1-w!

特徴は薄い+分岐水栓/タンクの両方が選べるという自分にジャストフィットする内容!

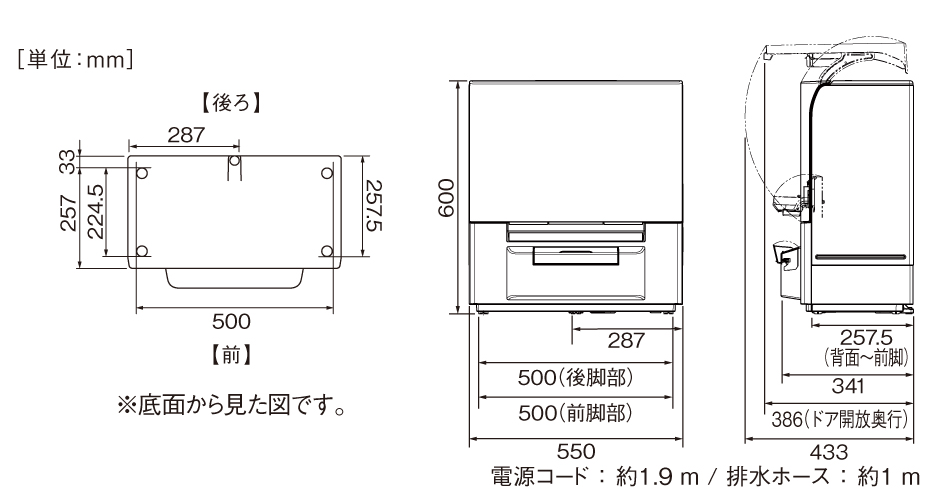

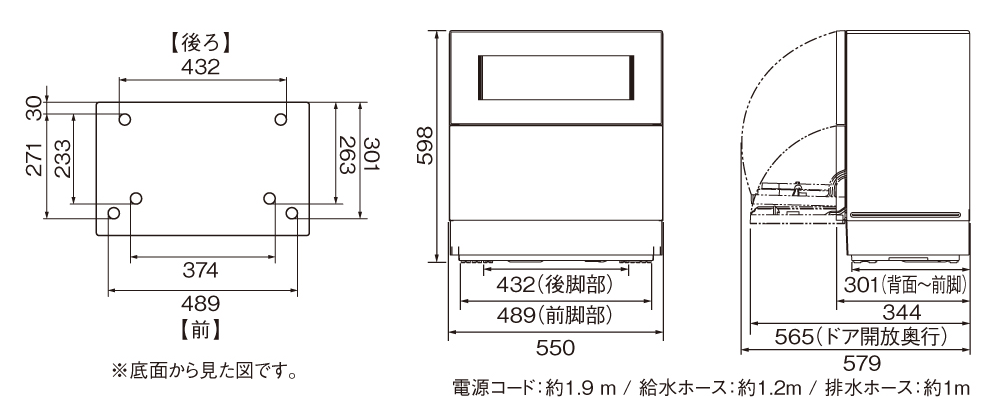

薄さはどれどれ、、、

スリムタイプ

https://panasonic.jp/dish/products/NP-TSP1.html

スタンダードタイプ

10cm薄い!

10cmって小さいと思った人もいるかもしれませんが、自分には結構重要でした。

上の図は公式からとってきていますが、まさにこんな感じにおいています。

冷蔵庫とキッチン台の間に15cmくらいの隙間があるんですよね。そこを使えば置ける。

ただ、自分の場合は置ける場所があったわけではなく、本当に隙間(空間)でした。そのため、DIYで幅20cmくらいの”ロ”型の台を作ってその上に置いています。

DIY、、、?と思った人もいるでしょうけど、DIYのところのおっちゃんに聞けば色々教えてもらいながら材料も変えるのでそんなに難しくないです。端材を使ったので1000円くらいの材料費とドライバー、ねじ、固定具を使って2時間くらいで作りました。

干渉がないのもよい

スタンダードタイプって扉がかなり低い位置で大きく開くので蛇口と干渉する可能性があったのが怖かったです。スリムタイプはそこは問題なさそうでした。ここもgood。

実際にサイズを測定して、これに決めた!

実売で8万円ちょっとでした。高いけど食器洗いが嫌いですし節水で安くなるらしいのでよし!(結構残業も多いので時間節約は本当に大きいです。とくに精神的に。)

使ってみて

いや、普通にいいですね。

この機種は高温洗浄ができないのでうまく洗えないのかなと思っていましたが、普通にきれいに洗えます。

ていうか、結構熱くなってます。触れないというほどでもないですが、湯気が出るくらいには熱い水で洗ってます。

うれしい誤算でした。

水汲み面倒!を解決

今はタンクを使っているのですが、水を入れるのに5回くらい汲んで→入れてをしないといけないのが面倒でした。ただ、これも色々な解決方法があります。

自分は下記の水中ポンプを買いました。付属の容器の中にこれを沈めて適当なホースを使えばがんがん入れてくれます。

食洗器なら分岐水栓なしで水を送れますし、かっこ悪くもありません。専門知識も必要ありません。

分岐水栓がないほうがよいからタンク式の食洗器であるsirocaやサンコーを選ぶ人もいるのではないでしょうか。それを選んだ方もこれを選択できるので一回試してみてはいかがでしょうか。

購入したのは2022年の頭だったのですが、早くも今年の買ってよかったものリストに上がる一品です。もう少し使ってみてレビューを追加したいなと思います。

漫画「幼女戦記」21巻 感想 幼女戦記(ギャグ) ネタばれあり

こんばんは。

実は21巻は出ないんじゃないか?なんて話していたのですが普通に出ましたね。

ちなみに記事が遅くなったのは刊行に気づかなかったとかではなく、単純に見るのが2度目だったからです。笑

webでも公開されているのを知ってからそっちで見てたんでなんとなくリズムが狂ってしまいました。

そんな幼女戦記21巻の感想です。

以降はネタバレがあるのでご注意ください。またこれ以降引用する画像は注釈がない限り、幼女戦記21巻からの引用です。

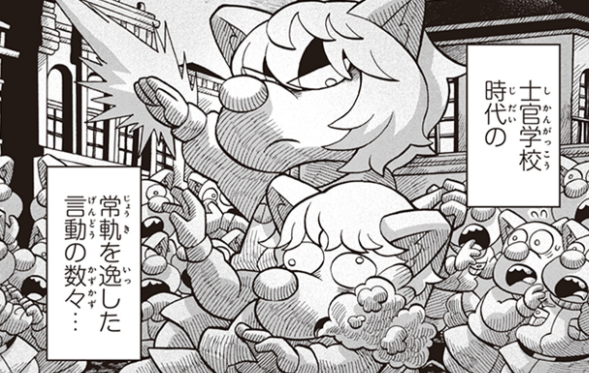

ぱっと振り返って

内容薄いな?!

漫画版の正統続編ではあるのですが、骨休めの巻末おまけを読んでる気分でした。なんか軽め。

別に悪い、面白くないと言っているわけではないです。(ここ重要

むしろ熱いシーンもそれなりにありました。

ただ、20巻までの数巻はつえーボスキャラと戦ったり、奮闘むなしく終戦にはたどり着かずターニャが珍しく弱気になったりと見所目白押しでしたよね。

しかし、、、

圧倒的な説明不足感。。!

今回は、ぽくぽくちーん。

えっどういうことなの?笑

よくわかんねぇ。

ぽくぽくちーん??

北アフリカに攻め入るには海を渡るので、陸上の陣地(橋頭堡)が必要なことはわかります。そのあとにそれを守り切るためには殴られっぱなしにならないように手を打つこともわかります。(陣地を広げたり、飛行場潰したり

しかしノリで決まったかのような展開と、ポリトリとかよく分からない地名で、流れの筋のようなものが頭に入ってこぬ。

ターニャおじさんのミリオタ解説がいかに読者の理解の助けになっていたかが分かるシーンでした。

この展開になった理由を考えるとしたらギャグシーンを入れたかったんだろうな、と。

戦史を紐解き微笑みを

幼女戦記はもともとギャグシーンが多いので、21巻にも笑いの場面を用意するというのは当然の流れです。

幼女戦記のギャグといえば「どうしてこうなった!」かマッドサイエンティスト。しかしマッドはともかく「どうしてこうなった」もここでは使えません。(理由は後述

そこで用意されたのがロンメル将軍のオマージュなのでしょう。

モデルになったロンメル将軍は今もなお人気のある方です。

その英雄的な人格と戦歴はもちろんですが、目立つのはその機動力。後続を置いてけぼりにするくらいの猛進軍を見せたりととにかく目立つ人でした。

それを語る人はちょっと面白そうに語るイメージです。ここで使えば爆笑間違いなし!(?

訓練された漫画家

しかし、、、これはミリオタ向け過ぎでは?笑

漫画を読んでるというより、戦史をなぞってこんな凄い(変な)将軍がいたんですよっていうYouTubeを見てる気分でした。

なんかあるじゃないですか、史実解説系の動画。コメント欄ではその戦史を始めて知った人がみんなで草生えるwっていっているようなやつ。あんな感じ。

実際の史実であればその奇想天外っぷりと、それにもかかわらずうまくいったという事実に好奇心が惹かれます。

しかし、フィクションだとなんかよく分からないノリだなと思ってしまいました。笑

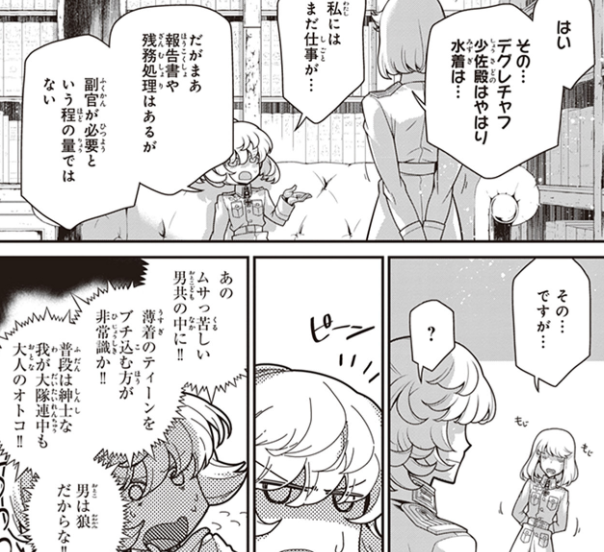

どうしてこうなったが使えない理由

今回の展開は「どうしてこうなった」が使えなかったからと書きましたが、この理由は単純に原作とはかなり異なるストーリー展開で、将軍目線で話が進むからです。

どうしてこうなった!はターニャおじさんが思惑とは違う状況に放り込まれた時に使う言葉で、ターニャの主観で物事を進めることが必須なんですよね。

それが今回は将軍目線で、ターニャは"駆けつけるヒーロー"、つまり第三者として登場します。なので「どうしてこうなった」が使えませんでした。

どうしてこうなっただけが幼女戦記ではないが

幼女戦記を成り立たせる3要素はギャグ、ターニャ無双、ヴィーシャとの結婚式なので、かっこいいターニャを書くのはある種のお約束です。

これまでもそんなシーンがありましたし、新展開の1ページとしてターニャを活躍させるというのは全然ありな演出でした。

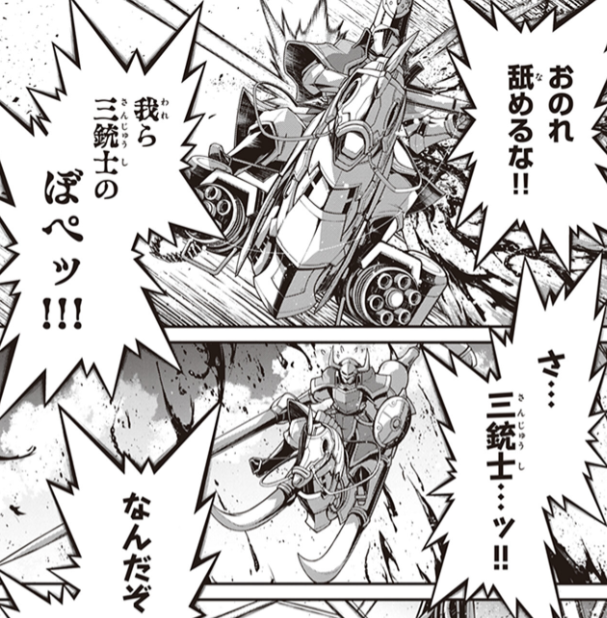

しかし、、、それを許さぬフランソワの雑魚敵感。

堕ちた品格

味方のピンチに現れるターニャおじさんに痺れる憧れるぅ!っていう楽しみ方が普段ならできたはずなのですが、、、

敵がよええぇ。

名も顔もなき三銃士や貴族みたいな人が噛ませ犬すぎて緊張感が息してなかったですね。

貴族みたいな人は結構重要な敵キャラのはずなんですが名前が思い出せません。

幼女戦記に限らず多くのアクションものは、強い敵やシビアな状況をいかにかっこよく切り抜けるか、いうところが重要です。

敵が輝くほど(その上をいく)主人公がかっこよく見えるものですが、敵が雑魚キャラ扱いだと味方もなんか強いんだか弱いんだか分かりませんね。笑

かくしてやたらとライトというかギャグちっくな幼女戦記になったなと思いました。

見所は

新展開の楽しみ方はなんでしょう。

個人的に印象に残ってるのはやっぱ新エース活躍シーンとロメールと組んで楽しそうなおじさんかなぁ。

エースオブエース

将軍付のエースが出てきました。

彼女はかなりの実力者のようです。ポニテさんといい、最近は(漫画の美味しさ的に)良い位置に来る魔道士は女性魔道士が多いですね。

10中8,9は読者受け(画面映え)を狙ったものだと思いますが、一方で敵キャラには女性があまりでてきません。狂犬メアリーくらいです。

こういうこと考えるとライヒの徴兵と教育戦略はうまくいってるんだろうなーとか、だからこその破竹の進撃なんだろうなーとか思います。

明言されていないこともちょっとした描写から読み取れ(妄想でき)、この一手が大変よい余白を作っているなと思いました。

ちなみに一連のシーンの後、空にピストルを撃ってる将軍のシーンもお気に入りです。

たった一コマですが、これまでの前線指揮官とは格が違う感じが一目でわかるいい演出でした。

まぁ遠距離で攻撃しろよとも思いますが、そこはエースの活躍があったということで。

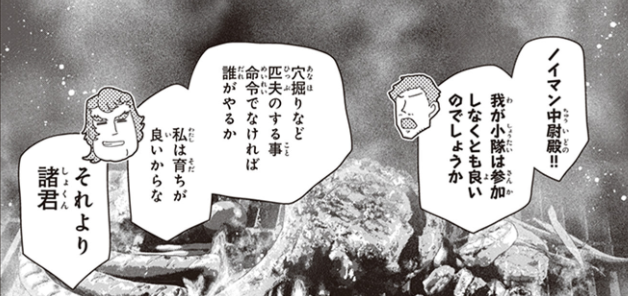

別にディスってないよ

今回は幼女戦記の弱みがあぶり出されたように思います。

それは、、ターニャ抜きにはストーリーが成り立たない!

なぜこう感じるか、完全に紐解くことができていないんですが、幼女戦記のサイドストーリーって想像しにくくないですか?

オンリーワンナンバーワン

たぶん、キャラクター達に因縁や悲しい過去がなさすぎる、勧善懲悪と困惑、葛藤のような悩みがなさすぎるのかもしれません。

部下に殺されて異世界転生したターニャだけなんですよね。ストーリーを動かすほどの内発的動機があるのは。

語ることがない観客と、喋り捲るターニャおじさん。劇の題名は異世界転生した世界で出世したい。そんな感じ。

実はフランソワで街を焼く時に葛藤するキャラもいるんですが、あまりにターニャおじさんが大正義すぎてダキア戦の焼き直しになっちゃいました。

(現代戦というものを見せてやろう!的なやつ)

結局ストーリーもキャラもターニャおじさんありきって感じですね。

前巻でのエーリャの語りはなんとなくこれまでとは違う色を幼女戦記に添えてくれそうな予感がありましたが、、

今後

先の展開をもう知ってるのであれですが、やっぱ着目したいのは原作では描かれなかった部分の描写ですよね。

これまでいい感じに補完されてきたと思うので、楽しみにしたいということで筆を置きます。

ユニクロ・無印良品・GUでそろえるメンズファッション初心者向けのお勧め2021 第一弾 婚活マチ婚合コン編

こんばんは。

この記事で書くこと

この記事では、ユニクロ、GU、無印良品で買えるおすすめのものをベースにして、上から下まで一揃いを紹介します。

とりあえず春にこんな感じ格好をしたらいいんでない?という形で書きますが、春夏でも秋冬でもカバーできるようなつくりにしたい(していきたい)と思っています。

だれが対象なのか?

基本的には20~30中盤くらいを想定しています。かなり幅が広いですが、スタンダードなものを選んでいるので問題ないでしょう。

その意味であれば30代後半以降でも問題ないように思います。ただ、管理人は34なので、40を越えた方に合うのかどうか、TPOをわきまえた形になっているかはよく分かりません。おそらく問題ないと思いますが。

キーワードは「合コン、婚活に参加する人」「脱オタしたい人」「大学デビューしたい人」あたりでしょうか。

ファッションセンスがない自覚があるけどどうしたらいいか分からない。そんな人に、まず無印、GU、ユニクロの服をおすすめして、自分が好きな服を選べるよう第一歩になればいいなと思っています。

なぜユニクロ、GU、無印良品なのか?

理由は3つあります。

①スタンダードな服であればここで十分だから

特に30代以降の人はユニクロなんて、、と思われるかもしれませんが、もうすでに市民権を得ているので全然問題ないです。

というか大量生産により良い素材をつかって安価な製品を出してくれています。すなわちコスパが抜群に良いです。

②日本全国各地で試しやすいから

セレクトショップなんて地方都市にはなかなかありませんし、取り扱っている期間も短いです。これらの会社であれば相対的に多くの数がありますし、オンライン販売も充実しています。

③気軽に試着できるから

試着はとても大事ですが、セレクトショップだと店員さんに張り付かれて鬱陶しいですし、断りにくいです。

その点、これらのお店は非常にビジネスライクなので、とりあえず着てみて、だめだったらやめてみて、が簡単にできます。

街コン、合コン、マッチングアプリでの最初の出会い

いきなりそんな出会いの場目当ての服かい。って感じですが、きれい目というのはどこでも使えますので、まず紹介させてください。

0スタートで最終的に二人きりの関係を作るのですから、信頼感がまず大事かなと思います。

中身とか分かるもんでもないので、フォーマルな装いのもつイメージである、信頼感や誠実さを借りてみます。

コーディネート

ジャケット+白シャツ(or 白Tシャツ)+黒スキニー+黒い靴、というのは定番がやはり初心者にはいいのではないでしょうか。

靴下の色が黒くないですが、こんな感じです。↓↓

清潔感があり、いい感じではないでしょうか。執筆時点(2月)でこの格好は流石に寒いのでこれをケアする形でいくつか紹介します。

※以後記載がない限り、画像はすべてユニクロ、GU、無印良品の公式サイトからの引用です。

パンツ

(ユニクロ)ウルトラストレッチスキニーフィットジーンズ ¥3,990-

言わずと知れたユニクロの黒スキニーです。2011くらいにスキニーパンツが定番化し、2015くらいにユニクロが安価なものを出し、というウルトラロングラン商品です。

このパンツのいいところはシルエットが美しくなるところです。上にジャストフィットのものを着用したらIライン、大きめのものを着たらYラインを作ることができます。つまり何をきても整います。

ゆったりがトレンドだからもうスキニーは古いなんていう人がいますが気にしなくて良いです。世の中の人は結構みんな使っています。

ただ、確かにゆったりシルエットも流行っている今、商品によってはシャツやパーカーとのバランスが取りにくい時があるのも事実です。(上がデカすぎ、下が細すぎになる)

まず黒スキニーを買い、その後色々試していくのが良いですね。

サイズ感

ここは少し難しいポイントです。ぴちぴちすぎると気持ちが悪いので、違和感を感じたら1サイズあげてもいいかもしれないです。色々基準はありますが、自分が気持ち悪いと思わないくらいが一番だろうと思っています。

管理人の場合は「脚を曲げたときにひざの形が生々しくでないところ」を一番としています。

図解していて一番分かりやすかったのはここでした。

【スキニーパンツ】サイズ選びのポイントをマスターしよう - Dcollection

裾上げ

すそ上げは必須で、べルトをつけた状態ですそ上げをしてもらうのが吉です。ベルトがない状態ですそ上げすると意外とあれ何か変だwwってなってしまいます。(体験談)

自分は立ったときに靴下が指1本くらいの隙間があるのが好きです。黒い靴下を履けば肌は隠せるし、色の違う靴下を履けば雰囲気をかえることができるので。

長すぎるとシワがより、短すぎると座ったときにスネが見えるという恐ろしいポイントですが、みんな多かれ少なかれそんな感じなのでえいやって決めましょう。(笑)

その他

このパンツが細すぎる!という場合は無印の黒デニムのスリムタイプのものを試着してみていはいかがでしょう。

シルエットが違うので単純には言えませんが、ピチピチのものを無理して着るよりはこちらのほうがいいかなと思います。

ジャケット

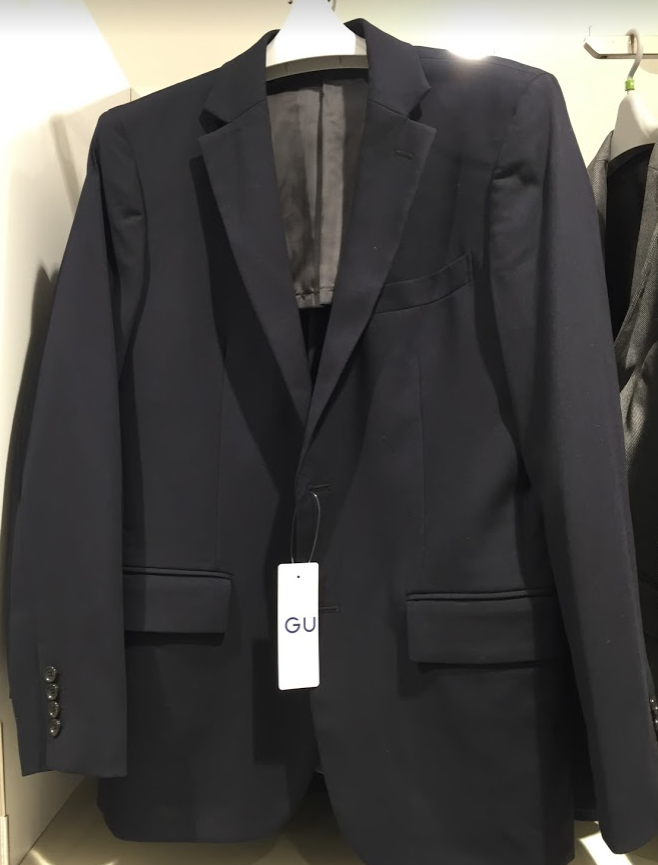

(GU)テーラードジャケットCL ¥4,990-

色々と出ていますがやはり一押しはこれ。2016くらいにシルエットが完成しているような気がします。

安いからこれでよくね?というより、むしろこれがベストじゃね?って感じです。

腰の絞りは美しく、生地は綺麗で、丈はニュートラルで、着心地も良いです。しかも安い。特段悪いところはありません。

色は紺が無難かなと思います。これからの時期はグレーもいいかもしれません。どちらも黒スキニーと相性がいいですね。

シンプルisベスト

最近はビックシルエットなジャケットや生地を工夫したジャケットがありますが、はっきりいって上級者向けです。

よほどスタイルが良くない限りはオススメしません。色々感じることがあると思うので、試着してみるのはオススメですが。

白シャツ

(無印良品)洗いざらしオックスボタンダウンシャツ ¥2,990-

管理人はやはり無印の白シャツが好きですね。

2015くらいのミニマル(要するにシンプル・イズ・ベスト)ブームのトレンド時に大流行りし定番化しました。

大きすぎず生地がやたらとテカテカしているわけでもなく、気をてらわないベーシックさがとても良いです。

今のトレンドからするとジャストサイズすぎる感じもあるのでワンサイズあげたものも試してもらう方が良いと思います。

ガチの初心者の人は普通の襟のものを、少し遊んでみたい人はスタンドカラーのものがオススメです。最近なんか店頭にないですけど。

というか無印良品さんはコロコロ名前を変えるので非常にわかりにくいですね。こちらは昔と同じものを買いたいんですよね。しかもその名前が何をいっているかわかりませんし。新疆綿とか言われてもわからないですしブランディングに失敗している感じが。

注意点

普通の襟のものは普通すぎて白シャツの色香がないというところでしょうか。むしろざっくりとした生地感を使っているので白シャツの割にカジュアルで粗野です。

このシャツを着る時はジャケットと合わせるか、時計や靴で少し飾るのが良いかなぁと。

普通のシャツに黒スキニーに地味な靴に時計なし、だと地味!ってなりそう。

シャツ一枚でも十分成り立っていると思います。むしろ王道です。

それでもこのコーディネートのコンセプトであるスーツ姿をコピペすることで相手に綺麗めな印象を与えようという作戦からは少しずれてしまいますので気をつけたいですね。

時計について少し書いた記事があるのでよければどうぞ。

インナー

インナーというと下着感でますが、Tシャツですね。2種類オススメさせてください。

(Hanes) Beefy 2枚セット ¥2,500-

Beefy??胡散臭!って思うかもしれませんが、新聞でも取り上げられたことのあるロングラン商品なのでご安心を。

アマゾンの例を見るとやたらといきった兄ちゃんの写真ばかりが出てくるので思わず引いてしまいますが、まったくもって心配ありません。(笑)本商品はカジュアルさよりキレイめが売りの服です。

いいところ

以前書いたレビューが新しく書くレビューを上まわれなかったので、そのまま書きます(笑)

白シャツをきるとき一番気になるのは肌がすけること、体のラインが見えてしまうことです。(乳首とか)

こうなったらもう肌着にしか見えず、外に着ていくなんてもってのほか。

この服は厚手であり、極力そういった恥ずかしさを消してくれる使いやすいシャツです。

加えて、厚手を謳う白シャツにありがちな生地が硬さとザラザラ感がなく、艶がありとてもキレイだ。腕を通したときに着心地のよさに驚くことは間違いない。

上で書いたように非常に着心地がよく、透けも少なく(管理人は一枚で着ても気にならない)、1枚で着るというシチュエーションに最適な設計だなーと思っています。

しかも安い!正直ユニクロでもこのレベルのものはなかなかないですね。クオリティの面でもコスパの面でも。

ユニクロのTシャツもいいのですが、スタンダードな商品の割に名前が変わったり、シルエットが変わったり、どれがいいか試着するのがめんどうなんですよね。

それならTシャツはネットで変える変化の少ないものを、が自分の中のセオリーです。

サイズ感

ビッグシルエットにはならないけどほどほどにリラックス感があり、今のトレンドにもあっていると思います。サイズ感のおかげか、テーパードパンツでもスキニーパンツでも合わせやすいというのも好印象。

乾燥機を使うと縮むので170cm、60kgの管理人はLサイズを着用しています。

Amazon商品ページより

アマゾンのレビューに身長体重と着用感がわりと載っているので、それを探せばいいのかな、と。

悪いところ

生地の薄いものを羽織るとTシャツの形が出てしまうところでしょうか。今回紹介したジャケットは問題ないのですが、夏用の半袖シャツとかを上に着るとTシャツの形がでて少しかっこわるいです。

(Hanes) Japan fit 2枚セット ¥1,500-

Amazon商品サイトより

Beefyの弱点を補ってくれるのがこいつです。一枚できると薄くて微妙かなぁと思うのですが、上に何かを着る前提ならこいつが一番です。

Beefyのように上に何かを着てもTシャツの形が浮き出るわけでもないですし、しかも安い。(700~800円)

あと、この商品、普通に人気モデルです。日本人モデルがあってきれいな形をしているんですよね。自分は乳首が透けるのが苦手なのでこれ一枚では着用しませんが、これだけで着ている人はたくさんいます。(レビュー数も凄い)

正直白いTシャツはこの2つだけ揃えていれば事足りますね。マストバイというやつです。

靴とベルト

靴は圧倒的にguがおススメです。無印も悪くないです。

衣料品メーカーにとって靴というのは鬼門でした。出しては失敗し、出しては失敗し。

これが2010くらいまでの雰囲気で、無印やユニクロが靴の開発に着手した時期には、今度こそ成功するか?と日経新聞とかにコラムが載るくらいです。

まぁ当たり前ですよね。abcマートを見たら分かるようにダサくて安い靴も、そこそこなデザインでそこそこの値段の靴も世の中なありふれています。後発メーカーが勝てるポイントはなかなかありません。

ユニクロがルメールと組んでデザインの強さでヒットを打つことはあっても(靴の面では)それが強い潮流になることはありませんでした。

しかし、それを覆す方法論が生まれます。素材です。ファーストリテイリングの購買力でいい合皮を安く手に入れて使っているのではないでしょうか。

(GU)ライトソールレザータッチスニーカー ¥1,990-

前置きが長くなりましたが、まずはこいつ。春~夏にはこれが活躍してくれると思います。写真だとわかりにくいですけど、生で見るとこれこんな値段なの?ってなります。

スニーカータイプだとこいつがすきですね。スニーカーのカジュアルさとレザーの綺麗さが同居しています。

黒スキニー+黒い靴下+黒い靴を合わせることで脚が長く見える効果を期待することが出来るのもポイントが高い。

もちろん完璧ではなく、耐久性、履きやすさはよく無い点としてあげられることが多いです。

ただ、靴なんてよくわからん!って人の一足目はGUでいいかなぁと。いきなりいい靴を買って失敗するのもあれですしね。

(GU)アクティブスマートダービーシューズ ¥2,990-

もう少しきれいなのを、ということであればこいつもおすすめ。GUの靴がよいよ!って話題になるきっかけのシリーズですね。昔はRageBlueが6000円で作っていたような代物です。それでも十分安かったんですけどね。

(ユニクロ)イタリアンオイルドレザーベルト ¥1,990

あえて選ぶならこれでしょうか?2年前の同名製品はこれはよい!と思ったのですが素材が変わり、普通になってしまいました。このレベルになると正直ベルトの良し悪しはわかりません。普通にしてれば見えないので無難な黒いやつがいいです。

確かguにもう少し安いのがあったのでそれでもいいんじゃないとすら思います。あとグローバルワークにも手頃なやつがあったのですが、趣旨から外れるので情報だけ。

別にユニクロでいいと思います。

コロナ後はチャンス?

特に出会いを求めている人にとってはコロナ明けはチャンスなのではないかと思っています。理由は単純に1年以上、恋活、婚活を出来ない期間があったからで、それだけプレイヤーが溜まっているということですね。

上記はマッチというアメリカのマッチングアプリを運営する会社の株価です。すでにコロナ前より株価が高いです。アフターコロナ後に活動が活発化することを予想した投資形がこぞって購入しており、期待値が高いことがよくわかります。

日本はまだワクチンがそれほど普及していないので少し先になると思いますが、だからこそ今から少しずつ練習してもよいと思います。

最後に

服とは装備です。RPGゲームのように簡単に買って簡単に自分のステータスをあげることができるはずです。

服を装備ではなく、ファッションとしてカテゴライズしてしまうとちょっと近寄りがたいと感じてしまう人も多いのではないでしょうか。

確かにおきれいな服を扱う店は入りにくいし、店員さんはとっつきにくい。

店員さんにもいい人はいるとは思うのですが、見た目はチャラくて信用できないし人によっては容赦なく見下してきます。何がそんなに偉いのか。

ただ、人間は情報の7割を視覚で得ます。

どう考えても服装や外見に注意を払ったほうがいいわけで、情報にあふれた今の時代、それは少しずつ簡単なものになってきています。

ちょっと調べたら自分にあったちょっといい服にたどり着くはずです。そして人から褒めてももらえるようになるかもしれませんし、何より自分が楽しい気分になれるかもしれません。

ファッションビギナーでも、「服を気軽に選んで、気軽に買う、そしてそれを気軽に楽しめる」ようになればいい。当ブログではそんなことを考えてファッションカテゴリを作っていければいいなと思います。

「はたらく魔王さま」まさかのアニメ2期決定!?

こんばんは、へるもです。

はたらく魔王さま2期と言えばエイプリルフールネタにもなっていたくらいですが、まさかの2期決定!

びっくりですね。

【速報】はたらく魔王さま2期決定!

— ْ (@RoRiRo_nn) April 1, 2019

【速報】はたらく魔王さま2期決定!

【速報】はたらく魔王さま2期決定!

【速報】はたらく魔王さま2期決定!

【速報】はたらく魔王さま2期決定!

【速報】はたらく魔王さま2期決定!

いや、マジで待ってた、ありがとう!

やっぱり令和最高だわwww pic.twitter.com/T74oyhhZBe

告知を見ている限り、キャストさんは続投の模様です。

TVアニメ『はたらく魔王さま!』

— TVアニメ「はたらく魔王さま!」公式㊗️第2期制作決定!! (@anime_maousama) March 6, 2021

第2期制作決定・特報PV

㊗️https://t.co/hXXwjiX6OQ㊗️

‼️-メインキャスト再び-‼️

魔王サタン/真奥貞夫(CV:逢坂良太)

勇者エミリア/遊佐恵美(CV:日笠陽子)

佐々木千穂(CV:東山奈央)

芦屋四郎(CV:小野友樹)

漆原半蔵(CV:下野紘)

鎌月鈴乃(CV:伊藤かな恵)#maousama pic.twitter.com/GhdqTtFs2D

公式サイトより

しかし、割と絵が違いますね。時間がたつとトレンドもかわるでしょうし、こんなもん?

動画で見ると意外と違和感はないし、動きも丁寧な感じなので別に悪くないかなと思っています。

心配なのは制作会社が変わっているっぽいところでしょうか。

一期を制作していた会社はwhitefoxという会社で、原作ありのものをアニメ化するのがすごくうまいんです。シュタゲとかも好評でしたね。

2期はyoutubeの告知を見る感じインフィニット。最近で言えばひぐらしリメイクとかshirobako2期とか。

調べてみると代表取締役の方がアニメ1期のプロデューサーのようなので安心といえば安心?

いつ放映するか分かりませんが、クレジットが2021になっているので秋とか冬なんでしょうか?

まだ制作決定!ってだけっぽいですが、続報に期待ですね。

魔法少女育成計画breakdown 感想的なものをつらつらと

こんばんは、へるもです。

ブログには登場したことがありませんが、密かに熱いと思っているラノベ。それが魔法少女育成計画です。

記事というよりは散文的にちょろちょろ書いていきます。breakdownについてはネタバレを含みますのでご注意を。

魔法少女育成計画

2015年くらいにアニメ化したので知っている人も多いかもしれません。あれは原作の1巻部分で、その後restart、limitedなどに続きます。

魔法少女というものに抵抗がなければぜひ続きも読んでほしいです。というか魔法少女というものに抵抗を感じて読まないなんてもったいない。アツイ!という場面が非常に多く、好きな人は絶対に好きですね。

自発的に読むのが面倒という方はAudibleでも。かくいう自分もアニメ(1巻)→その後Audible→短編集含めて電子書籍という流れで読みすすめていきました。

Audibleは結構当たり外れあるのですが、本作品の質はかなり高く買いっぱなしになりがちな自分もすんなりと聞くことができました。魔法少女育成計画のフワフワとしたガワ(外側)とガチバトルな中身のギャップを読みあげのスピードやトーンで表現してくれているのが楽しいです。コキュウートスゥ。なんならAudibleで聞くほうが質の高い楽しみ方ができるのでは?とも思ってしまいますね。

魔法少女育成計画はキャラクターが多いので最初は把握するのが辛いのが弱点でしょうか。でも書籍を読んでもそこは一緒な気もします。

新しい物語を読みすすめるのは面倒だけどアニメは知っているという人がいればアニメキャラクターが出てくる短編集をおすすめします。16人の日常だったかな?ユーモアがあり、きれっきれです。

若干下世話?な話題を下品にならない範囲で笑いにもっていく技術が非常に高いように感じます。

魔法少女育成計画breakdown

前置きが長くなってしまいましたが、本題の魔法少女育成計画breakdownです。時系列的には1巻→restart, limited→breakdownかな?ここからネタバレ含みます。

『魔法少女育成計画breakdown』はまだこちらのページ(https://t.co/RlEJDOcgeF)で読めますが、書籍化にあたってどのシーンに挿絵が入って欲しいか、皆様のご意見を聞かせていただければと思います!

— 月刊魔法少女育成計画 (@monthlyMGRP) December 19, 2020

ぱっと振り返って

ドリーミィチェルシーやばいな。。。

アラサーどころかアラフォーとも言ってしまえそうな子供部屋おばさん(家事手伝い)がまさかこんなに強いとは。しかもピースやらWピースやらハートやらで戦うとか。

彼女の戦闘シーンでは何を言っているのかわからなくて何度か読み返してしまうことが何度かありました。彼女はいたって普通の振る舞いをしているのでしょうけど、かわいい!とかいいながらハートやらピースやらで戦うところは狂気じみていました。(笑

ときどき狂った人間の内面描写をする小説ってあるじゃないですか。今回で言えば恋々とか。チェルシーの戦闘シーンはあれを読んでいる感じです。

まぁ恋々は恋々でやばいやつでしたが、チェルシーのほうが奇怪だったかな、、、

年を経た”つはもの”なら、これまで出てきたような職業魔法少女感に収束していくだろうと無意識のうちに予測していたのだろうと思います。全くそんなことはなかった。

徹頭徹尾チェルシーはチェルシーで、 既成概念をぶっ壊していく彼女を描写する文章は私の脳みそのなかで荒ぶり猛り、なかなか理解という籠の中に入ってくれませんでした。

あとがきを読むと編集者の高い要望に作者が答えた結果だということ。やっぱり世の中には叩けば叩くほどいい味を出す人っていますよね。編集者の方にはもっともっと叩いていってほしいところです。

余談ですが、バスローブを来た姿から情婦と連想されるシーンが入っているのは彼女のブランドを保つ上でよい役割を果たしてくれたと思います。「パワー系妄想アラサー魔法少女(無職)」だけでは流石に救いが無さすぎます。女だらけの世界でほとんど意味のないことではありますが、色気はあるんだ。色気は。

クラリッサ

過去作でメインをはったことがない人物の中ではクラリッサが一番印象に残っています。めっちゃ若いけど実力者、みたいなキャラクターが結構好きです。

小学生の女の子があちらだよと背後を指で指している、みたいなところはぜひ挿絵に応募したかったですね。気がついたら締め切りを過ぎていて応募すらできませんでした。

気がつけば今年もあとわずか。

— 月刊魔法少女育成計画 (@monthlyMGRP) December 19, 2020

2019年とは別の意味で手強かった2020年ももうすぐ終わってしまいます……。

ということで、ちょっとした企画をしてみたいと思います!

題して「『魔法少女育成計画breakdown』書籍化記念! breakdownのこのシーンに挿絵が欲しいよアンケート」!

魔法少女育成計画のいいところって魔法少女になると其の人の本質が出てくるというところだと思うんです。

一般社会では幼い実力者というのはなかなか存在しません。社会通念、身の未熟さ、それらが故に経験を得られない立場だからです。しかし本作の魔法少女は、元の姿が何であろうと魔法少女という一律の姿を与えられることで全員が同じスタートラインからよーいどんです。

これまでの人生や魔法の優劣などによる差は当然ありますが、可能性は無限にありそれを掴み取れるかどうかは本人の鍛錬という要素が非常に大きくなってくるわけです。

ひるがえってクラリッサは若年ながら戦闘能力、判断能力、交渉能力などに長けており、魔法少女育成計画らしいキャラクターだったなと。

マーガリートさん達

マーガリートさんは生き残れなかったかぁ。最終決戦でトウタの描写が始まってからこれは勝ちフラグや!あとは全員生き残りや!と思ったのですが、なかなかうまく行かないものです。

下剋上羽菜さんは好きだったので師匠には生き残ってほしかったな。マイヤやJOKERSのフィルルゥ/スタイラー美々みたいなクズ要素の少ない実力者って容赦なく死にますよね。悲しい。

そんな実力者の願いも虚しくトウタとイオールは人造魔法少女に興味を持ってしまいました。これは死亡確定かなと思いつつ、一回生き残るとそこそこ死なないというのも魔法少女育成計画なのでどう絡んでくるか楽しみです。

フランチェスカ

いやー強かったですね。現身つよい。強すぎて戦闘シーンが逆に眠くなったりしました。だって勝てねーし。

デスゲームにしても陰謀にしても多数vs.多数の殺戮だったこれまでと違って強敵をみんなで倒せ、って感じが逆に新鮮でした。その果てに7753は木になったり、メリーはフランチェスカになったりえらいダイナミックな作品です。

シェリーズパイ

作中では無能のような扱いですらあった彼でしたが、読者的には真夏の夜の涼やかな風のようでした。どいつもこいつも物騒な願いにいろいろな人を巻き込みますが、シェリーズパイ君は極めて牧歌的な存在です。

彼にしろ、ペチカにしろ、美味しい料理というのは魔法少女を引きつけるフックを持っているのに中々心の平和は訪れません。魔法少女は食べる必要がないからですかね。

ラギとクランテイル

ラギ師の最後のシーンは心にくるものがありますね。クランテイルの糾弾は老人の心の柔らかい部分を確実にえぐりました。敬老の精神を持ち合わせているとは言えない自分ですが、辛いシーンです。

遵法だけでは世界が正しく回るという主張はある意味、幸せな世界にいたということです。綺麗事を綺麗に守っていれば(左遷などの憂き目にあったとはいえ)命を揺さぶられることのないマジョリティの枠内にいたということですから。

クランテイルは違いました。彼女は法が守る穏やかな世界に突如としてた生まれた無法地帯の穴に落とされてしまいました。友人を失い、命をかけた戦いに身を投じざるを得ない状況に陥った彼女の主張は、今回の事件を経たラギ師に現実を叩きつけます。その現実は”そこにあるというだけで傷をつけ血をながさせている”ことでしょう。

ラギ師が最後にとった「魔法少女の能力を油断している魔法使いに行使する」というものが法律の枠内にあるのかどうかはわかりません。しかし、少なくとも遵法精神を支えていた信念に反したものだったはずです。

ラギ師は自らの信念の枠の外に踏み出しました。この一歩はかつてのスノーホワイトの決断の相似形に見えます。

無法者が跋扈しようとも、良識派の良識によって形作られたのが現在の秩序ある世界でした。その良識派が次々とグレーゾーン、ブラックゾーンに踏み出していきます。果たしてこの世界はどうなってしまうのでしょうか。次巻は魔法少女育成計画(白)がでるのかなと思っていましたが、こうやって紡いだ文章を読み返すと白くはなさそうです。なんて。

【投資】リップルが暴落。ビットコイン、イーサリアムを含めて現状と今後について考えをまとめてみた

こんばんは。

日本ではあまりニュースになっていませんでしたが、 仮想通貨界隈で大きな動きがありました。

仮想通貨に関しては昔からなんとなく情報を集めていましたが、詳しくありません。今起こっていることを整理したいなと思います。

読むと分かるのですが、基本的には他人のふんどしで、、、という感じです。ある程度の信憑性はあるのではないかと思うのですが、一方でそれを判断できる知識も能力もありません。

参考程度にとどめていただければと思います。

結論

これまではBTC, ETH, XRPの3つに投資していましたが、BTC, ETHのみで行こうかな、と思います。この3つに投資していたのは単純に時価総額が大きかったからです。

Litecoin is now the 3rd biggest cryptocurrency by market cap! 🎊 pic.twitter.com/De9Jztx581

— litecoin (@litecoin) December 29, 2020

ちなみに現在の時価総額ランキングはこちら。もともとトップ企業に投資したいという気持ちが大きいので悪くない選択です。

ちなみにツイッター界隈での有名人じっちゃまさんの意見はこちら。

だからといって投資すべきという話ではないですが、ちょっと安心。

ようするにBTCやETHのドミナンスがグッと高まるという話をしている。そうしなければロビンフッドやコインベースは株式公開させてもらえへん。

— じっちゃま (@hirosetakao) December 24, 2020

何が起こったの?

SEC(米証券取引委員会)がXRP(リップル)を取り扱っているリップル社のCEOを訴えました。

SECは証券業界の不正を取り締まるための組織で、過去にはエンロンの粉飾決算を暴いた組織でもあります。友人と話しているとふーんって感じの反応が返ってきたのですが、SECに睨まれるというのは非常にヤバイもののようで、リップルは大暴落です。

ヤバイもの「のようで」、と書いているのは全然知らなかった無知な自分への戒めとして正直に書きました。。。

リップルのニュースは比較的早めにキャッチしたと思うのですが、そのときは少し下げた程度でそんなに大ニュースだと思っておらず、考えるのが面倒だから後にしようと放置してしまったんですよね。そうしたところ、次の朝にはこんなことに。。。

こういう感じで悪いニュースが出たらASAPで逃げるというのは必要なことだと分かっていたことなのですが、全然駄目でしたね。

ちょっとあがったところは暴落後に反発するデッドキャットバウンスというものでしょうか。自分はそれが起こる前の大底で売りました。(笑)今はもっと下がっているので早めに売るという決断をできたところだけは褒めたいと思います。

なんで訴えられたのか?

今回の訴訟では、リップル社が独占的に発行を行なっている暗号資産XRPの証券性に関するものだ。暗号資産はデジタル資産としての性質上、証券に該当するか否かという論争が常に付いて回る。

XRPの証券性がなぜ問題になるかというと、リップル社は2013年から7年にわたり、XRPを独占的に販売することで1300億円以上の売上を出していたことに起因する。仮にXRPが証券であると判断された場合、リップル社は届け出の済んでいない証券を不当に販売したことになるのだ。https://internet.watch.impress.co.jp/docs/column/blockchaincourse/1298009.html

リップルが株式のような証券なのか、通貨なのか、という点が争点になっているようです。

なぜ、証券であることが重大な意味を持つのか?これはSECの設立経緯を踏まえると凄くわかりやすかったのですが、要は証券だったら、おそろしいおそろしいSECに取り締まれるから、です。

それは1929年の「暗黒の木曜日」。このとき多くの投資家が損した。でも、もっと悪いことには「IPO」と称してインチキ証券を売出し、投資家からカネを巻き上げ、姿をくらませたプロモーターが沢山居たと言う事。これは、仮想通貨の「ICO」と酷似している。 pic.twitter.com/CAGw50qiJV

— じっちゃま (@hirosetakao) 2020年12月24日

米国政府は「1933年証券法」「1034年証券取引所法」「1939年投信法」という3つの法律を定め、あるひとが他人からお金を集めるときのルールを決めた。

— じっちゃま (@hirosetakao) 2020年12月24日

そこで大事な概念は「登録(レジストレーション)」ということ!

— じっちゃま (@hirosetakao) 2020年12月24日

およそお金をひとさまから集めようとする者は、自分の素性を明らかにし、住所を開示し、なにか事件があったとき、ちゃんとどこへ苦情をねじ込めばいいか実態のある営業所を明記しないといけない。

ICOの場合、どうだい?🤣

つまりSECという機関は、摘発!という事に関しては筋金入りのキレッキレの政府組織ということ。SECに睨まれたら、まず「負けた!」と思っていい。

— じっちゃま (@hirosetakao) 2020年12月24日

さて、現代に話を移すと3年前はICO詐欺が横行した。仮想「通貨」という触れ込みで「これは証券じゃない……だからSECの管轄じゃない!」というロジックで、騙して投資家からお金を巻き上げるプロモーターが暗躍したわけだ。

— じっちゃま (@hirosetakao) 2020年12月24日

「証券か?それとも通貨か?」

— じっちゃま (@hirosetakao) 2020年12月24日

この論争が決定的な重要性を帯びるのは、「SECが取り締まれる? それとも管轄外?」をきめる重要な線引きだから。

これまでは証券(株式とか)じゃないよー通貨だよーお金だよーっていってSECの管轄外のふりをしていたのですが、いや、SEC「お前は証券だからね?(ぴきぴき)」ってなっちゃったんですね。

証券かそうでないかによって、リップルの本質的なありよう(オープンソースで作られた技術)が大きく変わるとかではなく、SECに睨まれたということそれ自体が大きな大きな問題なのです。

ところでコインベースは先日、IPO書類をSECに提出した。SECは……それを「シカト」できます。

— じっちゃま (@hirosetakao) 2020年12月24日

コインベース:「これS-1です。よろしくおねがいします」(ぺこり)

SEC:(ぷいっ!と横を向く)

コインベース:(ひょっとして……うちがXRP扱っていることをSECは快く思ってないのかな?……社に帰ったら、さっそくXRPの取扱い終了しよう、、、)

— じっちゃま (@hirosetakao) 2020年12月24日

結局リップルの本質的な部分まで変容しそうではありますが。

リップルの証券性について

XRPの有価証券性がよくわからなかったので調べてるんだけど、「XRPの価値とRipple社の業績が連動しているのか」というところが肝っぽい。

— しまぉ(freedom man) (@kazn1988) 2020年12月29日

たしかに銀行とかは通貨の価値が上がってもそこまで業績に影響無さそうだけど、一般の会社の場合、集まった資金を使って新しいサービス開発するわけだから↓

自然と業績も上がる。

— しまぉ(freedom man) (@kazn1988) 2020年12月29日

これにより注目度が上がり、さらに通貨の価値が上がり資金が集まる。

たしかにこの流れだと株式と同じだよね。

なんかトークンとかも配ってるし、それはもう配当な訳だし。

ビットコインとかはそんなにサービス拡大してる印象ないし、なんかもう金みたいなイメージある。

解釈として正しいかはわかりませんが、ここらへんが自分の理解とも近いし、わかりやすいなと思いました。

リップルのインセンティブに対する各社声明。 pic.twitter.com/meH76HW7Tm

— 紫藤かもめ (@shidokamo) December 23, 2020

あと、特定の取引所にインセンティブを与えていたという部分もあれですよね。

リップルの今後について

なので証券認定された場合、和解額にもよりますが正直リップル社は持ち堪えることは困難な状況になるかもしれません。加えて経営者2人も訴追されてる状況です。

— さばCat🇫🇷ツーブロック弁護士連合 (@utah_) December 23, 2020

はっきり言います。

SECは殺しに来てるわけです。なのでR社は全力で証券認定を回避するか有利な和解を狙わないといかない状況です。

なんとかSECと和解して穏便に終わってくれーって思ってる能天気な人いたらね、その後に続くエンドレスなホルダーからの集団訴訟を想像してみるといいよ。逆を言うと全てのリップラーはその権利があるって事だけどね。

— さばCat🇫🇷ツーブロック弁護士連合 (@utah_) December 22, 2020

何度も言うけどXRPなんてもんはRippleがコケたらそこで試合終了なんだよ。

答えを持っている人はいないんでしょうけど、自分は悲観的だったので逃げました。ただし、ポジションを全降りしていない人も割といるようです。

ビットコインとイーサリアムの証券性は?

金融資産の証券性を取り締まっているSECとしては、ビットコインとイーサリアムのみを現時点では証券ではない暗号資産として正式に認定している。

https://internet.watch.impress.co.jp/docs/column/blockchaincourse/1298009.html

ビットコイン(イーサリアムも?)は金と同じくコモディティ扱いで、証券性という観点でのリスクは他の仮想通貨よりは低そうです。

解説してくれているツイートがこちら。

ビットコインは、配布の方法からも証券ではないとされ、CMEでもコモディティとして、先物取引が2017年に始まりました。

— 紫藤かもめ (@shidokamo) 2020年12月17日

コモディティということは、「商品」、金や鉱物や農作物みたいなものの仲間として先物が取り扱われるということですね。

こちらはイーサリアムについて。

CMEの先物のニュースで、ETHの証券性についての話を誰かがまとめてくれるだろうと思ったけど、流石にガチ勢には常識すぎて誰も今更語ってないようなので雑に自分の理解をぶら下げておきます。

— 紫藤かもめ (@shidokamo) 2020年12月17日

ETHは、最初期にICOでビットコインを集めて資金調達をしたわけですが、この件がしこりになっていました。簡単に言うと、これが未認可の「証券」(securities)を販売したこと当たるのではという議論がありました。https://t.co/RTu1ERL66W

— 紫藤かもめ (@shidokamo) 2020年12月17日

何が証券で何が証券でないのかは、基準となるHowey Testなど色々あって門外漢の自分には難しいんですが、雑に言うと、「こんなすごいことをやるから投資してください!」と言って投資資金を勝手に集めるのはいかんという規制だと自分は認識しています(ツッコミ待ち)https://t.co/YVx3DfPKz8

— 紫藤かもめ (@shidokamo) 2020年12月17日

CMEはビットコインの先物に並並ならぬ熱意を注いでいるので、ETHも速やかに取り扱いたかったでしょうが、なかなか話が進まず、先の証券性がクリアでないのがネックになっているのではないかという話でした。

— 紫藤かもめ (@shidokamo) 2020年12月17日

そこへ今回、CMEが遂にETHの商品先物を取り扱うという事が発表されました!

CMEは世界有数の先物取引所であり当局とも緊密に連携しておりますから、今回の件で遂に数年来のETHの証券性の問題はクリアになり(簡単に言うと禊が終わった)、コモディティとして広く扱われるようになったという自分としては大きなニュースでした。

— 紫藤かもめ (@shidokamo) 2020年12月17日

イーサが2月CME先物くるのも株クラとか分かって無いデスよね。

— TAKO@プライドスカイツリー🎄 (@iku4512) December 27, 2020

イーサリアンもう少しこの辺煽ってくれデス。コモディティとしてアメリカで認めて貰ったデスから。頼みますよ。全部僕はポジトークデスよ!じっちゃまも根拠なくなんかイーサは大丈夫とか言ってたし

CMEというのはシカゴにある取引所のことです。アメリカの歴史もあり、規模も世界一のところがこれらをコモディティとして認めているということなのでしょう。

仮想通貨が「謎の新興技術・通貨」から「世界で取り扱いをされる商品」になるにはある種の定義、秩序が必要であることは理解できるところです。このような巨大な存在の後ろ盾?追証?を得ているということは非常に大きな意味を持っていると思います。

これが冒頭に述べた通貨に引き続き投資しようと考えた理由でもあります。ただし、ほんのちょっとですが。

ビットコインとイーサリアムの違い

ビットコインとイーサリアムはどっちも同じく安全!かと言えば、それはもちろん違うと思います。今は似たような値動きをしているのですが、 これは取引している人がどちらも一緒くたにして仮想通貨枠で扱っているからに過ぎません。両者は本質的に別物です。

ただ、別物と言い切っている割にはうまく説明できませんでした。イーサリアムは電力取引などに応用されようとしている一方、ビットコインは単純な通貨としての役割を期待されている、あたりが考えの取っ掛かりではあるのですが、じゃあ何が違うの?と言われると上限の有無が違いますよ、、、みたいな曖昧な回答しかできません。

誰か教えて下さい。

ビットコインとイーサリアムの違いとは?初心者でもわかる主要仮想通貨の比較 | 仮想通貨コラム | 仮想通貨の比較・ランキングならHEDGE GUIDE

既存金融はBTCをデジタルゴールドにして単なる1アセットの投資対象にしとけば、クリプト民が金持ちになろうが全然いいわけ。問題は今後、ETHみたいな発展系が既存金融のある分野とガチンコするような時にはあらゆる手段でコントロールしようとしてくる。ETHに限った事じゃ無いけど。— さばCat🇫🇷ツーブロック弁護士連合 (@utah_) December 24, 2020

ただ、機能や期待、展望の違いから、ビットコインとイーサリアムの相関は今後ずれる可能性は大いにあると思います。そこらには注意が必要ですね。

引き続き情報収集しないとなと思います。

他のアルトコインの今後は?

イーサリアムはその昔証券扱いだったという経緯もあり、リップルもSECとの和解を経て証券扱いから正式に外れたら(あるいは証券化したら)爆上げしそうですね。ただし、そんなやばいアルトコインは使わないという流れも当然ありうるので、やはりリップルに投資するリスクは非常に高いように見えます。

調べる前は「いや、証券じゃなくね?」と思ってたけど、

— しまぉ(freedom man) (@kazn1988) 2020年12月29日

この基準に当てはめていくと、XRPの有用性が逆に証券に該当しやすくしているという感じする。

裁判数年かかるみたいだし、XRPはリスク高いと感じる。

XEMも同じようにトークンみたいなの配ってなかったっけ?

あれも有価証券性あるのかな?

それでは他のアルトコインはどうでしょうか。

仮想通貨の証券性のランクというものがあります。取引所がつけている感じなのでどこまで信用できるか?とは思いますが。

へー、知らなかった!

— Guko (@crypt_guko) April 18, 2020

仮想通貨の「証券性」のランク付けが真面目にされてる。

スコア1が安全圏、5に近いほど証券性が高い。

BTCは1

ETH、BAT、IOTAは2

ATOM、Stellar、EOSは3.75

XRPは4

ランク付けしたのはCoinbase、Bitrrex等の大手で構成されるCrypt Rating Council。https://t.co/Xwur8OG7UM

これを見るとケースバイケースではありますが、リスクが高いのはリップルだけではなさそうです。

ただでさえ仮想通貨界隈はボラティリティの大きい投資対象なので、不安要素があるものはできる限り避けたほうが無難かなと思います。

このように考える人が多ければBTCにもっと資産が流れそうでもあり、アルトコイン淘汰の時代の始まりなのかもしれないと感じます。

BTCに投資したいけど、怖いという人は?

https://t.co/8WKRnBLNZw

— じっちゃま (@hirosetakao) December 25, 2020

俺、誰よりも前からスクエアがビットコイン扱うことが重要な意味をもつこと指摘してきたぞ。3年前の記事や、これ。

色々調べてもやはりBTCに対するうさんくささが消えません。やはり日常生活で見聞きしないものを信じるのは難しいです。

一方で、SECが乗り出してくるくらい大きな存在感をもっているのが仮想通貨であり、一過性のトレンドで終るともなんとなく思えません。仮想通貨には投資しておきたいと思う人は多いと思います。

そういう方は会社のサービスとして暗号資産を扱うSQやPYPLの調べるのがいいのかなと思います。あとはマイニング関連の株でしょうか。

イーサリアム関連銘柄ってなんなんでしょうね?電力株とかブロックチェーン関連とか?

さて、引用ばかりの記事ですが、長くなってきて疲れたので終わりたいと思います。

調べるだけならぱーっと読めばいいのですが、記事にすると意外と大変です。継続的に発信している人はすごいですね。

念の為いっておくと、投資は自己責任で!

漫画「幼女戦記」20巻 表紙に込められた意図とは? 【ネタバレ注意】

こんばんは、へるもです。

今回は漫画の内容ではなく、表紙についてざっくばらんに語りたいと思います。

まぁいつも漫画の感想を述べるときは表紙ばっかり語っている感じもありますが、、、

表紙に込められた意図

こじつけると1巻と20巻を比較するとまた面白いです。

— 社会人はリラックスしたい (@kapVpjzVyO8N5Fl) 2020年12月26日

一人で正面を直視しているターニャ→構図はほぼ同じだけど周りに仲間がいるターニャ。

そして仲間たちで正面(現実)を直視しているのはゼートゥーアさんだけで他はみんな別の所向いていますね。ちょっと象徴的じゃないでしょうか?#幼女戦記 pic.twitter.com/A0fJ9RBfbx

幼女戦記20巻の感想を書いているときに骨休めに気づいたことを書いたのがこれです。20巻の感想でも書いたとおり、ターニャに仲間ができている感じがすきだったのでふと昔のものと比べたくなってツイートしたことでした。

こういうのってだいたい”そんな意図はない”とか言われるので「こじつけですが」なんて予防線を貼りつつのツイートでした。もちろん直接言われたことなんてないんですけど、絶望先生の久米田さんとかいいそうじゃないですか?(笑)

ツイートしてからしばらくはいつもどおり何の反応もなかったのですが、ある時見てみたらやたらと通知がありびっくり。

なんだ?なんかやらかしたのか?と思ったら、、、

まさかの

まさか気づく人がいるとは思わなかった。 https://t.co/COr3G6CPWa

— 東條チカ (@yooochika) December 26, 2020

漫画を書いている東條さんからのコメントをいただきました。まじで?

上の考察がまぐれ当たり。

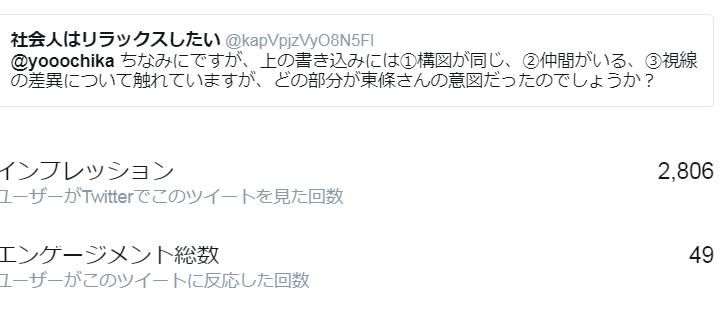

いいねが100くらいついたところで気づいたんですが、この時点でこのツイートが見られた数が1万くらいあって驚きました。自分のつぶやきがそんなに見られたことなんてありません。インフルエンサーすげぇ。

ちなみにですが、上の書き込みには①構図が同じ、②仲間がいる、③視線の差異について触れていますが、どの部分が東條さんの意図だったのでしょうか?

— 社会人はリラックスしたい (@kapVpjzVyO8N5Fl) 2020年12月26日

全てです。実は10巻限定版(通常版とは絵柄が違う)も似たコンセプトのもとに描かれております。一例をあげると、このころから表紙のヴィーシャは目が隠れているか、目を閉じていることが多く、盲目的です。

— 東條チカ (@yooochika) December 26, 2020

そんなに意図的なんですね。驚きました。

— 社会人はリラックスしたい (@kapVpjzVyO8N5Fl) 2020年12月26日

ヴィーシャが目を瞑っていることは印象に残っていましたが、顔が可愛かったので考察してませんでした。(たしか18巻も)

おっさんだらけな今回だからラッキーパンチを打てたんだな、と。

世界は秘密であふれていますね。

ありがとうございました。

表紙についての考察の何があたっていたのか気になって質問してみると、だいたいあたっていたということ。

というかそれだけだと足りず、ヴィーシャが目をつむっている部分にも意味があったようです。

たしかに目をつむっているというのは結構感じていたことではありました。ただ、17巻では目があいていたんですよね。なので一貫した意図があることには気づかず、東條さんの性癖なのかなぁと思っていました。

幼女戦記15-19巻より

もう少しふみこんでいればと思う反面、盲目的に従っているという意味には気づけなかっただろうなと思います。自分の中では漫画版ではターニャとヴィーシャが百合営業をしているなという思い込みが強く、そこで思考がストップしていました。

それでなくてもヴィーシャの顔がかわいいなぁということで何も考えていませんでした。

それでいうと私はターニャもヴィーシャも可愛くて何も考察できてませんでした🤣

— 水羊羹 (@watersheep0303) December 26, 2020

…ニンゲン、目を開けててもどこまでみえてるのか?と言うのはこの作品のテーマなんだなぁ、と漫画版ならではのポイントのご指摘に感謝。

顔の向き

幼女戦記19巻より

なんとなくターニャたちの服は緑色のイメージが合ったのですが、紺のほうもかっこいい。顔の向きはなぜこうなっているのだろう。素案が左向きで、表紙だからとこっちを向いたのだろうか。

左を向いていると未来を感じさせる絵になりますね。顔の向きでこうも印象が変わるとは。文字デザインの影響も大きいけど、左向いているほうが映画のパンフレットぽいですね。

一方で、顔の向きに何らかの意味があるのでは?という点については気づけ(?)ました。

これは19巻のカラーページのおかげです。19巻では上記の表紙の他に巻頭カラーページがついてたのですが、そこでは何故かターニャの顔の向きが書き直されていたんですよね。

上の文章は19巻の感想なのですが、このときはどちらかというと戦争の行く末とかそんなことをイメージしながら考察していました。

(まぁ19巻の感想は編集途中で大部分が消えてしまったので萎えてしまい今は引っ込めてしまっています。そんな感想でこんな考察をしてたんだ!っていっても信憑線はありませんね(笑))

その他の意図とは?

ちなみに10巻(限定版)の表紙というのははこちら。

ヴィーシャがいるのかな?と思ったのですが、確認できませんでした。ここではまだ一人ですね。裏にでもいるのかしら。誰か持ってませんか?

この絵を見て気になるのは帽子でしょうか。1巻と20巻の比較でも帽子は気になるところではありました。帽子をかぶっているのは大佐と1巻のターニャだけですよね。ただ、意味は見いだせていません。

レルゲンさんの顔は別方向に向いてても目線が正面に向きつつあるのが「戦争狂の戯言など信じたくは無いがそれが本当の現実」とでも言いたげな...

— モカ (@moka_cone) December 26, 2020

20巻、とても面白かったです。

そのほかにもこんなコメントも。たしかになぁ。

東條さんもいいねをしており、そういう意味は確かに込められていたと見て間違いないでしょう。

ついったーって凄い

表紙についての感想からは外れますが、現代技術って凄いなって思いました。なんてことない人間の呟きに作者が反応してくれるというのは過去の世界ではなかなかなかったことです。

ジャンプ作品だと単行本のおまけページにQandAが投稿されて、それに作者がコメントするとかありますが、あれらは相応の努力をした選ばれし者たちですからね。

ちょっと面白いこと気づいたな、投稿したろ、くらいのノリのものでも運が良ければ反応をもらえるというのはコミュニケーションコストが激下がりしているからです。すなわち、住所を調べる必要もなく、なんて書くか悩む必要もなく、字が汚いからパソコンで打ち出すか迷う必要がなく、はがきを出す必要もない。

これはSNSのいいところで、こういった交流を通じてもっと宣伝にしていってほしいなと思います。何しろタダなのに数万人に見てもらえるわけですから。

読者サイドも発信していけばいいのではないかなと思います。語弊を恐れずいうのであればなんとなく出版サイドはこのサイトですら見てくれている気がします。電子書籍にも袖も入れてほしい、帯の絵を入れてほしい、一枚絵がほしいといったら追加してくれたものもあります。

もちろん分別は必要ですが。

まぁでもポニテロッテさんの水着姿は登場させてほしかったですね。 もう水着姿が出てくることなんて無いですし、、、

海外への反響

@tafa_brujita Este es uno de los dos mangas que te recomendé ayer. https://t.co/1H0VR4hu5l— SrTsuki (@SrTsuki1) December 26, 2020

外国で人気があるということですが、本当なんですね。

「この前おすすめした2つのうち1つだよ」ですって。このサイトの感想も英語で書いてみようかなと思うときもあります。なんか世界的な輪が作れたらいいんですが、たぶんネタバレになっちゃいますよね。

面白いコメント

これあえて言う必要はないけど、まさに「芸術」なんだよね

— じむりじんじむちゃん (@jimurijinjim) December 26, 2020

物語をバックボーンとした表現で、それを感じとる人たちがいるわけですよ https://t.co/8F2mymU15F

これはおもしろいなと思いました。

芸術っていうのはクリエイティビティの爆発、つまりよくわからない新しいものっていうイメージがあったのですが、今は芸術というのは技術と同じ文脈があるなと思っています。

造詣がないのでたいしたことを言えませんが、これまではこうだった→ここが欠点だからこうしてみよう、で進化してきたところがあるなというか。例えば葛飾北斎が西洋で受けたのは、自然の背景が簡素に書き込まれている、人が簡単な線だけで描かれているというところでした。(西洋では精緻なものが主流)

つまり、Aにないものを表現したBがというものがあり、その差異に芸術性が宿るというのが自分の解釈です。

しかし、この方は作品の書き手と受け手の双方向的なやり取りと合意に芸術性を見出しているわけです。面白い。

東條さんのコメントまで読んでいないのでは?と思ってもったいないなと思って作った感想記事でした。

暇つぶしにでもなったら僥倖です。

漫画「幼女戦記」20巻 感想 俺たちの戦いはこれからだ! 祝第一部完結【ネタばれあり】

こんばんは、へるもです。

いやー漫画版幼女戦記が一区切り付きましたね!第一部完ってとこでしょうか。

幼女戦記シリーズは最初から追っていたわけでもなく、そういう意味では特にこだわりのない作品ですが、それと同時に色々と思い入れのある作品でもあるので綺麗に終ることができてよかったなぁーと思います。

まぁ最近はコミカライズ版がアニメの宣伝のためにちょっと書かれていつの間にか終る、ということもないのでそんなに心配していませんでしたが。

とらドラとかコミカライズのほうが好きなんだけどな。

さて、本題に戻って幼女戦記の話です。ネタバレ注意!

※本記事の画像は特に注釈がない限り幼女戦記 20巻(東條チカ画)より引用しております。

まさかのおっさん達。春のパン祭りならぬ冬のおっさん祭り 。

ヴィーシャ隠れてるじゃん。これは、、、めっちゃいい!

おじさんの成長物語

ターニャめっちゃ成長したなって思います。あるいは仲間ができたなぁ、みたいな。

こういうシーンってすごく良くないですか?

ドラクエにしろなんにしろ、物語というのは仲間集めの側面があるんですよね。一人で始まり一人で続け一人で終る作品なんてありえない。

そういう意味で「幼女戦記」なんて突飛な名前がついているこの作品も王道をゆく作品で、主人公!しているおじさんを見るのが好きです。

ストーリーの構造的にも美しい

それほど全面に押されていませんが、個人的にはおじさんの一匹狼感ってすごく重要なファクターなんですよね。

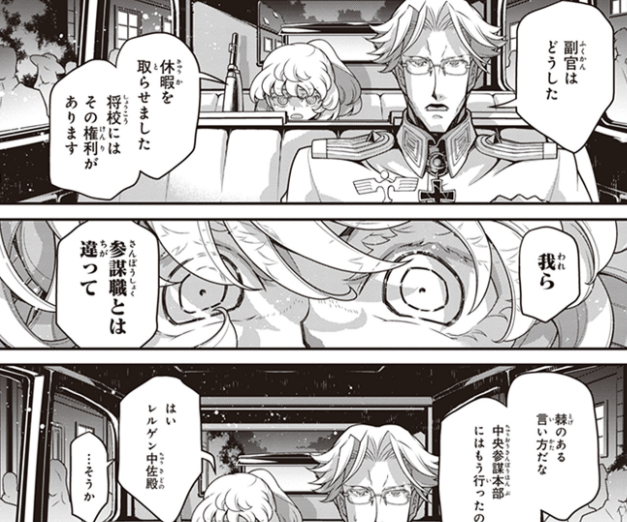

なぜなら、幼女戦記は「出世しそうなリストラおじさんが部下の復讐で死ぬ」という出来事から始まっているからです。

すなわち、ストーリー開始時のおじさんの属性=①"高能力(+ミリオタ)"+②"人心掌握力0"+③”友達いない”。

数で言えば半分以上のおじさんテーマが「他者との関わり方」(=②と③)にあり、話が進むごとにその弱点が弱点でなくなってくれる(=成長)ストーリー展開というのはよいなぁと思うわけです。

いやいやさすがにこじつけがすぎるだろうと思う人もいらっしゃるかもしれませんが、作中で唯一おじさんを危険視する(最近はそうでもない)レルゲン中佐とのすれ違いは学生時代に後輩を粛清?しようとしたところに由来しており、やはり物語のテーマとして見過ごせません。

高スペックは生き残りの必要条件で、十分条件にあらず

①高能力+ミリオタ知識というおじさんのハイスペックさに加えて、「どうしてこうなった!」という作品色がこの作品の根幹をなす魅力です。異世界の心得知らずどもにぶちかましていく爽快感はたしかにありました。特に序盤。

しかし兵器も戦争形態も進化しているんです。進化しないものは淘汰されてしかるべきです。いわんやおじさんをや。

おじさんの95式は人外のものであり、なおも優位性を誇るものではあります。しかし、おじさん自身が変わらずして、どう生き残るんだ。

おじさんをアップデートせよ!

そこで出てくるのがおじさんの弱点である"人心掌握力0"、”友達いない”っていうところ。強みを磨ききっているならば、弱みを新たに磨くしかありません。

ここまでは机上の空論。さて実際は?

その答えが20巻の表紙です。

すなわち、仲間がいる!ぼっちだった一巻と比べるとだいぶと印象が変わりますね。

こじつけると1巻と20巻を比較するとまた面白いです。

— 社会人はリラックスしたい (@kapVpjzVyO8N5Fl) 2020年12月26日

一人で正面を直視しているターニャ→構図はほぼ同じだけど周りに仲間がいるターニャ。

そして仲間たちで正面(現実)を直視しているのはゼートゥーアさんだけで他はみんな別の所向いていますね。ちょっと象徴的じゃないでしょうか?#幼女戦記 pic.twitter.com/A0fJ9RBfbx

別にそれがメインテーマというわけでもなく、厚く描写する必要もないというのはあるのですが、それでも随所にそういうシーンがちりばめられてる感じがとても良いです。

部下にぶっ殺された前世のおっさん→部下を信頼し、部下も信頼を預ける"ターニャ”への変容はコミカライズ版のこだわりのようにも感じますね。

(ただ、原作でここまでフォーカスされてましたっけ?原作との齟齬があるのであれば、それが致命的にならないかどうかは心配です。)

表紙の変異

ちなみに"表紙だけ"に着目すると、メアリーを除いて一番大きな変化があったのは16~18巻かなと思います。

幼女一辺倒だった表紙もついに変化の兆しが見え、18巻ではついにヴィーシャが登場しました。

ターニャしかいなかった表紙に色々な仲間が入ってくるというのは物語とのリンクを感じて良き。

ターニャ、というか中身のおじさんは前世を含めて友達いなさそうでしたが、今は同じ釜の飯を食べる仲間がたくさんいるぜ!

そして今回出てきたのは参謀本部の人たち。

メインで写っているキャラクターに着目するのであれば、ターニャ→+ヴィーシャ→+参謀本部という流れであり、これもよいなぁと思うわけです。ラインから時系列でターニャの仲間になっていったキャラクター集合!ですね。

そう考えるとメアリーが表紙の巻はかなりイレギュラーでした。

自分の印象としては美しくないのですが、メアリースーの名を冠するキャラクターの挙動としては寧ろ美しすぎるとも言えます。(笑)

メアリー・スー(二次創作用語)

二次創作において、原作のキャラクター以上に活躍するオリジナルキャラクターなどを意味する。 二次創作内で理想化された原作キャラクターを指すこともある。

ちなみに、、、ターニャが活躍する舞台は戦場です。どこにいっても血まみれ。事態の暗転も好転も血を流す人間が変わっただけとも捉えることができます。

そんな皮肉が戦争を扱う本作品にはあっているなと思います。

中隊長たちの日常

乾杯!

自分もちょうど冬休みに入ったところなので、にやにやしながら読んでました。

塹壕ほりをするところはうわぁありそう。なんて。たぶんこの人らは塹壕ほりしかしらないんですね。

我々研究開発の人間も飲み会では焼酎の水割りを作るときにエタノールと水をうまく分散させる方法を話したり。キャンプに行ってペグをPEG(ポリエチレングリコールという化学物質/ペグと読む)wwなんていうターンが必ずきます。

遊び方を知らない人間たちをうまく書いていました。

というか、ヴィーシャは原作からしてしょうがないけどさ!ポニテロッテさんは!?

※もちろん水着のこと

ヴィーシャvs. ヴァイス

↓

ここらへんは素直に面白かったです。

ヴァイスさんは中隊長トップなんですがイマイチキャラがたっていませんでしたので、ヴィーシャに失礼な物言い→復讐されるヴァイスというお約束で目立ててきていますね。(笑)潜水艦でもこんな感じでした。

主役級の扱いを受けることができるこの二人が絡みだすと、他の中隊長も絡みだすコマが出てくるのがポイント高い。漫画の”コマ”を与えられるのって参謀本部、マッド、大佐、ターニャに加えてヴァイス/ヴィーシャですよね。だいたい。

ヴァイス/ヴィーシャが個人的な話を始めることで中隊長もそこに絡みだし、彼らの日常(個性)というまた違った切り口が得られるのは新鮮で良いです。

さらにこの絡みがいいのはヴィーシャのいろんな顔が見れるところ。

ターニャさんは顔芸しかしないし、本作品のかわいいはヴィーシャさんが担っていますのでこれは重要です。ヴァイスさんは勲章ものです。

どうしてこうなった!

さて、本編の中核とも言うべき、「勝利の使い方」。

口火を切ったのはまさかのギャグ!無表情ターニャかわいい。おじさんのことを可愛いと思ったのは初めてかも。

今何といった?ビアホール?

それはなんだろうか

ビアホール

それはお酒を飲むところだ

1ページも使ってビアホールに思いを馳せているので、シリアスな笑いというやつがツボにはまりました。(笑)

「それはお酒をのむところだ」・・・ターニャの混乱っぷりがよく現れていますね。

それを言葉にする必要はない

20巻できれっきれだったのはゼートゥーアさんとの対話です。

幼女戦記は「どうしてこうなった」というものを多用してきました(特にアニメ)。

順風満帆かと思いきやあらぬ方向に叩き落されるターニャそれ自体が笑いの起点でもありますし、無理な話の転換もギャグとして扱うことでスムーズになるからだと思っています。

どちらにせよ、「どうしてこうなった!」というのはストーリーの外側から話を飾るためのメソッドであり、その結果キャラクターが「どうしてこうなった」となるわけです。

ゼートゥーアさんとの対話に戻ると、二人の意思や手持ちのカードは以下のとおりです。

ターニャ:このままだと終戦はありえない。でも立場上進言できず、独断専行も悪材料。しかしゼートゥーアなら話が通じるはず。

ゼートゥーア:このまま終戦であろうと思っている。しかしターニャの真意が気になる。聞く気もある。話の焦点は独断専行なのか、戦略の錯誤なのか?

自分の解釈も入っていますが、なんとなく話し合いが成り立ちそうな要素ばかりじゃないですか?

なにしろ戦争の中核を担ってきた仲なんです。考えの中心点は異なっていても、考えの幅は重なってしかるべきです。

しかし、結果としては、、、終戦フラグというものがあれば、それを立てることはできませんでした。

ターニャがこの先を予測できているにも関わらず、話の焦点が独断専行についてではないというところに関しては暗黙の同意を両者ができたにもかかわらず、上の言葉は"how are you?"に近い枕詞であったにもかかわらず、ゼートゥーアが戦略的な錯誤について聞く気になっているにも関わらず。

状況的にベストコミュニケーションができる可能性があったにも関わらず、環境や手札(言葉)の切り方、前提条件が原因でワーストコミュニケーションになってしまいました。

こんなとき思いませんか。「どうしてこうなった」

幼女戦記はそのストーリー展開中でキャラクターが「どうしてこうなった」と感じ続け、その果ての結末として読者が「どうしてこうなった?」と思うわけです。

なんか凄くないですか。

コミカライズの凄いところはここを飽きさせずに読ませてくれたところです。我々読者にはすべての手札がopenになっており、なんなら原作も知っているので、ここらへんの展開は予定調和にあふれるものです。

それでも読みすすめているときはなんかドキドキしてしまいました。クライマックスに向けてちゃんと盛り上げてくれてよかった。

存在Xとはなにか

まじ悪魔だなこいつは。

祈りのために人の望む奇跡=終戦が叶えられることなく、戦争は局地での小競り合いから大国同士の争いにかじを切り、ついに世界大戦に向かいます。

物語を振り返ってみると、ターニャがいなければ世界大戦になっていなかったのでは?と思います。

彼女がいたからこそ95式、97式という傑作が生まれ、彼女の大隊が負け知らずになり、ノルデン攻略やフランソワの斬首作戦がなされました。彼女の戦功がなければ第一次世界大戦のドイツのように、ライヒはすでにジリ貧というか敗北していた(=この作中ではまだ合衆国の介入は小さい状態であり世界大戦になる前に終わっていた)のではないかと思います。

それではターニャはライヒの福音か?と言われるとそうでもありません。結局終戦には失敗しますし。むしろ戦う相手が増えていっています。

そして終戦の失敗はターニャが幼女だったからこそ起こったことでもあるんですよね。劇中でターニャが独白していたように、あと30年早く生まれていたりして地位をなしていれば終戦に向けて動けたことは間違いないでしょう。

存在Xがターニャを男ではなく、女子供として蘇らせた結果、戦争を終わらせることをできず人々は祈り始めました。

今の所、盤上をコントロールし、利益を得ているのは存在Xというナニモノかだけです。

世の中には強大な力をもつ○○が世の中を戦争に導いているんだ!という陰謀説がありますが、存在Xはそういった存在の隠喩なのかもしれませんね。

世界大戦

色々あった20巻ですが、最後はこの方で締めです。

俺たちの戦いはこれからだ!

凄く良かった20巻

#幼女戦記 最新刊凄い読みやすい

— 社会人はリラックスしたい (@kapVpjzVyO8N5Fl) 2020年12月25日

常々思っていたのですが、幼女戦記って話が単調になりやすいです。何しろだいたいターニャを中心に話が回るし、ターニャは真面目な軍人だし、軍人は戦争しかしていない。ずっと戦争の話だけで、閑話休題みたいな話題がなかなかないです。

これまではターニャ好き好きウーマンヴィーシャが”ターニャ目線での戦争”以外の話題提供の役割を担ってくれてきたと思います。今回は更にその輪の中にわがままボディさんが入ってくれたのが良かった。

どちらも立場的に中枢に非常に近いとは言え、、、従うしかありません。あるいは受け身とも言えます。

彼女たちの視点は一般の兵のものであり、わがままボディさんはターニャ達を外から観察できる存在です。

ターニャ強い!ターニャ戦術顔最強!という同じ話題がテーマではあるのですが、いつもの参謀本部目線だけでなく、別の視点で見てもそのレアさがわかるというシーンでした。

こういうことがあることで、ターニャの"主人公さ"の縁取りに磨きがかかりますよね。

そして「殉教者よ、、、」という言葉は神を否定するターニャを信じるヴィーシャへの表現としては皮肉めいたものがあります。いい感じのストーリーでした。

追記してそこら編も語れたらいいですね(吸血鬼のとことか)。でもまとまらないような気もします。

20巻ではヴィーシャ周り以外にも、勇気ある一歩でストーリーに切り込んでくれたと思います。

上でちょっと書いた中隊長たちの話もそうですし、レルゲンとの話もそうです。ここではあまりみないターニャの顔やセリフが見えて新鮮な気持ちになりました。

戦争の行く末を語るターニャは最初自信満々に足を組んで座っていますが、どんどん小さくなっていきます。

相手との間に何かを置くのは典型的な自己防衛反応、あるいは他者との壁の構築です。思っている以上に弱気なターニャ。かわいい。そして次の日には自らを少女と言って、「自分は少女ではない!」と恒例の自己へのツッコミもありませんでした。

ターニャの参りっぷりがよくわかるシーンでした。

敵倒した!ばん!終わり!ではなく、敵を倒しても倒しても何も変わらない、変わるのは自分の中にある変わらないと思っていたなにか、、、

そんなしっとりとした雰囲気が幼女戦記に流れることはかつて無く、それこそが終わりの始まりを予感させてくれるよい最終巻(第一部)だったなという感想を述べて20巻の感想をおしまいとしたいと思います。

ちなみに20巻は限定版があったみたいです。コミック小冊子が欲しかったので電子書籍で買ったのですが、しょうがないのでアマゾンで買いました(笑)

9月に受注締め切りだったのですが、最近は販売から日が浅ければ割と在庫が残っていますよね。

一言コメント

これまで顔出しマンはあまりいませんでしたが、結構描かれていましたね(笑)こんなイケオジがいたのか!なんとなく若い人たちばかりかと思っていました。

これヴィーシャがターニャの水着をみたかったってこと?水着持ってないか別のコマも調べました(笑

ノイマンいいキャラしてる。

電子書籍の弱点。文字が見れない。(笑)

ターニャさんかっこいい。

清潔感のためにも服用のブラシや毛玉取りを使おう ずっと使っているおすすめの紹介

ツイッターでブラブラしてたら下記のものを見つけました。

服の手入れにブラシを使うと長持ちするし高見えするよ!って内容で、凄い反響だったようです。

【うさぎ】セーターとかならできた毛玉もブラシかけるとある程度取れます。 pic.twitter.com/NrxO8tRanj

— うさぎのみみちゃん😇『自己肯定感の低いワタシちゃん』発売中 (@usagitoseino) October 13, 2020

自分は包丁を研いだり、ものをメンテナンスするのが結構する気なのでずっとやっているのですが、反響の大きさを見るとあんまりやらないのかな?と思ったのでブログで紹介しようかなと思いました。

えーブラシだけでそんなに変わるの?ブラシメーカーの陰謀では?と思う方もいるかもしれませんが、自分はそこそこ効果があるのではないかと思っています。

ツイッターで見かけた下のようなやつは流石にプロでは?と思ってしまいますが、やっている人はやっていることかなーと。

ファオタや主婦にとっては当たり前でも、やらない人はやらない服の手入れ。

— 南無三 (@p_namafoot) November 22, 2018

例えばUNIQLO綿90%カシミヤ10%のニットがシオシオになっても、1〜5cmアイロンを浮かせながらたっぷりスチーム当てて毛並に沿って優しく撫でる(これを『手アイロン』という)すると復活。乾かして馬毛のブラシをかけたら完璧。 pic.twitter.com/KdhbkdrZlm

ねえ無印ですごいの見つけた…羽毛立ちで瀕死のコートとニットを生き返らせる魔法のブラシ…新品同様になるんだが…これが690円って値段バグか? pic.twitter.com/VMweozbqNW

— 𝒽 (@_6u6mn) December 19, 2020

こういう服の手入れって人間の清潔感にも直結してくるところです。例えばスーツの肩にフケが落ちているおじさんとか男でもあれだなぁと感じます。

それは極端な例としても、個人を認識するときに人間の視界に入ってくる大部分は肌ではなくて服なんですよね。服もちゃんとケアしたほうが良いです。

今まさに婚活や異性との出会いの場がある方は是非取り入れてみてはいかがでしょう。

どんなものがよいかという点では、この漫画の作者さんは下記のブランドを使っているようでした。

カシミヤとかなら馬毛のTOYOBOSHI、ウールなら豚毛のDAILY BRUSHを使ってます。

— うさぎのみみちゃん😇『自己肯定感の低いワタシちゃん』発売中 (@usagitoseino) October 13, 2020

まぁこちらはお高いので、もっと安いのでもいいと思います。自分が使っているのはこちらです。

馬毛のブラシはスーツやニット、カシミア素材などデリケートなものに使っています。

しっかりとした毛がたっぷりと使われているので、お手入れがしやすく楽しいまであります。毛が少ないと狭い面積の手入れしかできないので手入れする気にならないんですよね。

東急ハンズでも扱っているくらいなので価格がお高めですが、手入れを楽しめるとブラシを買ったのに使わないということがなくなるのがいいですね。

英国御用達という宣伝文句もあるらしく(本当か?)イギリスの国旗もブラシに入っています。持ちやすくてそれだけで満足感のある商品です。

豚毛のものは無印良品の700円くらいのやつ。リーズナブル。

硬めのウールのコートやざっくりした素材のニットに使っています。とれにくい汚れはこちらのほうが取りやすい印象ですね。

ブラシの使い方は、ハンガーに掛けた状態で、まず下から上に、そして上から下に、が基本のようです。

あと、服の手入れに関して、おすすめしたいのがこちらの毛玉取り。

ブラシは毛玉ができるのを予防するためのものなのですが、毛玉ができてしまったときのものです。

ヤクでもアクリルでもニットの毛玉はこちらで除去しています。

使い方は色々で、気になるところをこれでなでたり、もっと乱暴に服を着ている状態で体を添わせたり。特に怪我したり、服に穴があいてしまったということはありません。

特に脇下とか腕周りは毛玉ができやすいので、これを使ってやるだけで中古感がかなり減るのがいいですね。

#ニュースリリース 9月20日発売

— マクセルイズミ (@maxell_izumi) September 6, 2019

8年連続シェアNo.1を誇る イズミ 毛玉取り器「とるとるシリーズ(全5機種)」マクセルイズミよりリニューアル発売

くわしくは当社ニュースリリースをご覧ください。https://t.co/dQy3l93Pvd

※.pdfが開きます pic.twitter.com/hurOWzAe0K

たぶん100均のものよりパワーがあるのですごく取れるんですよね。ブラシもそうですが、お手入れを楽しめるレベルでないと続かないのでちゃんとしたものを購入することをおすすめします。

本気の毛玉取り機…毛玉とるとる…

— カナリア (@kana_s_tw) February 11, 2020

めちゃくちゃスゴイから…1時間無心で家中の毛玉取っちゃうくらいスゴイから…もうダメだと思ってたコートも復活したから…全人類これ買って… pic.twitter.com/TBYsw87fWY

アマゾンではパクリ商品が色々機種が出ていますが、3~4年前くらいまで上であげたやつしかなかったと思います。個人的にはこういうものはオリジナル品を買うことを好みます。

やっぱりコピーしきれないノウハウみたいなものがあるので安物買いの銭失いになるのが嫌ですしね。頻繁に買い換えるものなら話は別ですが、一つかったら長年使えますし。

弱点はやはりなんだかんだニットの毛が減ってしまうことでしょうか。ただ、そんなにべらぼうに減るわけでもなく、自分としては教養範囲内です。

そして、女性向けを想定しているのかピンクしかないのがあれだったのですが、最近は色々なカラーがあって羨ましい。20代の頃はなんとなく恥ずかしく、友達に見られたくないのでクローゼットに封印していました。

以上、服のお手入れについてでした!

【日本株初心者】バリュートラップを回避するためにチェックするポイント

おもしろいつぶやきをみつけました。

PBR=PER×ROE

— 秋の味覚🍄ますたけ🍄 (@master_k1805) December 16, 2020

PBR=PER×ROE

大事なので2回言いました

ROE8%以下だと外国人に見捨てられるので低PER、低PBRで放置されます。ここテストに出ますから。 pic.twitter.com/Tquz0SKlWN

ちなみに自分の日本株の購入方針としては、①業界トップ企業、②中途半端な成長株を買うなら成長株より割安なものを選ぶ、③ネオモバイルで少しずつ買う、です。

必然的にそのタイミングで良さそうな大企業の株を拾っていくことになりますね。

半年くらいで利益は8%くらいでしょうか?

コロナで爆益を出している人に比べたら少ないですが、一方で米国の株価調整場面でも継続的に含み益を保てているのでまぁいいかなと思っています。

もちろん大企業を買うのが正解!とは思っていません。

むしろ日本は大企業は全然成長しておらず、新興の中小企業の方が伸びているという話もあります。

エムスリーとかすごいですよね。

ただ、すでに上がりすぎており手を出すのはなかなか難しいです。

入った途端下がるとか容易に考えられます。そのため、まだ回復が遅れている大企業を買っていっているわけです。

株の割安性は一般的にPER、PBRという指標が使われます。

利益や会社の資産と時価総額で割った値で、この値が少ないほど割安であると言えます。

ここで考えたいのはバリュートラップという現象です。

PER(株価収益率)やPBR(株価純資産倍率)など、株式投資において割安・割高を判断する指標はいくつも存在します。理論的には、割安な銘柄は株価上昇による水準訂正が期待できますが、割安な銘柄がいつまで経っても割安なまま放置される状態をバリュートラップといいます。

本来であれば、業績が変わらなくても株価は右肩上がりに推移するはずです。

なぜなら各国が金融緩和をすすめ、貨幣を増やしまくっており、貨幣の価値が徐々にさがっているからです。

穴のある論理ではありますが、値段据え置きで小さくなっていくクッキーとか見てると、100円の価値が下がってるんだなということは実感できることです。

しかし、バリュートラップにはまった株は株価が上昇しません。

これは避けるためにどうしたらよいのか?一つの指標が最初に言っていたROE8%以上のようです。

ROEというのはざっくりいうと利益率で、これが低いのはPERもPBRも低く、8%を超えるとPERやPBRは高いです。

つまり、買うべきはROEが8%以上であるにも関わらず、PBRやPERが低いものですね。PERが低いものは株価も低いので、市場の平均値に向かう、、、はずです。

【GU 2020AW】GUの柄ボクサーパンツって結構良くない?

朝っぱらからGUのネットショップで下着について調べている男。それは私です。

なんともうさんくさい導入なのですが、最近、GUのパンツの柄が結構良いなって思ってちょいちょい買っています。

今回はコスパ最強?のGUのボクサーパンツを紹介します。もちろんメンズ(男性)向け。

写真は特に記載のないもの以外はすべてGU公式からです。

例えばこれ、ペンギン柄。よくない?

あと狐。ぶどうがあんまり存在を主張していないのが良いですね。

落ち着いた色に細かい模様でなんとなく上品さを感じます。パンツだけど。

個人的にはワンポイントでも良かったんじゃないかなーと思いますが、大量生産でワンポイントというのは手間かもしれませんね。

柄物なら一つの記事を意識せずに縫うだけで良いですけど、ワンポイントだと場所を決める必要がありますし、縫製条件に縛りが生まれると布のロスとかが生まれそう。

今は在庫の入れ替えが起こっていますが、先シーズンは動物柄が多くあってよかったです。

他にも猫とか犬とか。GUの公式ページを見ても出てこないのでなかなか見つけづらくはありますが、店舗には置いてあるので気になる方はふらっと寄ってみるのもよいかもしません。

男なのに動物柄とか、、、!って方もいらっしゃるかもしれませんが、割と売れているように思う人気商品なんでそこは問題なし。

特に上に上げたペンギンのやつは色の珍しさも相まってサイズ切れを起こしつつあるようです。自分の近くの店舗ではXLしか残っていませんでした。

人気ある商品の残りかたって感じですよね。

もーないのー?ってがっかりする必要はありません。

今シーズンのものも割と良いです。

英字新聞!おしゃれっ!(笑

まぁ柄物のパンツをはくのは何歳まで?という話もありますが、基本的に人に見せるもんでもないですしそれならお気に入りの安いものを選びたいなと思います。

自分は動物が好きなので、上の動物柄のパンツはお気に入りです。

そもそもパンツってこれっていうのがないんですよね。ユニクロのエアリズムとかがおされていたりしますが、そんなにいいか?という1000円位するし。

それならこういうGUの安くて(¥500-くらい)気に入ったものを買うか、駅ビルに入っているような店で買うかなーというイメージです。

自分は無地か、それにワンポイントが入っているやつが好きかな。3000円くらいのパンツのくせに個包装されているブランド物のやつ。

とりあえず高いやつ3枚くらい持っていれば色々対応できる範囲が増えるはず。

ちなみに無地でもワンポイントでもないですが、一番反応があったのはこんなやつです。かわいい~~!って言われました。20代だったので赦されたのかもしれませんね。

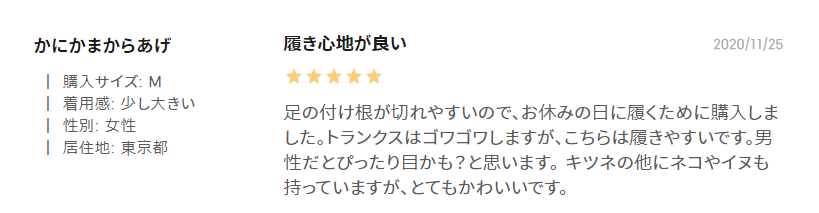

ちなみにGUの狐のやつは一つだけレビューが付いていて、それがなんと女性!

ボクサーパンツって調べると一緒にかわいい、も出てくるのでかわいいは重要なのかもしれません。

そんなパンツについての記事でした。

パンツまで気になるあなたは小物が好きなはず、ということで時計とか。

【GU 2020AW】MujiLaboのパーカーに似ているGUの安いパーカー【メンズファッション】

こんばんは、へるもです。

この秋冬はムジラボのパーカーを気に入って使っています。着心地の軽さが好きなんですよね。

以前、ブログでも紹介したのですがムジラボって地方民には厳しいものがあるんですよね。試着できないですし。

そう思っていたらGUで似ているパーカーを見つけました。これおすすめです。

ダブルフェイスビッグプルパーカ(長袖)

GUサイトより

ムジラボのパーカーと同じで軽くて大きめ、というのがこのパーカーのよいところです。

近年はフードを立たせた作りで小顔効果!っていうのがパーカーのお約束だったのですが、ちょっとずつトレンドが変わってきている感じがします。

さらに名前の通り大きめのサイズ感なので下に細いパンツやテーパードのかかったスラックスを履けばシルエットが簡単に整うのもいいですね。

日常使いでぱっと選んでぱっと着れるというのは強いです。

気になるのは素材感で、見たときはポリエステルのシャリシャリ感が強いかな?と思ったのですが、着てみると意外に気になりません。

これは艶だと言い張っても大丈夫なレベルです。たぶん。

ムジラボのパーカーと比べて差が大きく出のも素材かなと思います。高級感はやはりムジラボのほうが強い。

ただ、ムジラボのものは耐久力に難ありなのでその点を考慮すると全然ありかなと。

値段は1990円とだいぶと安いです。Tシャツかよって値段ですね。

色もベージュやグレーは淡い色なので春でも使いやすそうです。手持ちの服に合わせて選びたいところですね。

最近人気が出てきているようで、秋に見たときはそんなにプッシュされていなかったのですが、最近はBEST10に入っていたり。

GUは若者向けでしょって思う30代にもおすすめできる服だと思います。

個人的にはGUはユニクロより好きです。ちょっとしたサイズ感も、人間の似合う似合わないに大きく影響している気がしていて、自分にはGUがあっているのかな、と。

ユニクロより安い=若者向けなところがあって全部が全部着れるわけではないというのがアラサーの意見なのですが、これは普段着なら全然ありなのでは?

もちろん10代、20代にも全然おすすめできます。むしろ安くて手が出やすいのはこの層のはず。

Mujilaboは試着できないのは嫌だなぁ、高いのは手が出にくいなぁと思っている方がいたら是非試着してみてください。

G検定の受験者が増えているらしい。G検定を受けてよかったのか?

こんばんは。

G検定受験の申込みが開始されていました。

私が受けたのは7月だったので、はや3ヶ月。早いですね。

記事は会員しか見れないのですが、既存のIT資格の受験者は減っているのに、G検定の受験者が増えているという現象が起きているようです。

機械学習やAIに対する社会の関心の高さが伺えますね。

G検定を受けた直後はこんなん意味ねーよと思いましたが、今振り返ってみると受けてよかったなとも思います。

というのも、目標がないと仕事などで関係のある実利のあること”以外”の勉強をするのがなかなか難しいんですよね。

G検定をとってからの3ヶ月の間、仕事以外ではほとんど勉強していません。もちろんニュースサイトをみたりして情報収集はしているのですが、机の前で勉強するというのはやっていないな、と。

仕事とは直接関係のない勉強がどれほど重要かというのは人によって判断が分かれるところだと思いますが、私は結構肯定的です。

おそらく目的に応じた情報だけをとっていくということは今の時代とても簡単で、それだけをやっても人生は成り立つと思います。

それでもやっぱり基本は大事で、基本があるからこそ応用がしやすくなるのだと信じています。細部を分かっているからこそ何かを学ぶとき、話すとき、見るときに、自信をもってできるというのも精神的に大きいです。

過去を知らないと新しい情報に触れたときに「今こんな風になっているんだ」ということもわからないですし。

経験的な話なので説得力はありませんが。(笑)

そういった意味で、世の中の流れを1950年代の著名人の名前から2010年ごろのDLが花開くきっかけ位になったできごとまで勉強する機会になったG検定はよかったな、と。

G検定は目的ではなく、勉強する手段。そう思います。

最近の出題傾向が代わり、ここらへんを勉強しても意味がなくなりつつあるのは悲しいところではありますが、それでも勉強はしておいて損はないと思います。

あとは各種手法を学べたのもよかった。 おすすめはやっぱりこれですかね。前回紹介してから何冊か読みましたが、原理の説明とわかりやすさのバランスがとれており、ある程度網羅的に紹介してくれていると思いました。

勉強する上でこれが非常によかったです。おすすめ。

白本の技術的な内容(CNN, RNN, LSTM)に着目してもっと詳細に書いてある本です。「エンジニアなら」と書かれていますが、仮に皆さんが技術系でなくてもこれくらいは知っておいたほうがいいというぎりぎりを狙っているようにも思います。

ちょっと細かくて眠くなる部分もありますが、尤度って何?Qって何?という言葉だけ覚えて飛ばしてしまうような部分をもっと細かく解説してくれています。

こういう部分に着目する人というのはかなり原理にこだわる人なので、そういう人から学ぶのが一番です。

加えて、なんかチャラいんですよね。ところどころにマリちゃんを狙っているAIエンジニアの小話みたいなのが入っていてそれが箸休めにちょうどよいです。

G検定があると転職の有利になるのかな?と思って調べてみますが、相変わらず特に意味はなさそうですね。(笑)

そこらへんは期待できないように思います。

もし受験しようと思う方がいらっしゃれば、私がつかったチートシートをおいておきます。4問とかそれくらいの底上げになったという評価をいただきました。(笑)

今更フィットボクシング 3週目 コロナ太りからの脱却

こんばんは。

コロナで自粛していたら太ってしまいました。馬術にスノボに通勤に、特に意識してなかったですがあれらは結構な運動量だったのですね。

つい先日ゲオにスイッチが中古で売っているのを見かけたので購入してしまいました。中古なのに新品と500円しか変わらないというのは凄い話ですね。

購入したのはフィットボクシングとリングフィットアドベンチャーで、今はボクシングばっかやってます。

どちらもパッケージを買ったのですが、とにかく差し替えが面倒です。ダウンロード版を購入すべきでした。

ボクシングを選んだのは声優さんが豪華だからです。初期設定のキャラの声がよりもいのユヅキさんと同じ声だったのです。

まぁ聞き比べると違うんでしょうけど、細かいことは気にしない。

そんな不純な理由で選んだボクシングですが、いいですね。これ。そんなボクシング体験記をつらつらと書きます。

1日目

どれくらいの強度の運動をするか選べるので、ストレッチ込みの25分、バストアップを選びました。

ジャブ、ストレート、アッパー、フック、基本的な運動をやったように思います。左手がうまく使えません。自分の不器用さにびっくり。

20分くらいなんて流石に余裕でした。ストレッチも5分くらいするのめんどくせーなとおもっていました。この時は...

2日目

肩周りの筋肉がいてぇ、、、ような気がする。

3日目

肩が、、、肩がいてぇ。おじさんあるある2日目に筋肉痛が来るパターンでした。普通につらい。

運動が始まれば動けるのですが、体が縮こまっているのがわかります。これだけ体に反応が新たやり甲斐があるってもんです。

あれだけ面倒に思っていたストレッチが気持ちいいです。ストレッチさんは重要だったんだな。

1週間すぎたころ

肩の筋肉痛は発生しなくなりました。人間の適応力すげえ。あんまり使っていなかったから起こったのでしょう。

そのかわり背中がじんわり痛いです。肩甲骨周り。

ダッキングやウィービングが現れたのはここら辺です。これ苦手!どう動けばいいか分からないや。

ミスしても何がダメだったのか分からないのでいらいらがたまります。せめて早い遅い、動きが大きい小さいを指摘してくれればいいのになぁ。

2週間くらい

いまだにウィービングが苦手です。タイミングを合わせていれば多少の体の動きの雑さは問題ないので動きが適当になってしまいますね。

自分のキャラが動きをトレースしてくれるリングフィットの方がここらは分かり易いなぁと思いました。

3週間くらい

ボディ系やステップの動作が入ってきました。

時々うまくできないのでストレスがたまります。

あまりに同じ動きだと飽きてくるのですがやってるいるつもりでミスになる、というのが自分は苦手なようです。

これまでは飲み会の日は朝にやっといたのですが結局やる気にならず、連続記録が途絶えてしまいました。うーむ。

効果

体重の減少はみられません。

寝付きと寝覚めが良くなったように思います。

果たしてどれくらい継続できるのか!

【Mujilabo 2020 AW】Mujilaboは鉄板のパーカーとTシャツがおすすめ

MujilaboにユニクロUにこの時期はちょっと忙しいですね。秋冬ものをまだ暑い時期に選ぶのは少し違和感があって店舗に行くのも面倒に感じてしまいます。

ユニクロUは今回はパス、って感じでした。あまりおすすめできるものがありません。

コート類はちょっといいなと思うものがありましたが、コロナだし使わないだろうなと。

Mujilaboは去年の秋冬から出ているものが再販されていて、これは買いだ、と思いました。被るのですがもう一枚ほしいと思っていたのでこれを機に買い足しました。

無印良品週間が始まらないか待っていたのですが始まりませんでしたね。

おすすめ1つ目は「二重編みハイネック長袖Tシャツ ¥3990」です。

昨年も秋冬もので出てきました。ハイネックのものは秋冬しかでないようなので気になった方は要チェックです。

というか紹介がおそすぎて色欠けしているものもありますね、、、管理人はブラウンが好きです。秋だと着やすい。

この服のいいところはビッグシルエットでトレンドにあっているところと、ハイネックなので顔周りのバランスがよくみえるところです。

顔が小さくみえる効果があるのかは疑問なのですが、こういった装飾があることでTシャツ一枚できても様になるのが好きです。上にコートを着ても首周りにアクセントが出るし、タートルネックほど重くないので春まで使えるのもまたよし。

万能かというとそうでもなく、薄くてなめらかなので体のラインがもろに出るという弱点があります。乳首が見える。

気持ち悪いのでユニクロのエアリズムを下に来ています。縫い目のないタイプがおすすめです。

オンラインストアでも買いにくい商品になりつつありますが、店員さんと話してみたら少しずつ生産しているとおっしゃってました。

いつもは売り切れたらそれで終わりなので本当か?と思うのですが、去年も爆速で売れていたのでもしかしたら対応してきてくれているのかもしれません。

Mujilaboを扱っていない店舗でも取り寄せはしてくれるのでほしければ店員さんに話を聞いてみてはいかがでしょうか。

管理人はMujilabo取り扱い店舗に行くのが面倒なので近くの店舗にいって取り寄せてもらっています。

オンラインストアで売り切れていても他の店の在庫を確保してくれますし、5000円以下でも送料無料ですし、店員さんに話を聞けますし、結構好きな方法です。

おすすめ2つめは「度詰め裏毛プルオーバーパーカー S~M ¥6990」です。

ビッグシルエットでトレンドライクとか、ボックスシルエットで丈がちょうどよいとか、色々あるのですが、管理人が好きな理由はずばり「軽い」!

ユニクロにしてもチャンピオンにしてもフードパーカーはいかにフードを立たせるか、という部分に力点をおいてきました。たちが良いと顔が小さく見えて、シルエットがよくみえるからですね。

これには弱点があって、フードを立たせるためには生地をあつくしないといけなく、そうするとパーカー全体が重くなるのです。

管理人はこの重さが頼もしくもあり、苦手でもありました。秋だと暑く、冬だと(1枚で着るには)寒いからです。

その点、この商品は薄いので秋の早い時期から着れますし、冬も重ね着しやすいのではないかと。

単純に軽いのも好きなポイントです。

フードが立っていないとスタイルがよく見えないのでは、、、と思う人もいらっしゃるかもしれません。それは正しいと思います。

ただ、この商品はフード付きパーカーというよりはハイネックTシャツとかと同じカテゴリでみてやればいいのかな、と。なんだかんだフードがあるので案外様になります。

普通にスウェットだと休日かな?ってなっちゃう人には特におすすめです。

弱点は耐久性が低いところでしょうか。薄いのでどうしてもへたるのが早い印象です。特に裾。洗うときは洗濯ネットを使い、使えなくなるタイミングをきちんと見極めたいところです。

コーディネートはそれほど難しくありません。ユニクロの黒スキニーか、イージーアンクルパンツをはいて、黒い靴を合わせてやればそこそこ様になるかと。

TシャツだとやっぱりBeffyが好きですね。パーカーの下に半袖Beffyをあわせてやれば春~秋まで対応できますし、それにコートをきれば冬も対応できます。コートを脱いでも油断してないやつ!(笑)

ムジラボは苦戦しているように思いますが、それでも定番の商品はやはり良いです。

衣替えに合わせてみなさんもいかがでしょうか。

※画像はすべて無印良品公式サイトより引用しています。